Información general

Aquest llibre conté el recull de pràctiques ha realitzar a l'assignatura d'Administració i Manteniment de Sistemes i Aplicacions (AMSA). Aquestes pràctiques estan enfocades a l'administració de sistemes GNU/Linux, en concret, amb la distribucions AlmaLinux i Debian.

-

AlmaLinux és una distribució de GNU/Linux basada en Red Hat Enterprise Linux (RHEL) i CentOS utilizarem la versió 9.4.

-

Debian és una distribució de GNU/Linux utilitzarem la versió 12.5.0.

Continguts

- Instal·lació i Configuració de Màquines Virtuals.

- Scripting.

- Arrancada del Sistema.

- Sistema de Fitxers.

- RAID.

- Servidors.

Utilització

Es tracten de laboratoris pràctics resolts que us permet experimentar amb els continguts teòrics presentats a les sessions de teoria. Moltes comandes i configuracions es troben amagades inicialment per tal que pugueu intentar resoldre els exercicis per vosaltres mateixos. Si us trobeu amb problemes o voleu comprovar la vostra solució, podeu consultar la solució clicant al botó en forma d'ull 👁️.

Adicionalment, es demanara l'entrega d'informes per a cada laboratori. Aquests informes han d'intentar donar resposta a les preguntes plantejades en el context de cada laboratori.

Instal·lació d'una màquina virtual

Per a realitzar tots els laboratoris d'aquest curs, necessitareu una màquina virtual amb un sistema operatiu basat en Linux. En aquest curs us proposo utilitzar, dos distribucions molt populars per a servidors en entorns de producció.

-

Debian 12: Debian és una distribució de Linux molt popular i estable. És una de les distribucions més antigues i utilitzades en servidors. Debian és conegut per la seva estabilitat, seguretat i facilitat d'ús. És una excel·lent opció per a servidors web, servidors de correu electrònic, servidors de bases de dades i altres aplicacions de servidor. Concretament, utilitzarem la versió 12.5.0.

-

AlmaLinux 9: AlmaLinux és una distribució de Linux basada en Red Hat Enterprise Linux (RHEL). És una distribució de Linux empresarial que ofereix suport a llarg termini i actualitzacions de seguretat. Es una de les alternativa open-source de RHEL. Concretament, utilitzarem la versió 9.4.

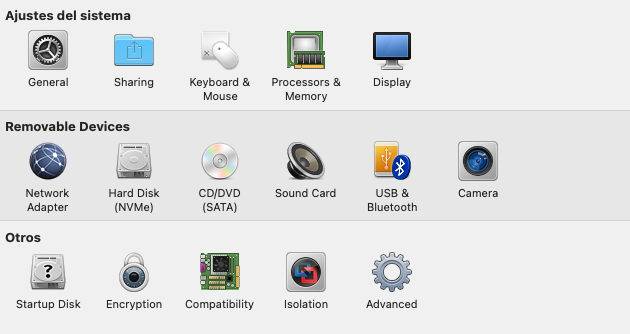

Software de virtualització

En aquest curs, us recomano utilitzar VMWare com a software de virtualització. VMWare és un dels software de virtualització més populars i utilitzats en entorns de producció. A més, VMWare ofereix una versió gratuïta per a ús personal i educatiu:

- Windows: VMWare Workstation Player

- Mac: VMWare Fusion

A més, VMWare funciona en les principals arquitectures de processador com x86 i ARM. Durant el curs, els exemple i el suport es basaran en l'ús de VMWare. Resta a la vostra elecció utilitzar un altre software de virtualització com VirtualBox, KVM, UTM o d'altres.

Tasques

- Instal·la un màquina virtual amb Debian 12.5.0 en mode text

- Informació bàsica sobre hostname i

hostnamectl - Informació bàsica sobre resolució de noms

- Informació bàsica sobre com connectar-se a una màquina virtual amb SSH i transferència de fitxers

Activitats

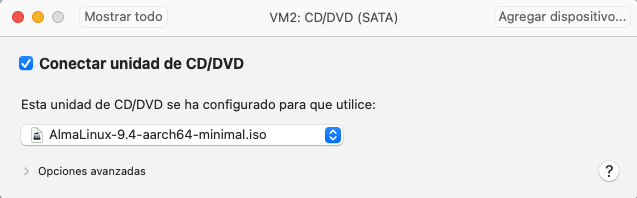

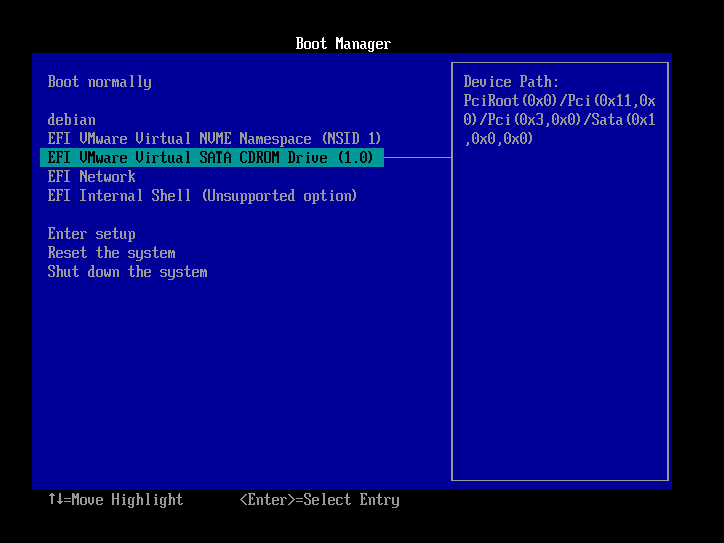

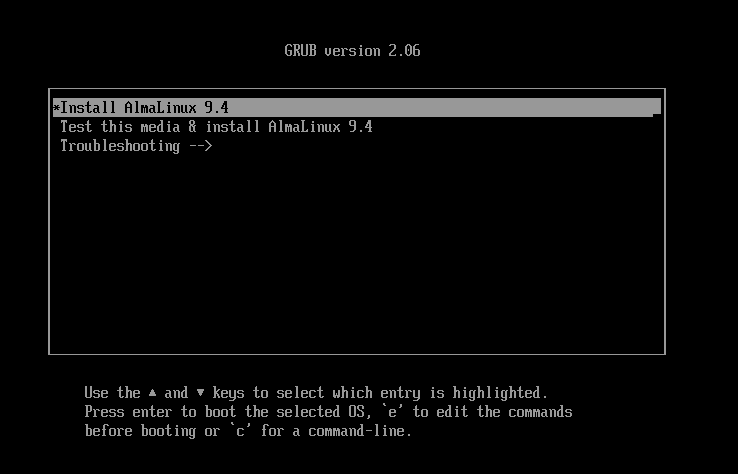

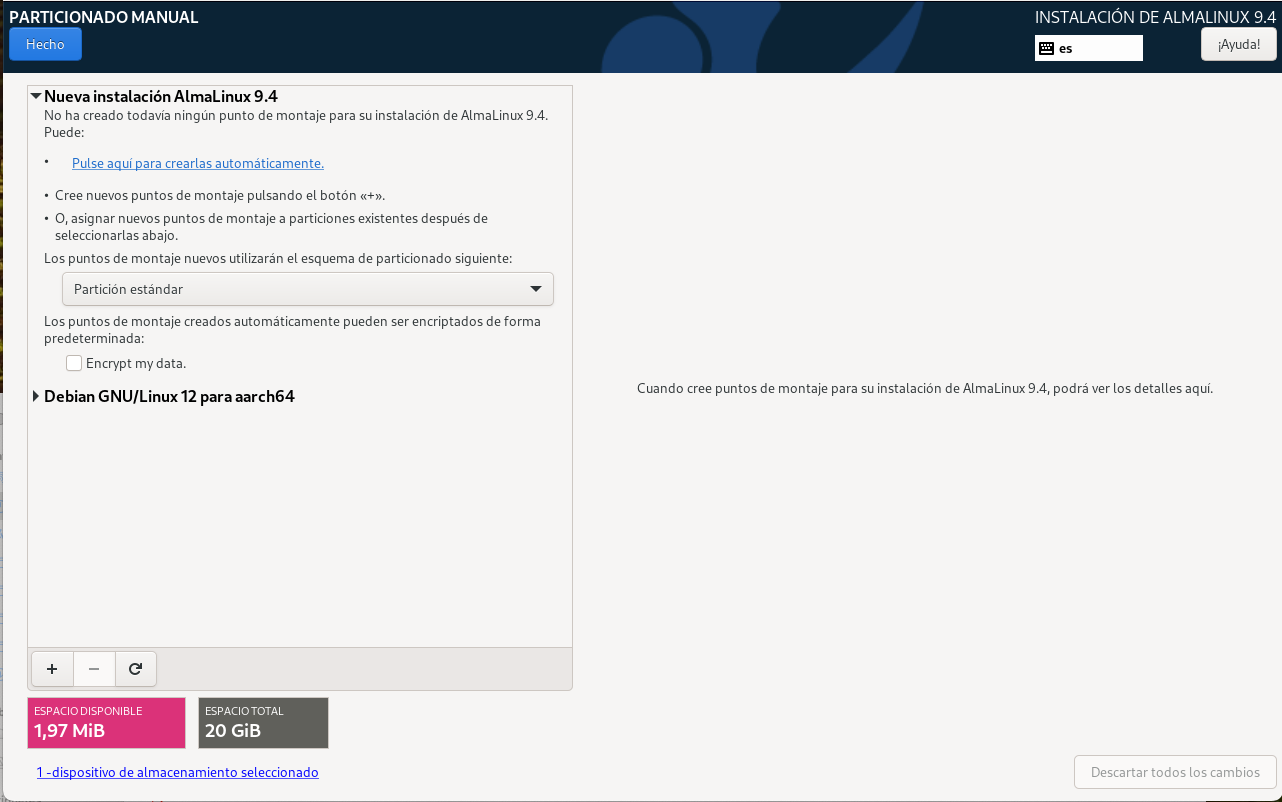

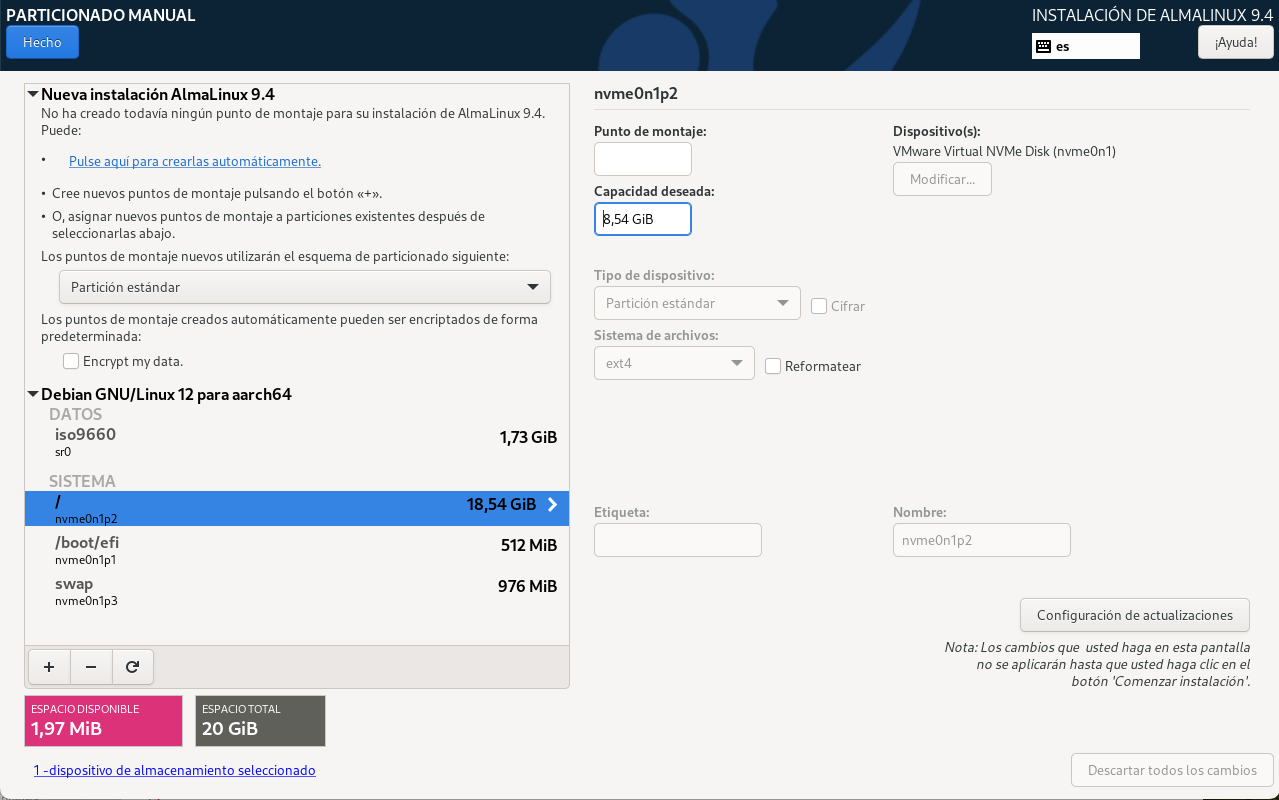

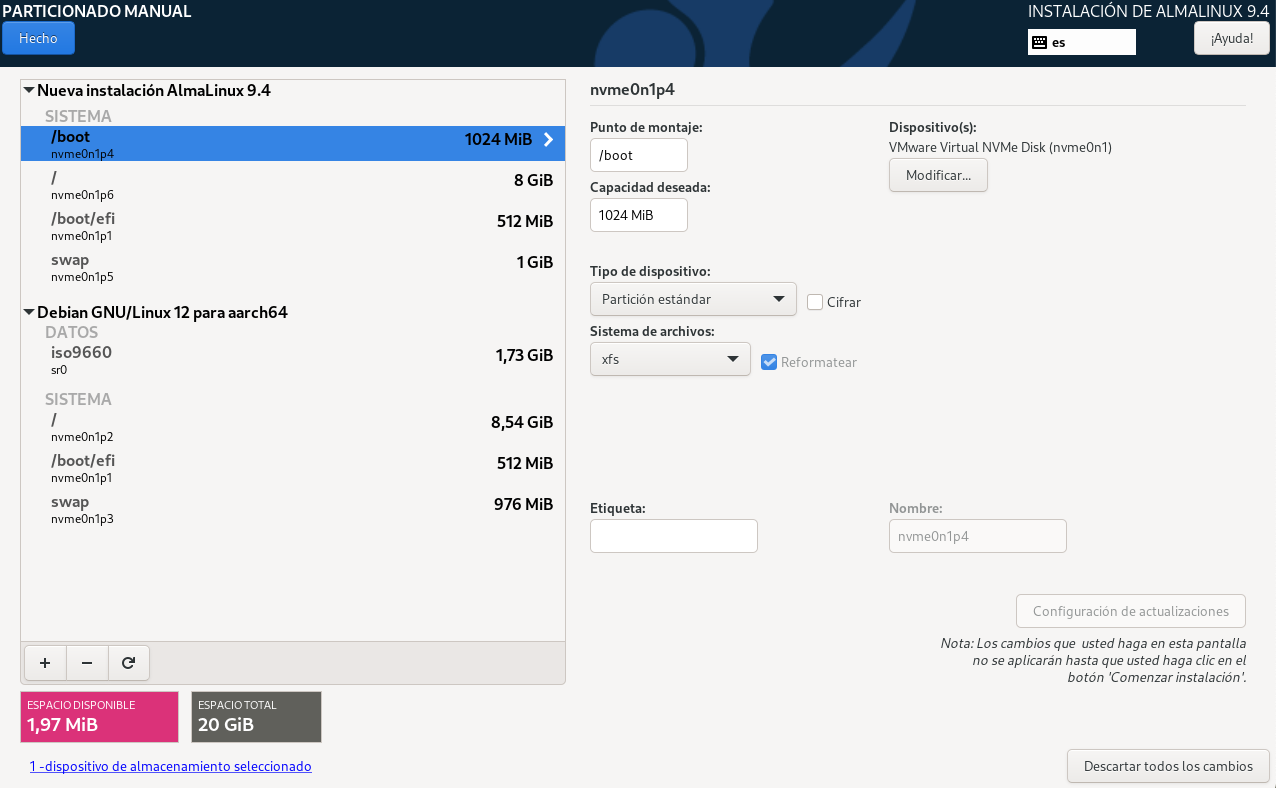

- Documenta el procés d'instal·lació de la màquina virtual amb AlmaLinux 9.4 amb una interfície gràfica.

- Descriu les diferències entre el procés d'instal·lació de les dues distribucions.

- Investiga com es pot crear un clon d'una màquina virtual amb VMware i documenta el procés. Comenta els avantatges i inconvenients de clonar una màquina virtual.

Rúbriques d'avaluació

Realització de les tasques: 100%

| Criteris d'avaluació | Excel·lent (5) | Notable(3-4) | Acceptable(1-2) | No Acceptable (0) |

|---|---|---|---|---|

| Contingut | El contingut és molt complet i detallat. S'han cobert tots els aspectes de la tasca. | El contingut és complet i detallat. S'han cobert la majoria dels aspectes de la tasca. | El contingut és incomplet o poc detallat. Falten alguns aspectes de la tasca. | El contingut és molt incomplet o inexistent. |

| Estil | L'estil és molt adequat i professional. S'ha utilitzat un llenguatge tècnic precís. | L'estil és adequat i professional. S'ha utilitzat un llenguatge tècnic precís. | L'estil és poc adequat o professional. Hi ha errors en el llenguatge tècnic. | L'estil és molt poc adequat o professional. Hi ha molts errors en el llenguatge tècnic. |

| Precisió i exactitud | La informació és precisa i exacta. No hi ha errors. | La informació és precisa i exacta. Hi ha pocs errors. | La informació és imprecisa o inexacta. Hi ha errors. | La informació és molt imprecisa o inexacta. Hi ha molts errors. |

| Organització | La informació està ben organitzada i estructurada. És fàcil de seguir. | La informació està organitzada i estructurada. És fàcil de seguir. | La informació està poc organitzada o estructurada. És difícil de seguir. | La informació està molt poc organitzada o estructurada. És molt difícil de seguir. |

| Justificació | S'han justificat les respostes amb arguments vàlids i exemples pràctics. | S'han justificat les respostes amb arguments vàlids. | S'han justificat les respostes amb arguments poc vàlids. | No s'han justificat les respostes. |

| Expansió | S'han ampliat les respostes amb informació addicional rellevant. | S'han ampliat les respostes amb informació addicional. | S'han ampliat les respostes amb informació poc rellevant. | No s'han ampliat les respostes. |

| Suport gràfic o audiovisual | S'han utilitzat recursos gràfics o audiovisuals per aclarir la informació. | S'han utilitzat recursos gràfics o audiovisuals. | S'han utilitzat pocs recursos gràfics o audiovisuals. | No s'han utilitzat recursos gràfics o audiovisuals. |

Instal·lació del sistema operatiu Debian 12

En aquest laboratori, instal·larem el sistema operatiu Debian 12 en una màquina virtual i descriurem els components principals del sistema operatiu. Aquesta instal·lació és la base per a tots els laboratoris que realitzarem en aquest curs. En alguns, us demanaré que modifiqueu alguns paràmetres de configuració per adaptar-los a les necessitats del laboratori.

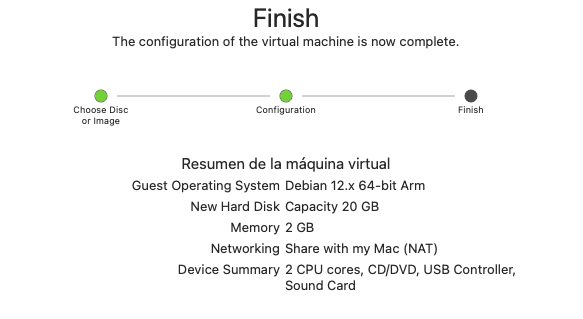

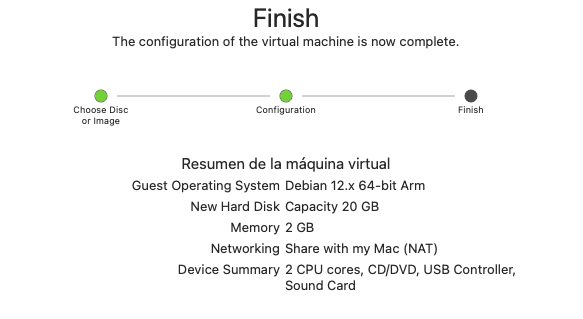

Configuració de la màquina virtual amb VMWare

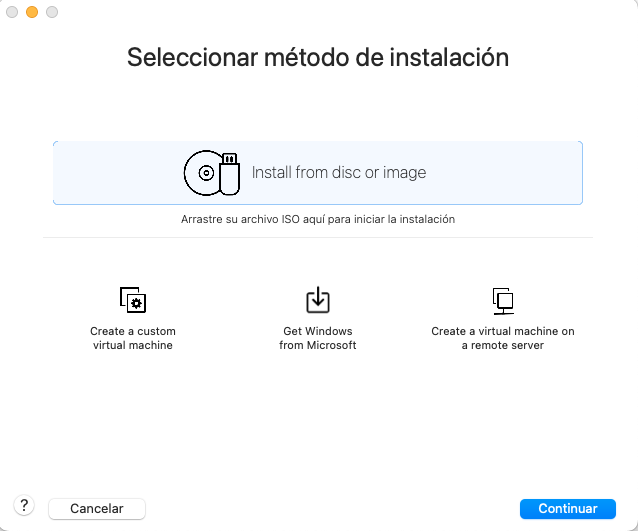

- Selecciona l’opció

Create a New Virtual Machinea VMWare Workstation Player o VMWare Fusion. - Selecciona Install from disc or image.

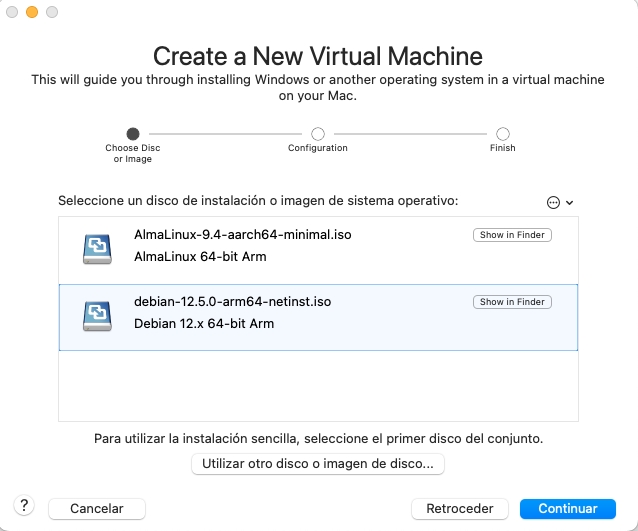

- Selecciona la imatge ISO de Debian 12.

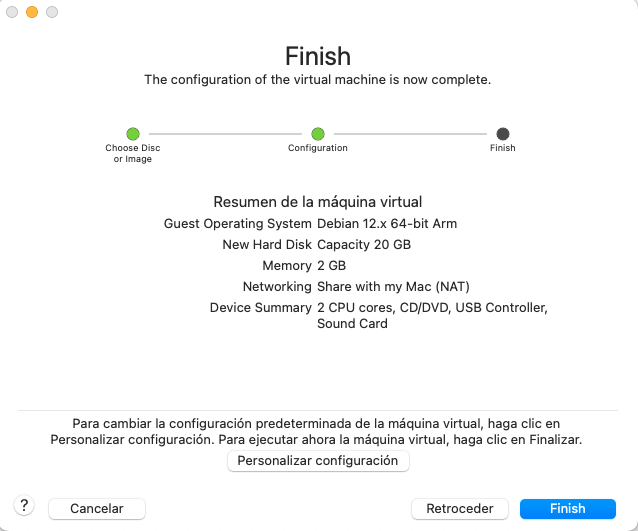

- Configura els recursos de la màquina virtual.

Instal·lació del sistema operatiu

-

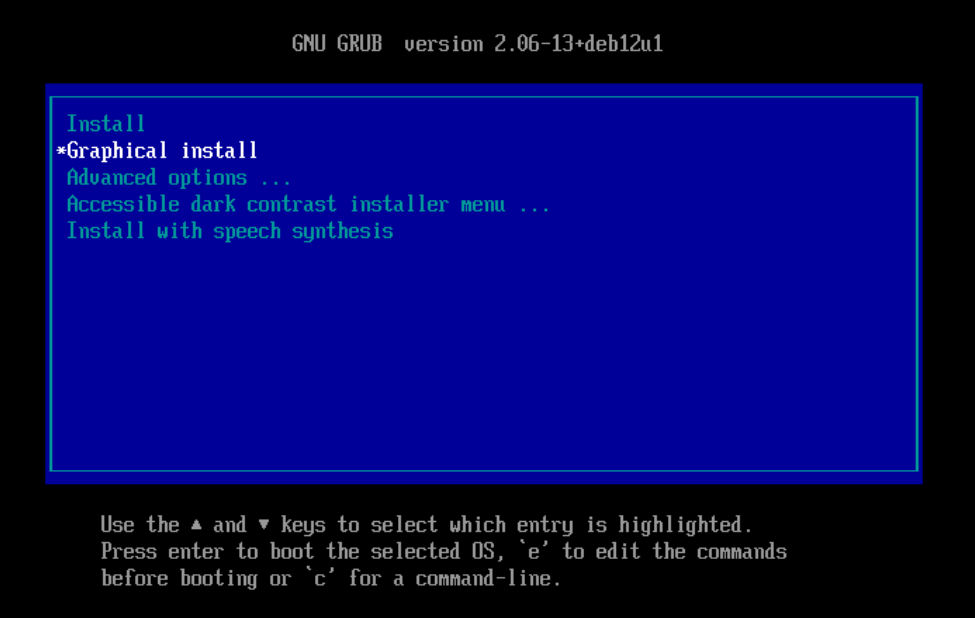

Un cop iniciada la màquina virtual, podeu seleccionar la opció Install o bé Graphical install.

En aquest tutoriral, seleccionarem la opció Graphical install per a una instal·lació més amigable. La principal diferència entre les dues opcions és l'entorn gràfic.

-

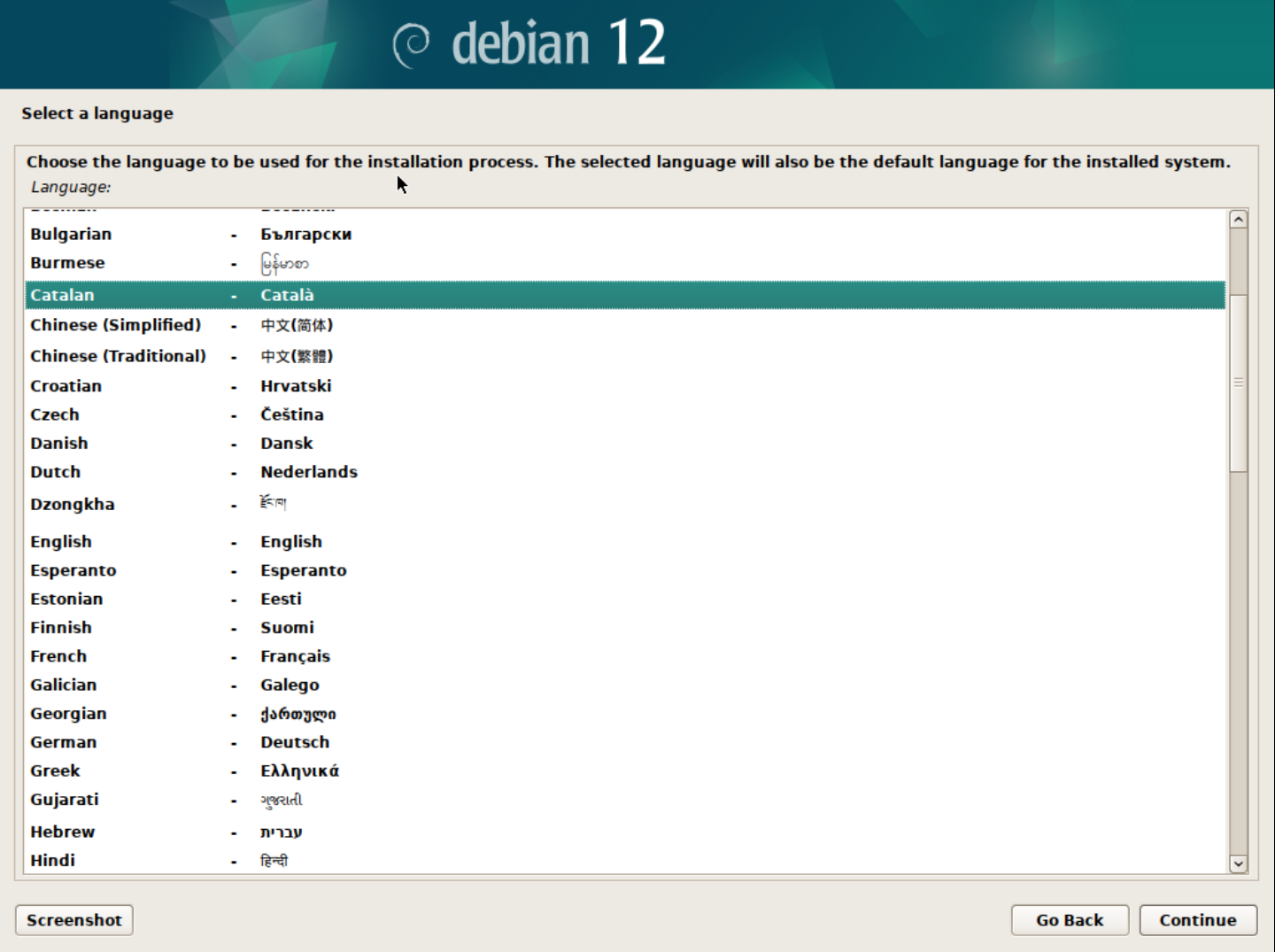

Selecciona l'idioma d'instal·lació.

Podeu seleccionar l'idioma que vulgueu per a la instal·lació. En aquest cas, seleccionarem l'idioma Català.

-

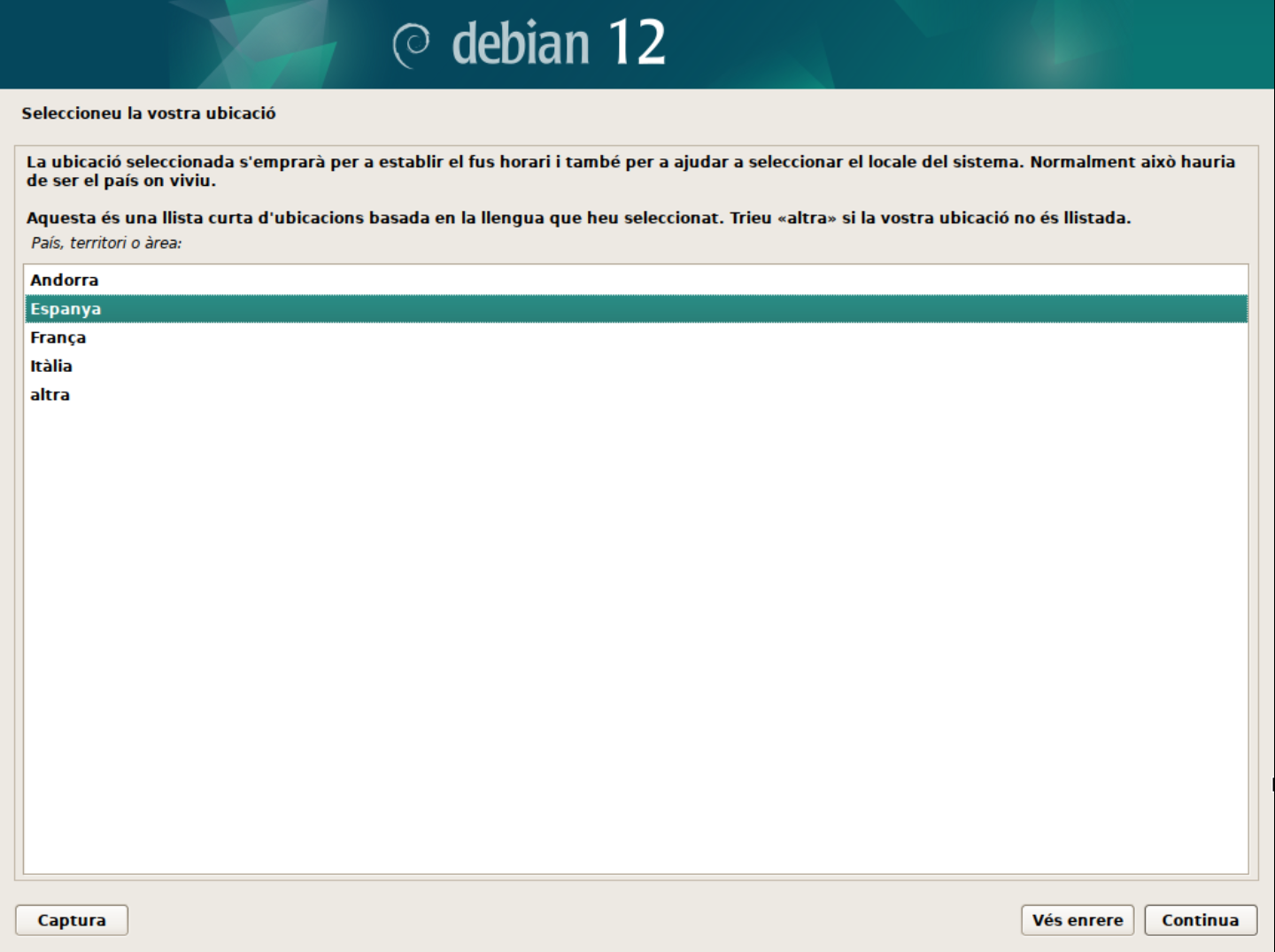

Selecciona la ubicació geogràfica.

En aquest cas, seleccionarem la ubicació Espanya.

-

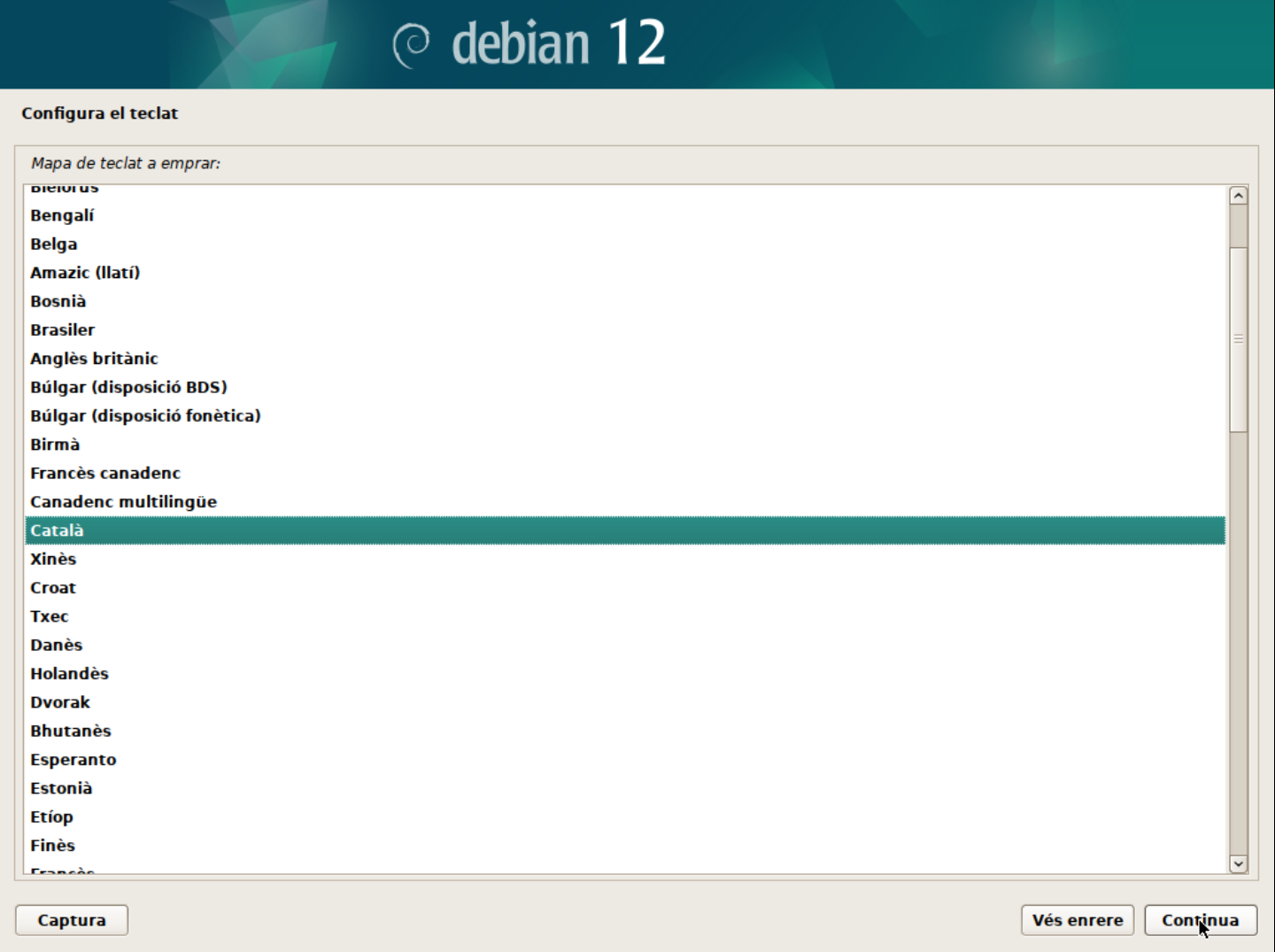

Selecciona la disposició del teclat.

En aquest cas, seleccionarem la disposició de teclat Català. Això ens asegurarà un mapeig correcte del teclat.

-

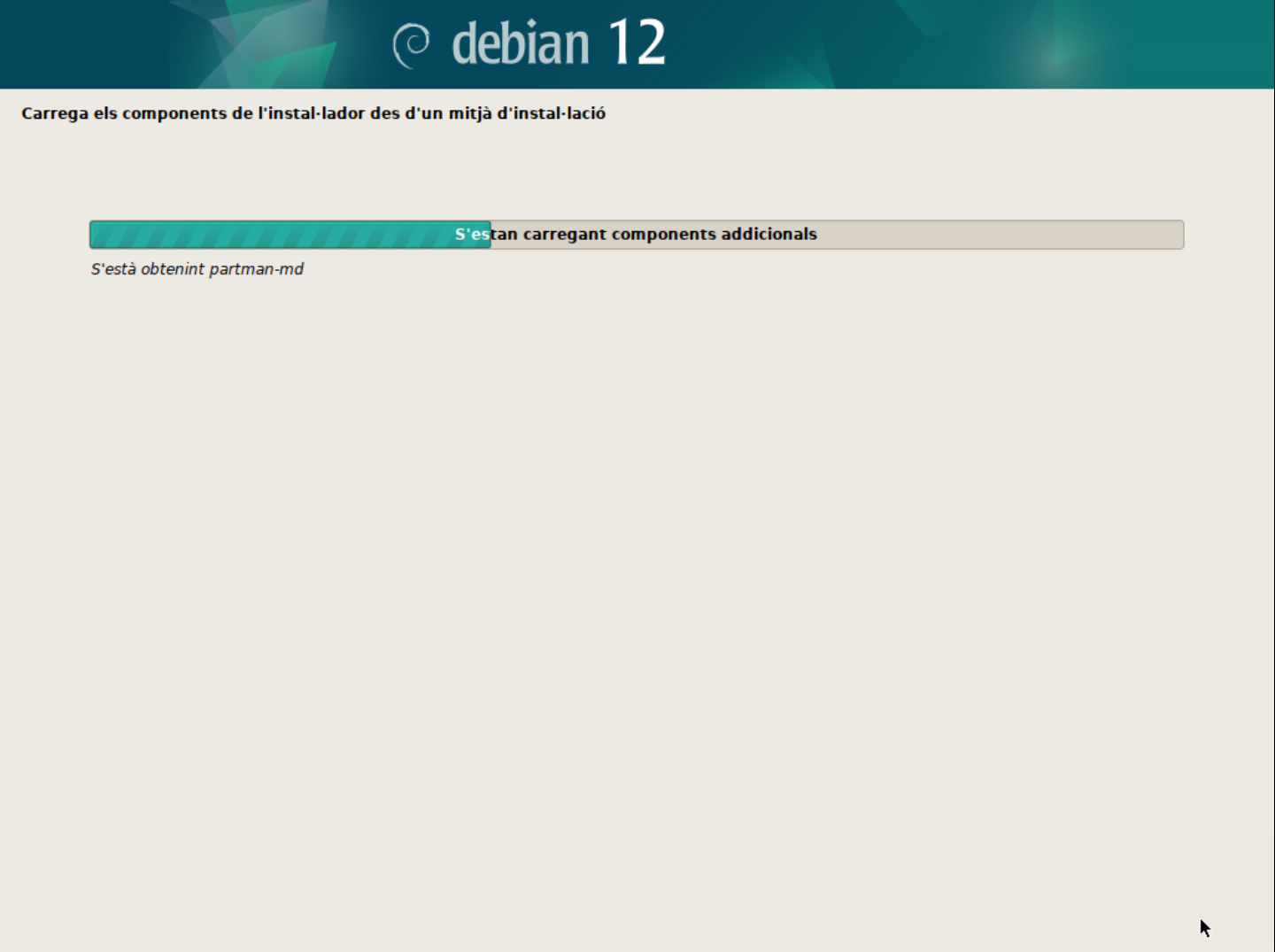

Espereu que el sistema carregui els components necessaris.

-

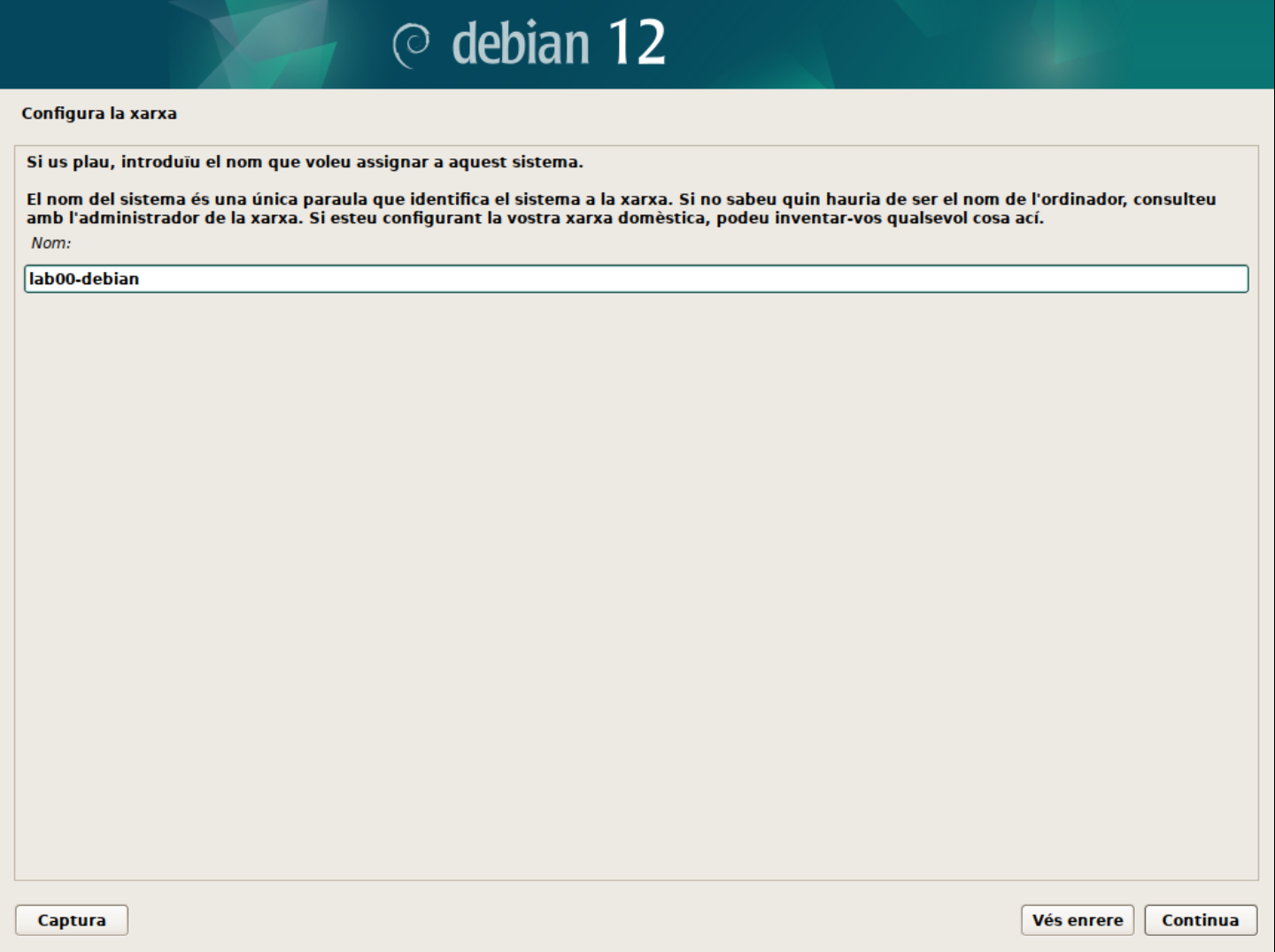

Configura la xarxa.

- El primer pas és configurar el nom d'amfitrió o hostname. Aquest nom permet identificar de forma única el vostre sistema. Podeu deixar el nom per defecte o canviar-lo al vostre gust.

En aquest cas, hem canviat el nom d'amfitrió a

lab00-debian.🚀 Consell:

Els administradors de sistemes acostumen a administrar múltiples servidors i dispositius. Per tant, és important identificar cada dispositiu amb un nom únic per facilitar la gestió i la comunicació entre ells. Per tant, us recomano que utilitzeu un nom d'amfitrió significatiu per identificar-lo fàcilment.

Us recomano un cop instal·lat el sistema que doneu una ullada a l'apartat Hostname per obtenir més informació sobre com gestionar el nom d'amfitrió.

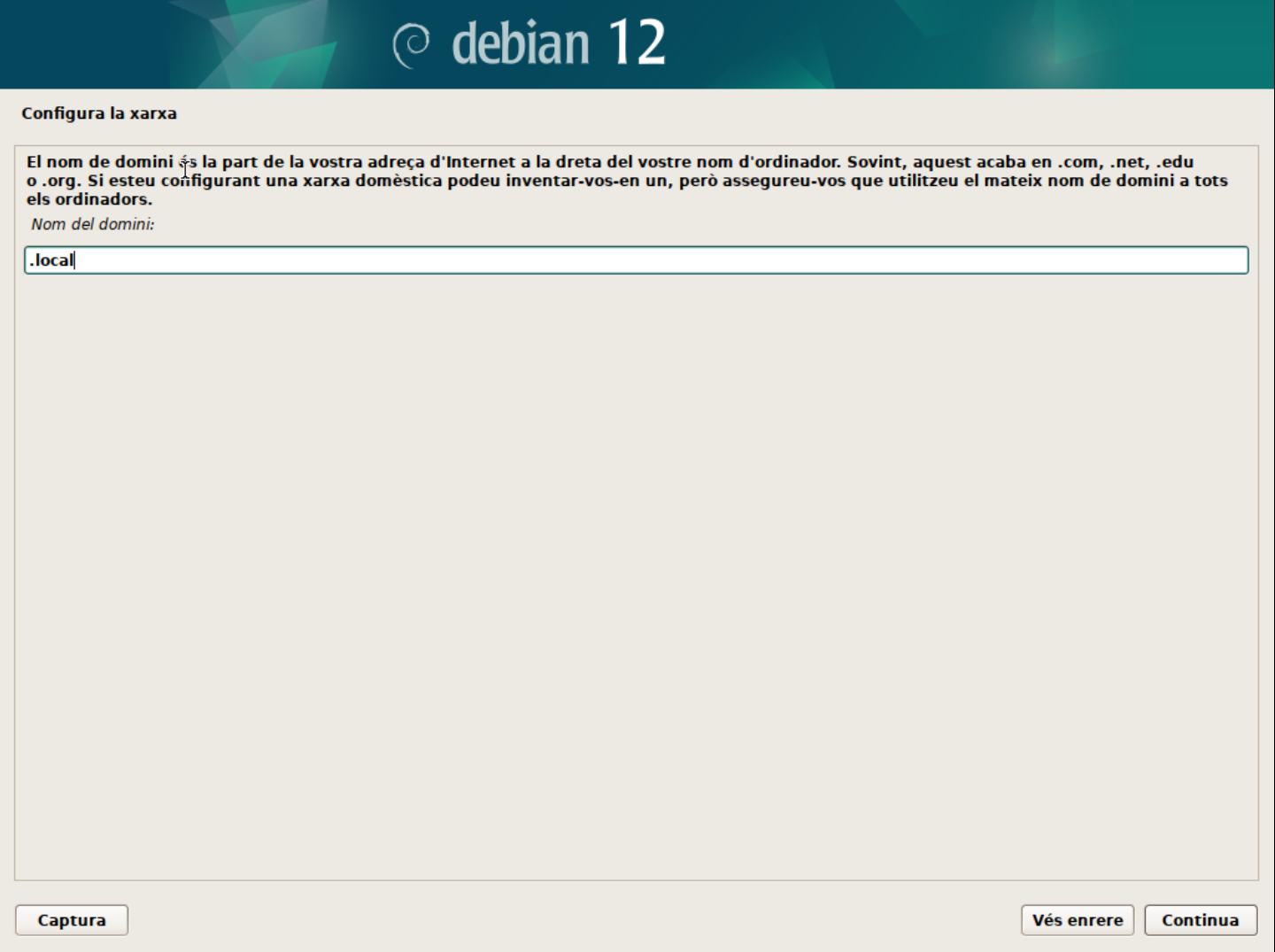

- El segon pas és configurar el domini de la xarxa. Aquest pas el podeu deixar en blanc si no teniu un domini específic. O bé, podem utilitzar

.localcom a domini local per identicar que el servidor pertany a la xarxa local.

💡 Nota:

En un domini empresarial, normalment s'utilitza el nom de domini de l'empresa. Imagina que aquesta màquina virtual és el servidor d'una base de dades mysql de l'empresa

acme.com. En aquest cas, el domini seriaacme.com. I el nom d'amfitrió podria sermysql01.acme.com. -

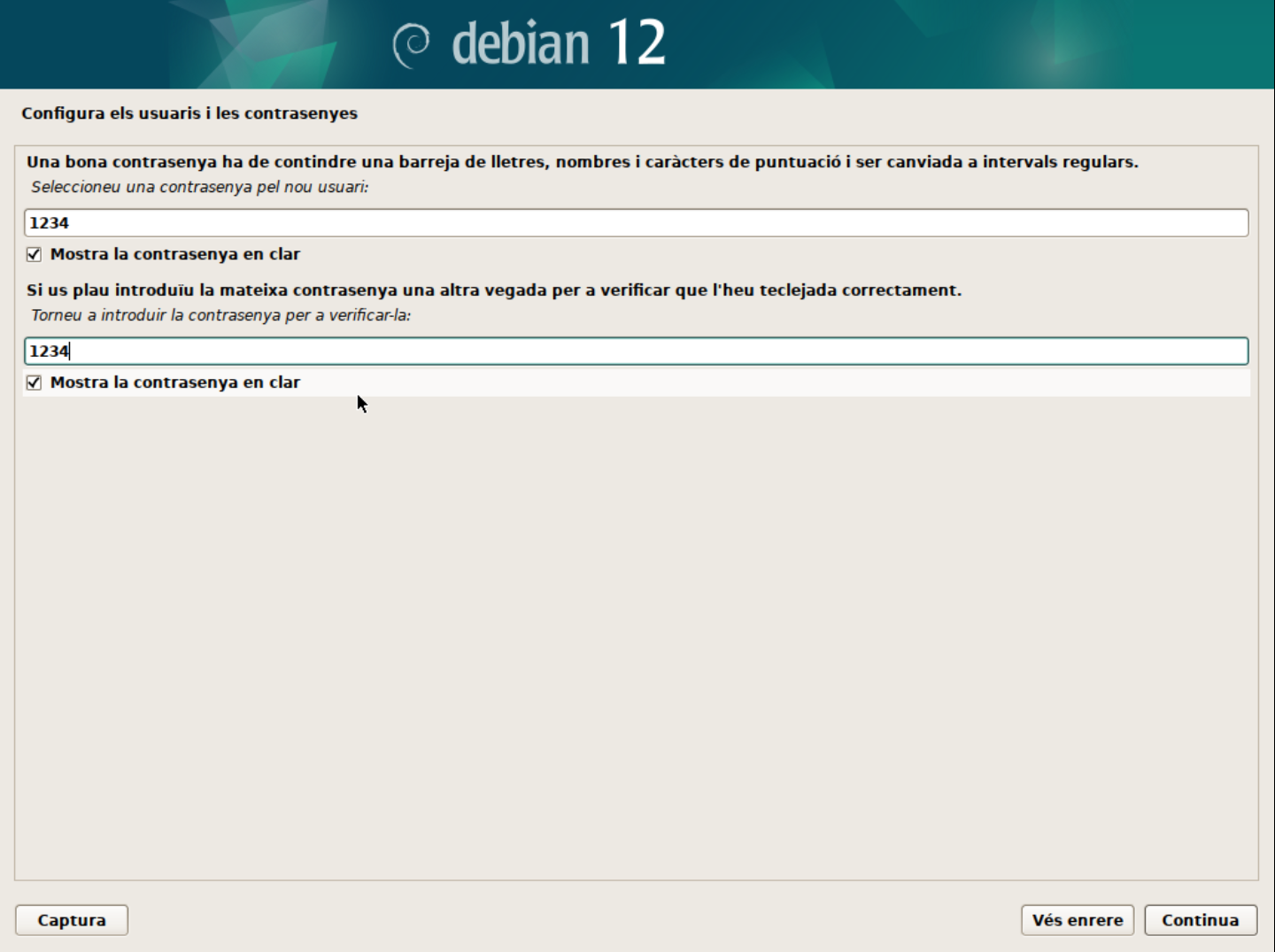

Configura l'usuari administrador.

En aquest punt, heu de tenir en compte que si no poseu cap contrasenya, es crearà l'usuari normal amb permisos de

sudoi això us permetra executar comandes amb privilegis d'administrador.Si poseu una contrasenya, aquesta serà la contrasenya de l'usuari

rooti no es crearà un usuari normal amb permisos desudo. I tampoc s'instal·larà el paquetsudo.⚠️ Compte

Com utilitzarem les màquines virtuals com a laboratoris de pràctiques, no cal que poseu una contrasenya molt segura. Podeu utilitzar una com a

1234. Però, recordeu que en un entorn real, la seguretat és molt important i cal utilitzar contrasenyes segures. -

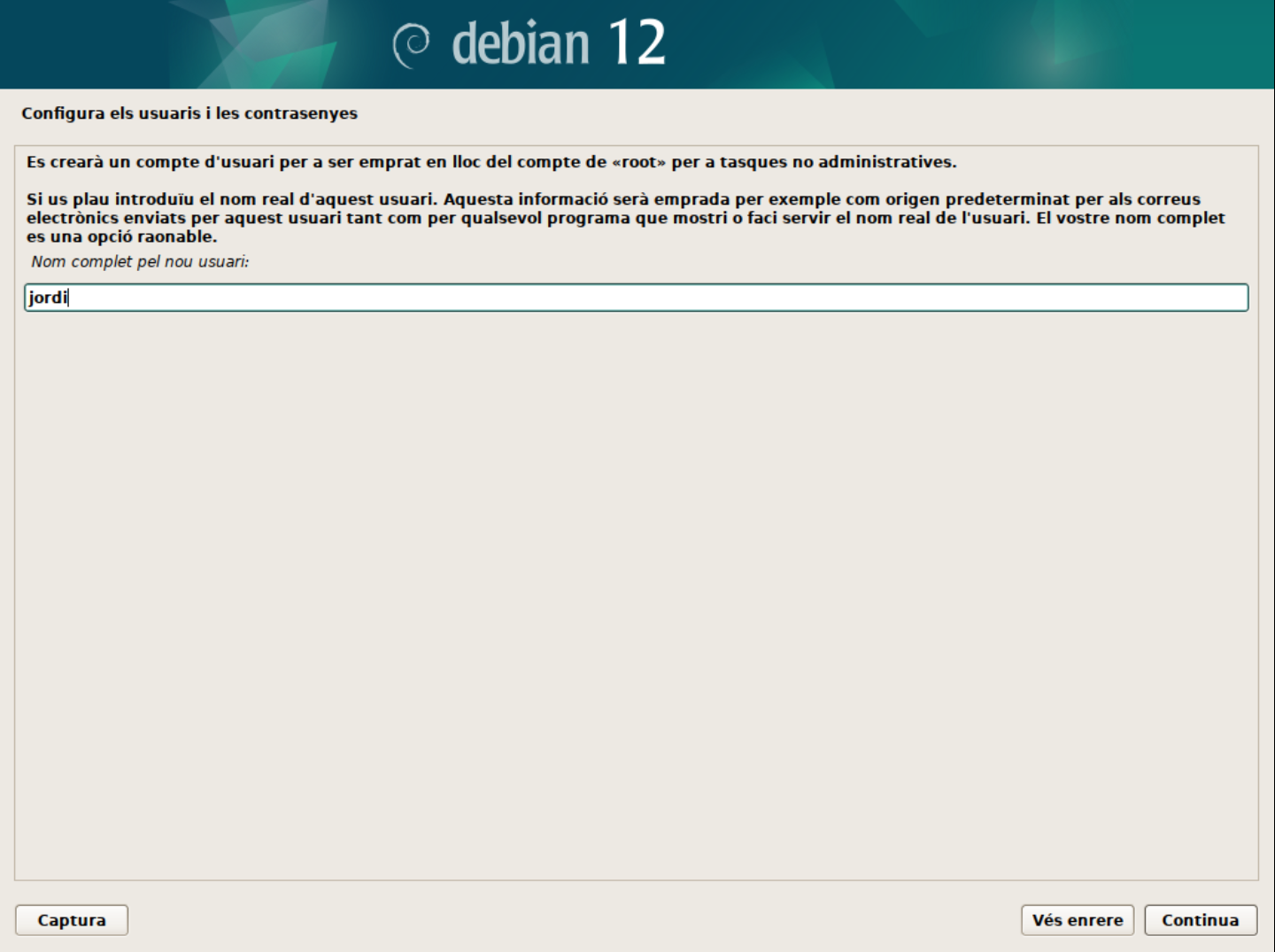

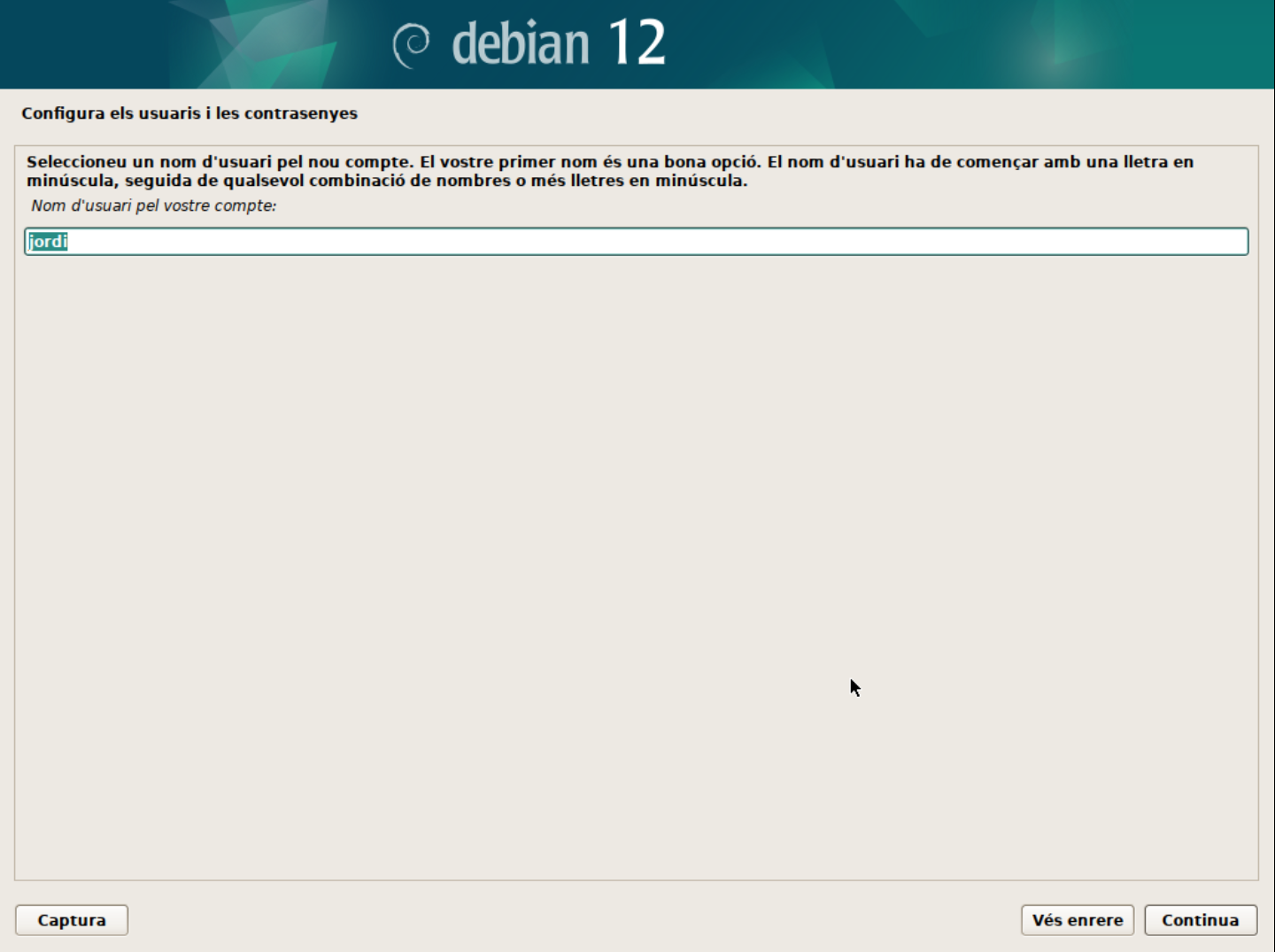

Configura un usuari normal.

- Nom complet: Podeu posar el vostre nom complet o el que vulgueu.

- Nom d'usuari: Podeu posar el vostre nom d'usuari o el que vulgueu.

- Contrasenya: El mateix que per l'usuari

root.

-

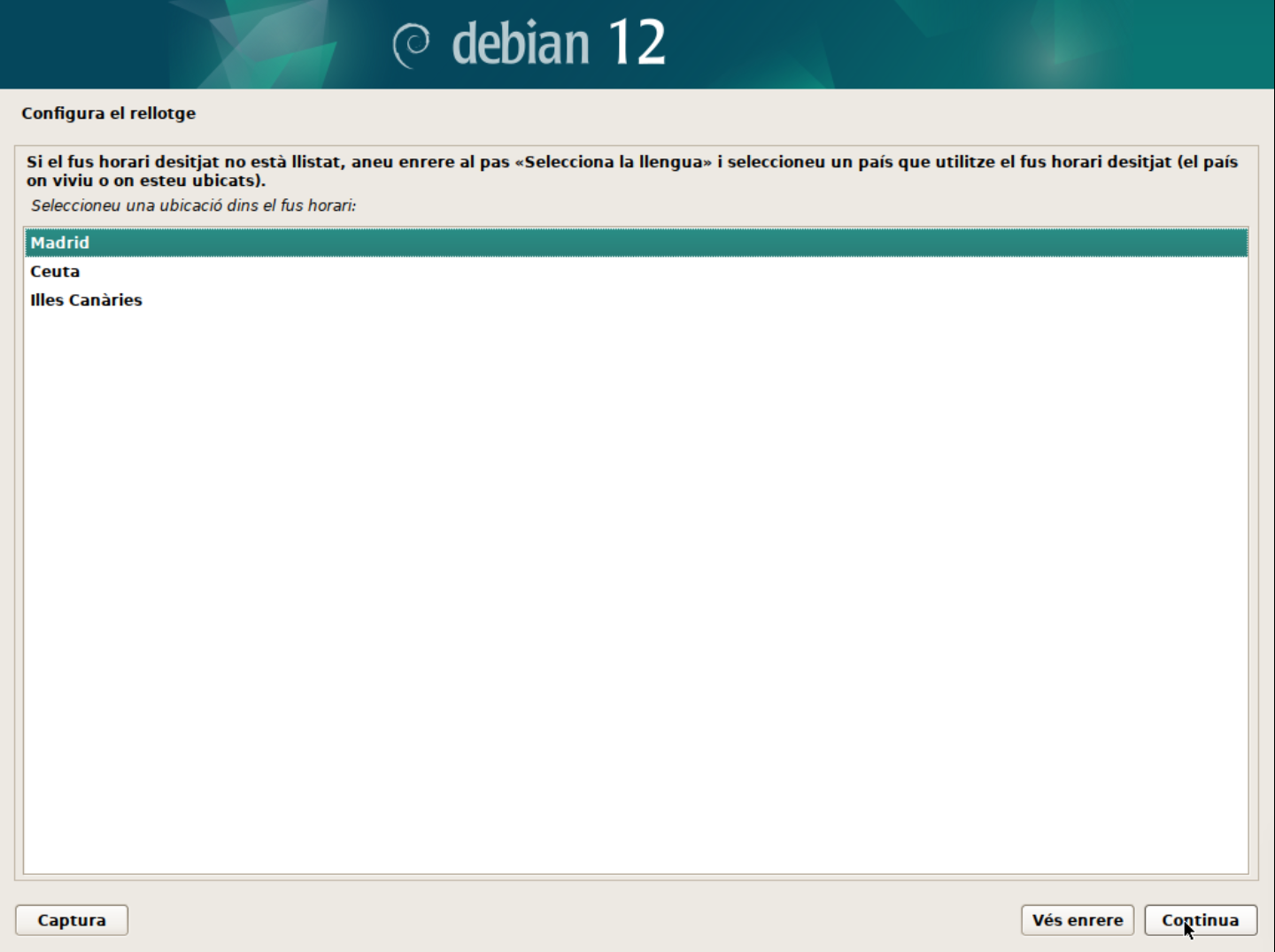

Configura la zona horària.

En aquest cas, seleccionarem la zona horària de Madrid.

-

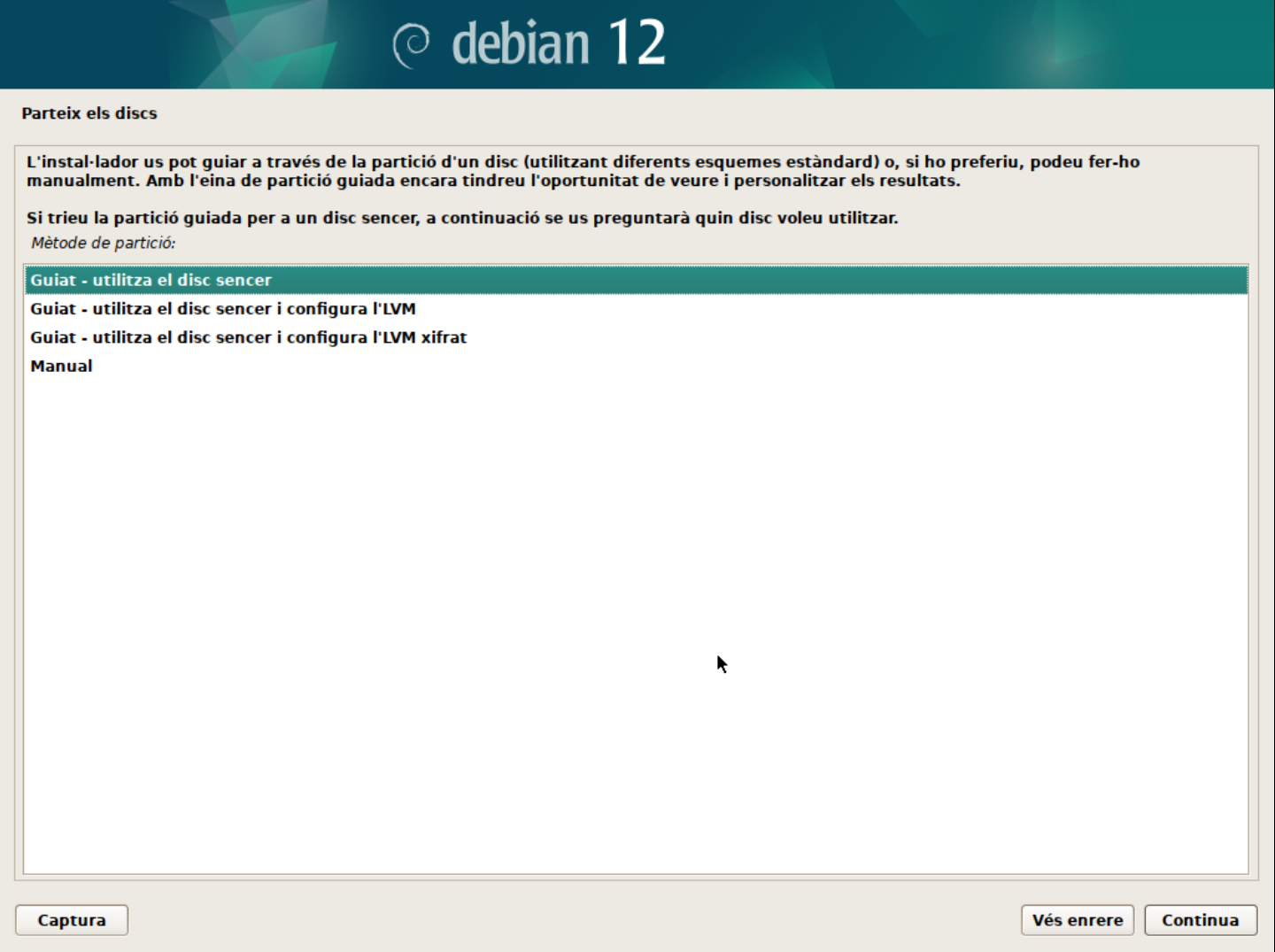

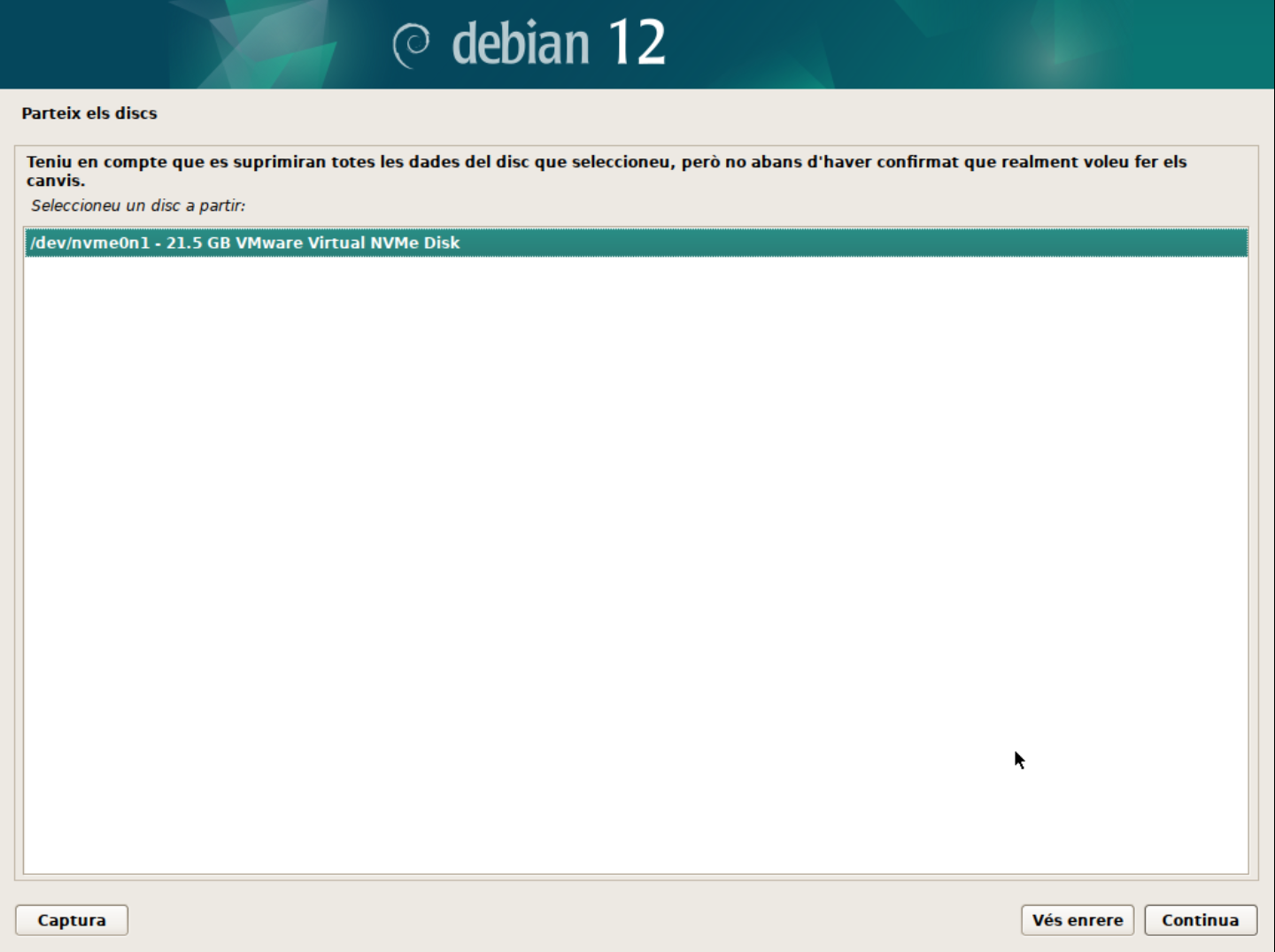

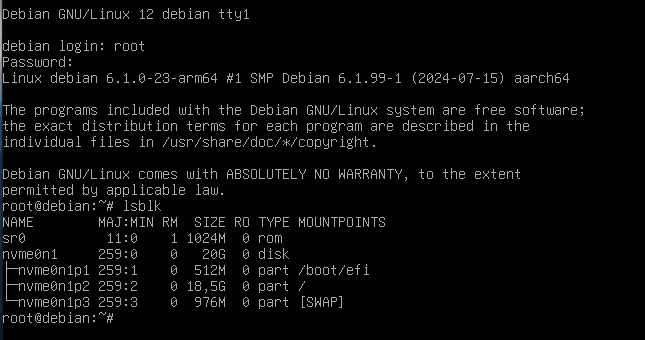

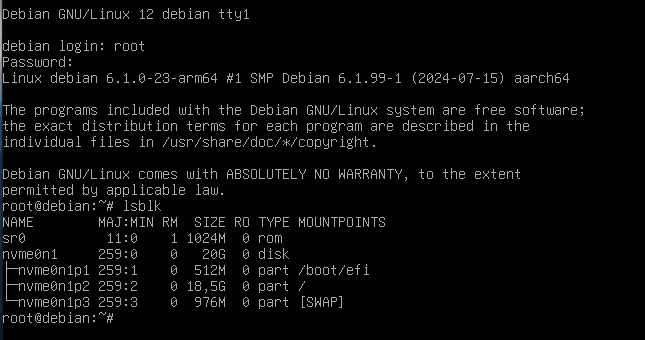

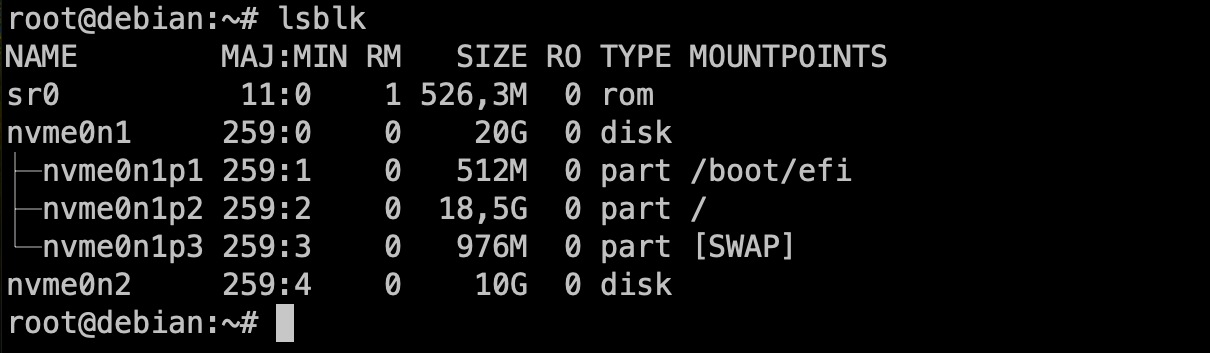

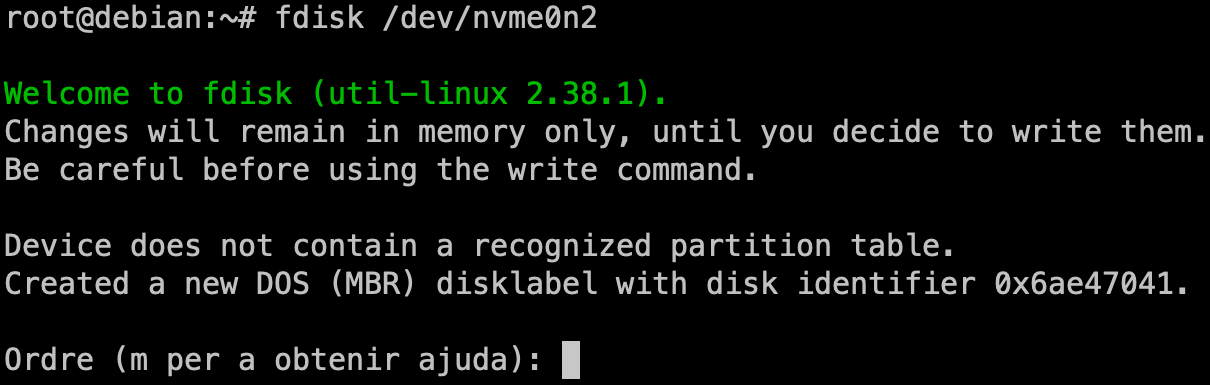

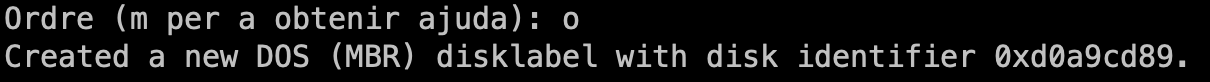

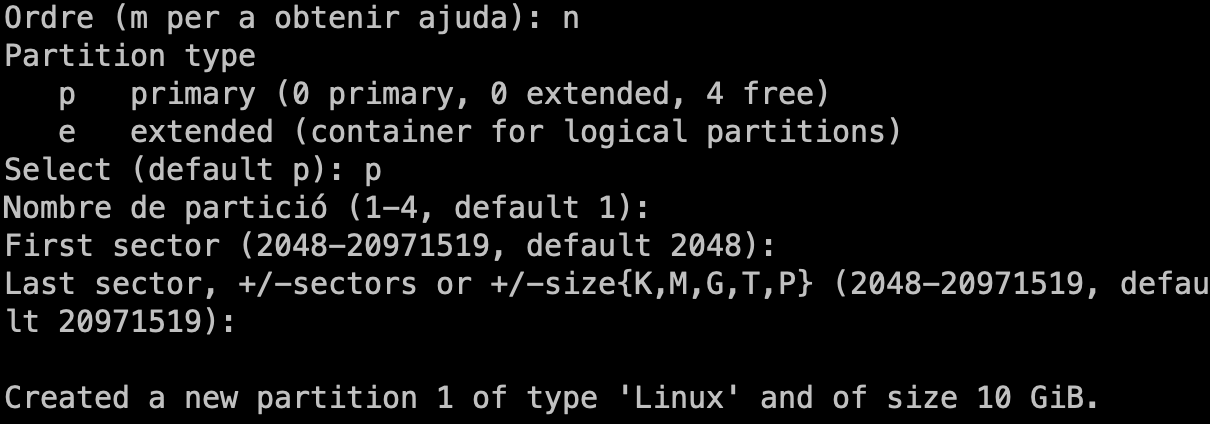

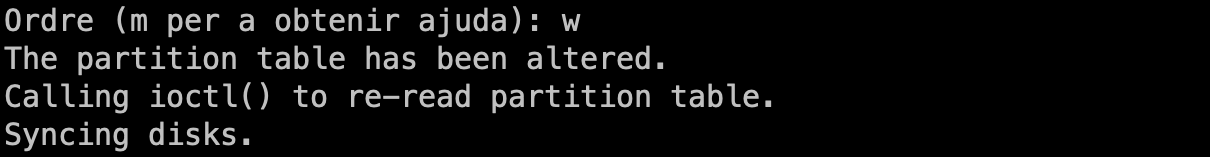

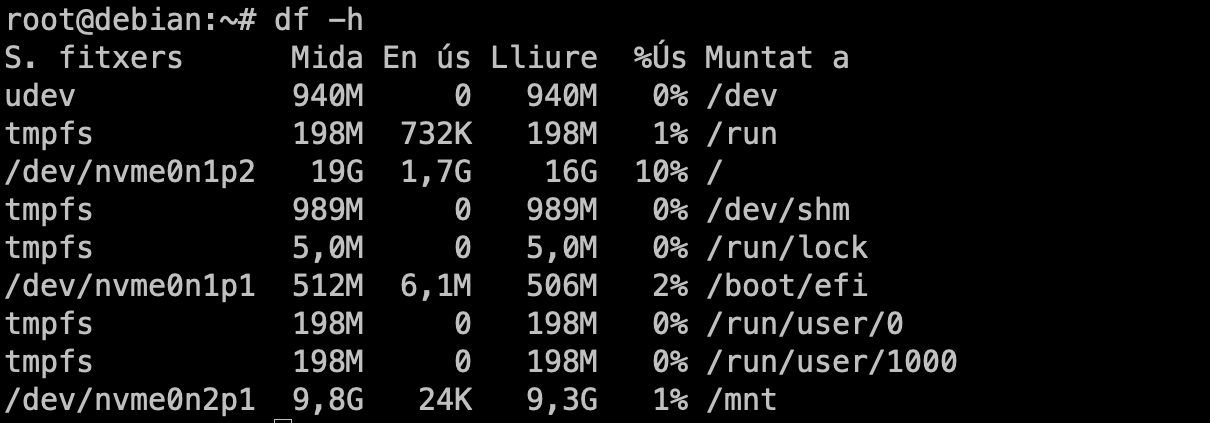

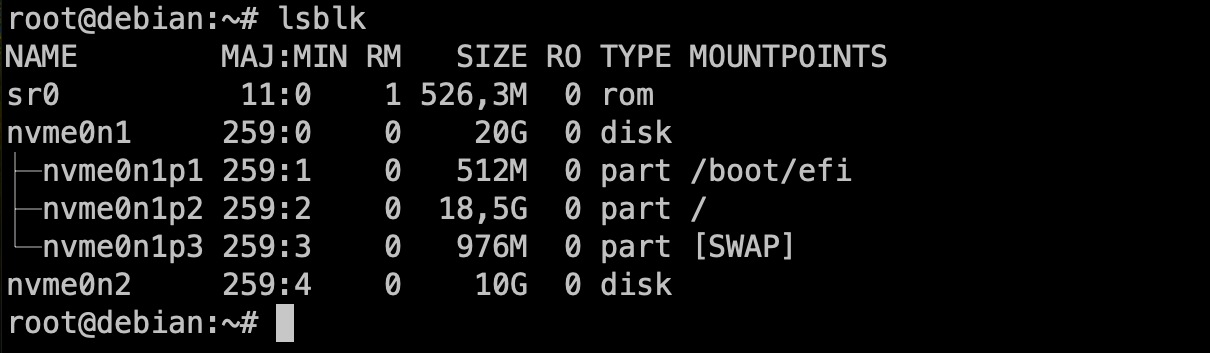

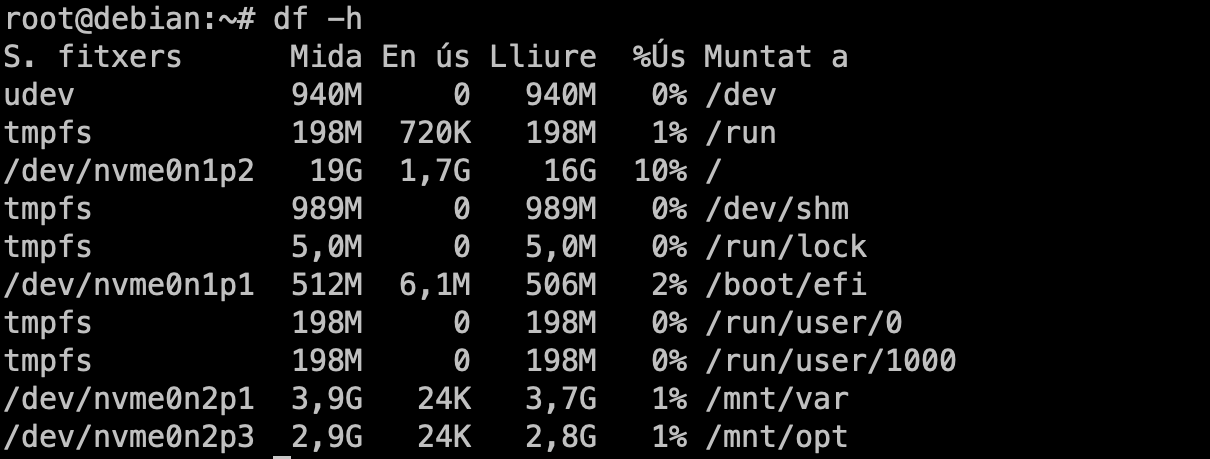

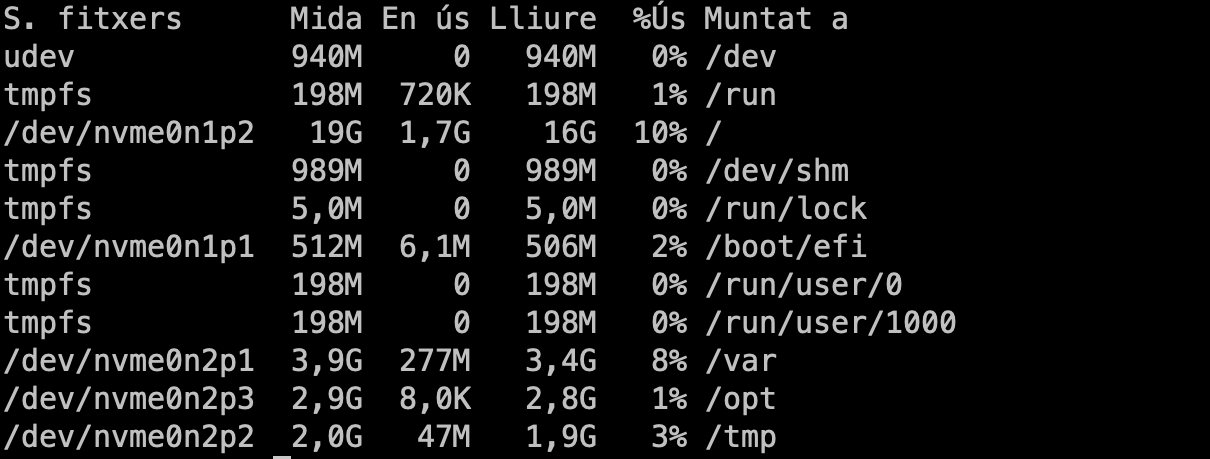

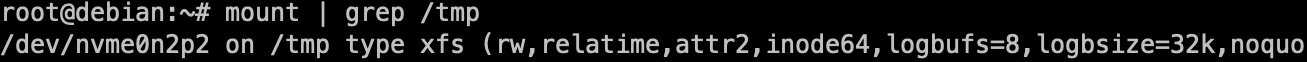

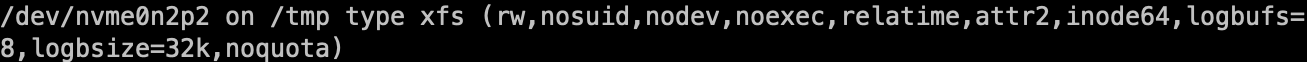

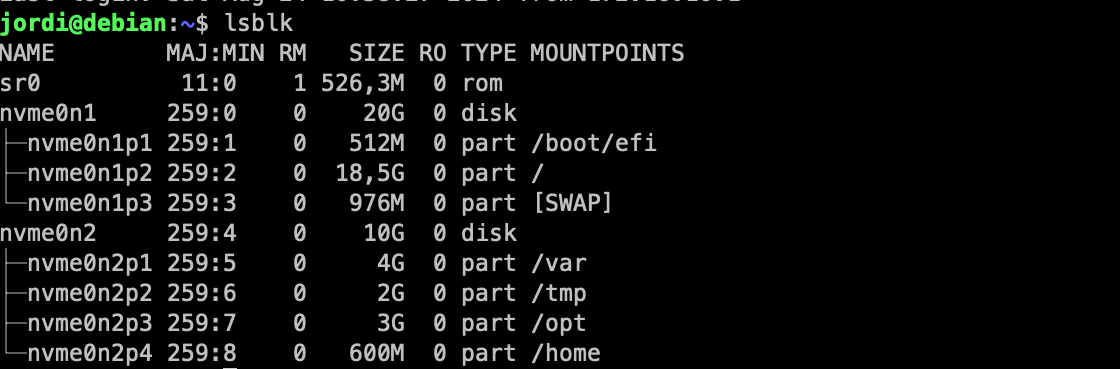

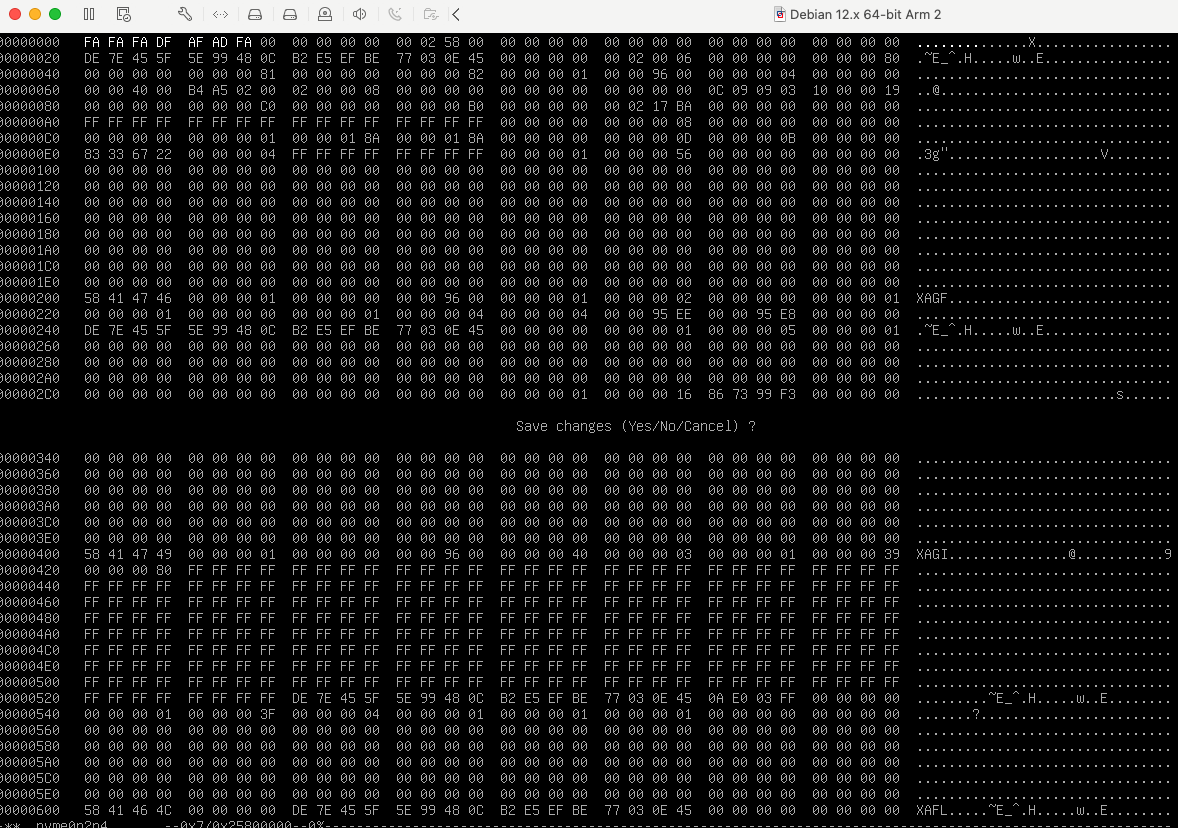

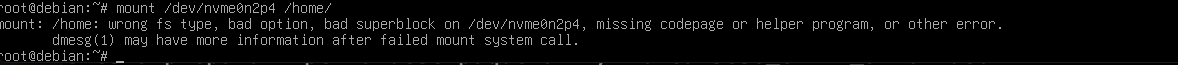

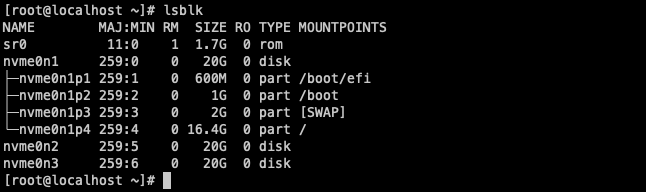

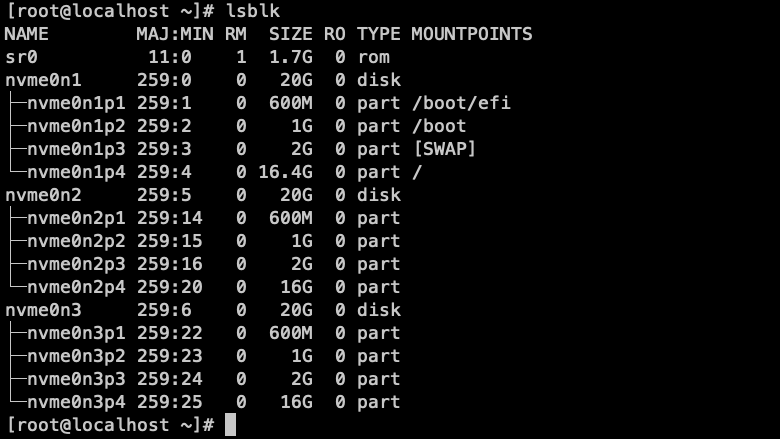

Configura el disc dur.

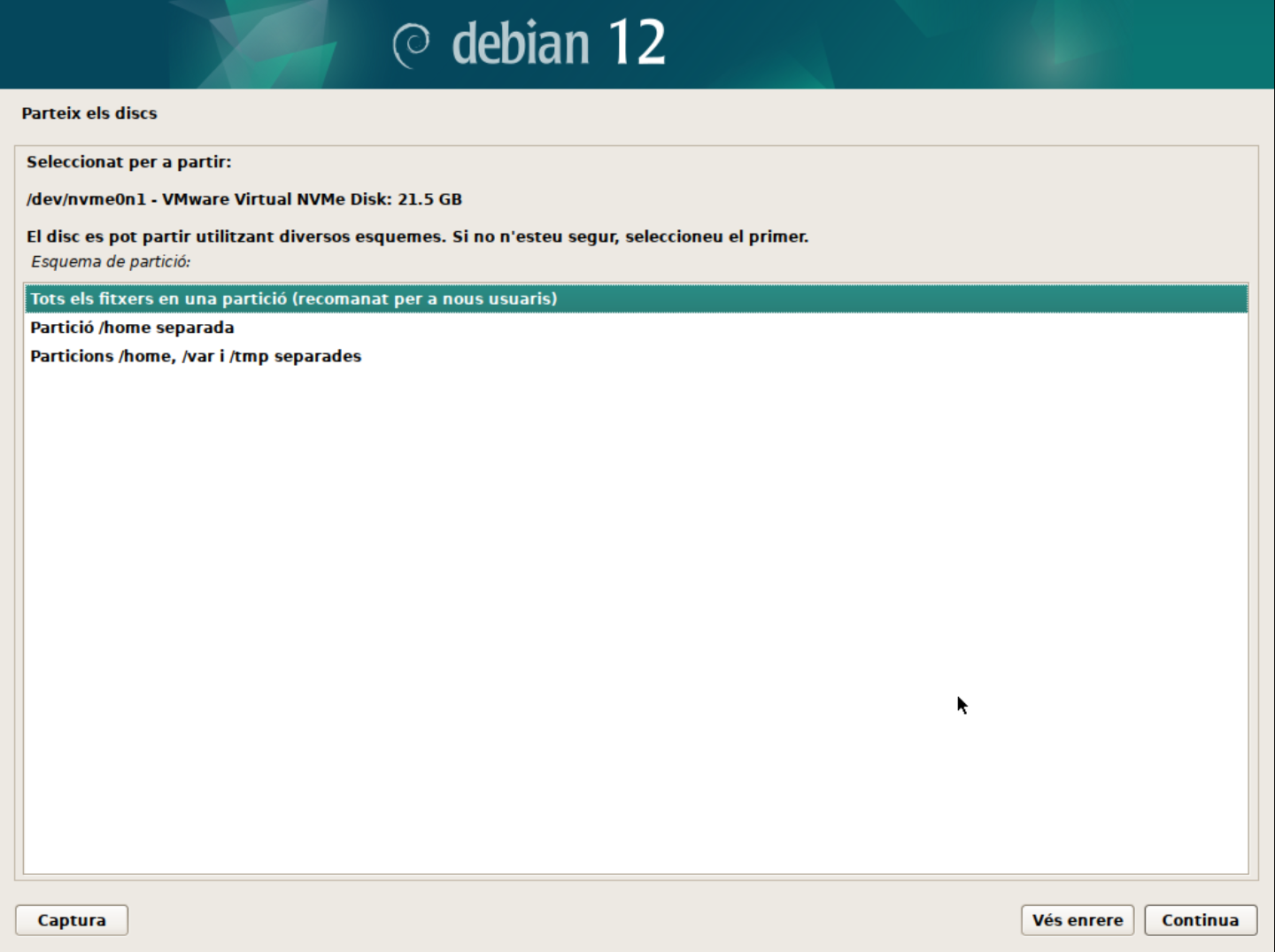

- Particionament: Durant el curs apendreu a realitzar particionament manual i, també discutirem sobre LV (Logical Volumes) i LVM (Logical Volume Manager). Però, per a una instal·lació senzilla, de moment, seleccionarem la primera opció (Guiat - utilitzar tot el disc).

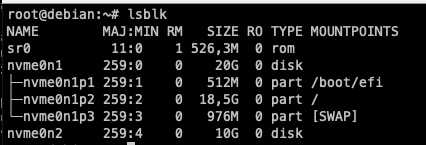

- Selecciona el disc on instal·lar el sistema. En el meu cas, només tinc un disc virtual amb l'etiqueta

/dev/nvme0n1. L'etiqueta indica el tipus de disc (NVMe) i el número de disc (1). Es possible tenir altres etiquetes com/dev/sdaper discos SATA o/dev/vdaper discos virtuals.

- Particions: Durant el curs apendreu les avantatges i com gestionar sistemes amb particions separades. Però, de moment, seleccionarem la primera opció (Totes les dades en una sola partició).

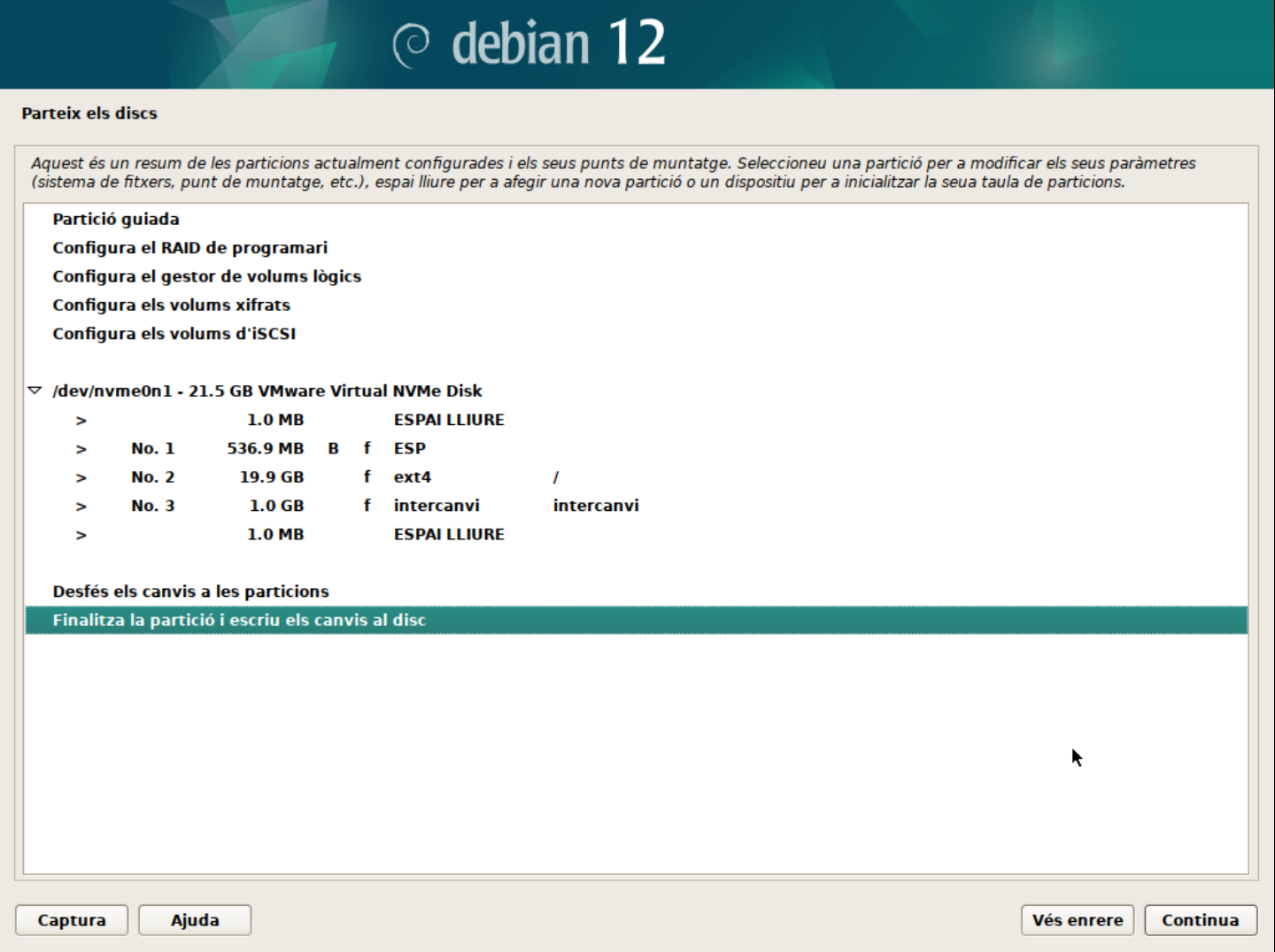

- Confirmeu els canvis. En aquest punt, el sistema crearà les particions necessàries:

- La primera partició serà la partició

/booton es guardaran els fitxers de boot. - La segona partició serà la partició

/on es guardaran els fitxers del sistema. - La tercera partició serà la partició de swap on es guardaran les dades de la memòria virtual.

- La primera partició serà la partició

👁️ Observació:

En aquest punt es poden fer moltes personalitzacions com ara:

- Configurar un sistema RAID.

- Configurar un sistema LVM.

- Configurar un sistema de xifrat. Tots aquests temes els veurem més endavant en el curs.

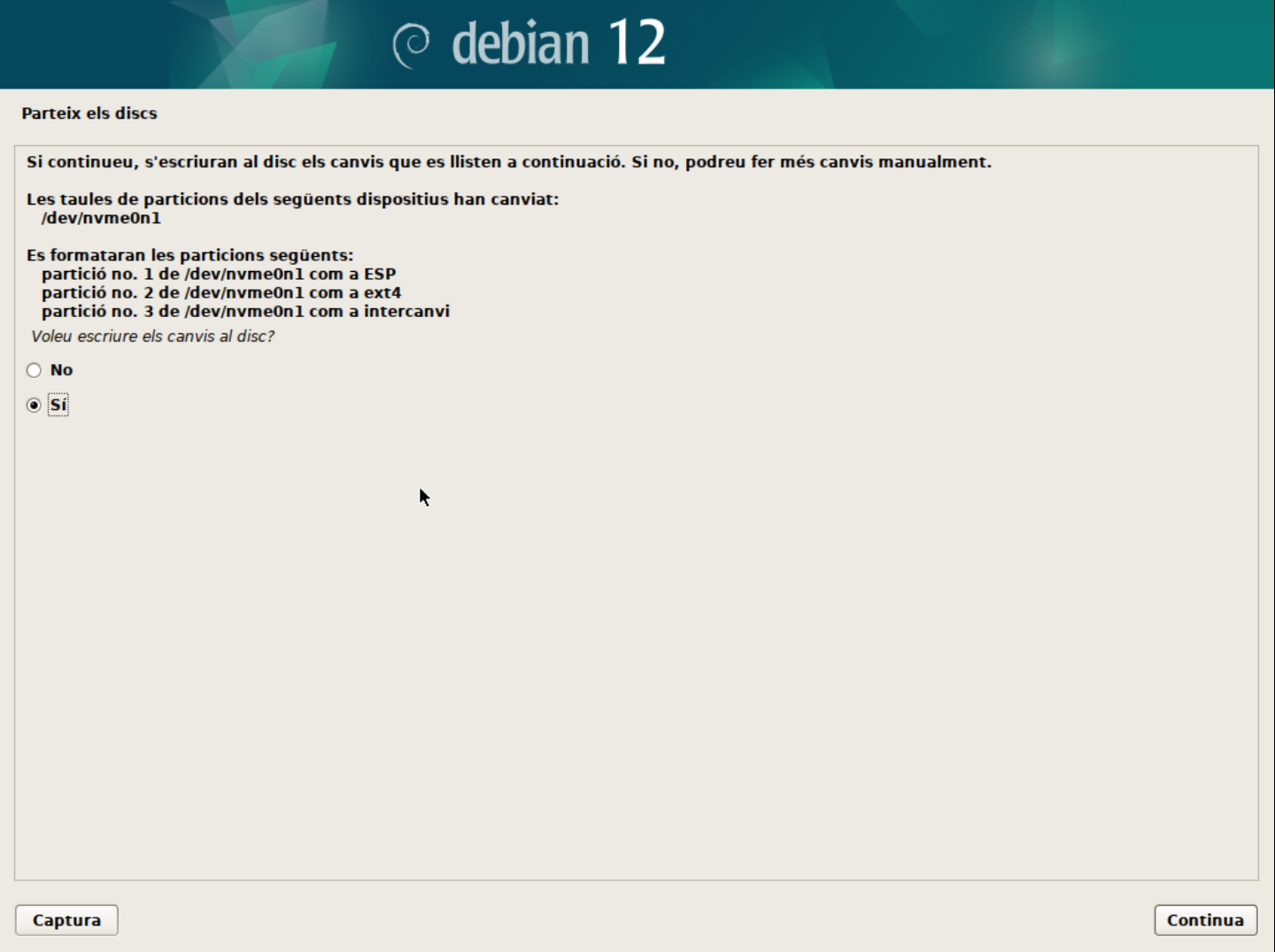

- Escriu els canvis al disc.

-

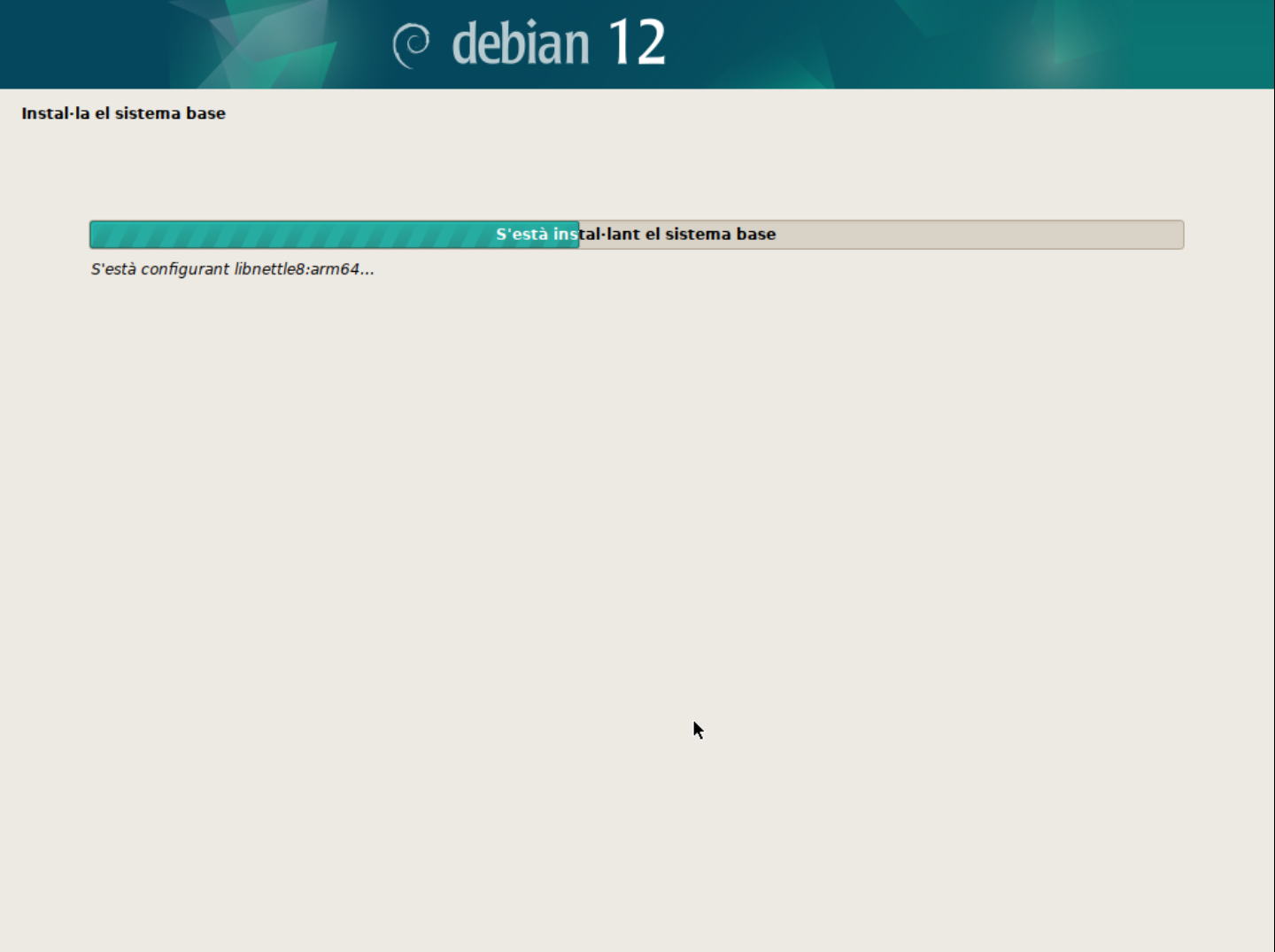

Espera que s'instal·li el sistema.

-

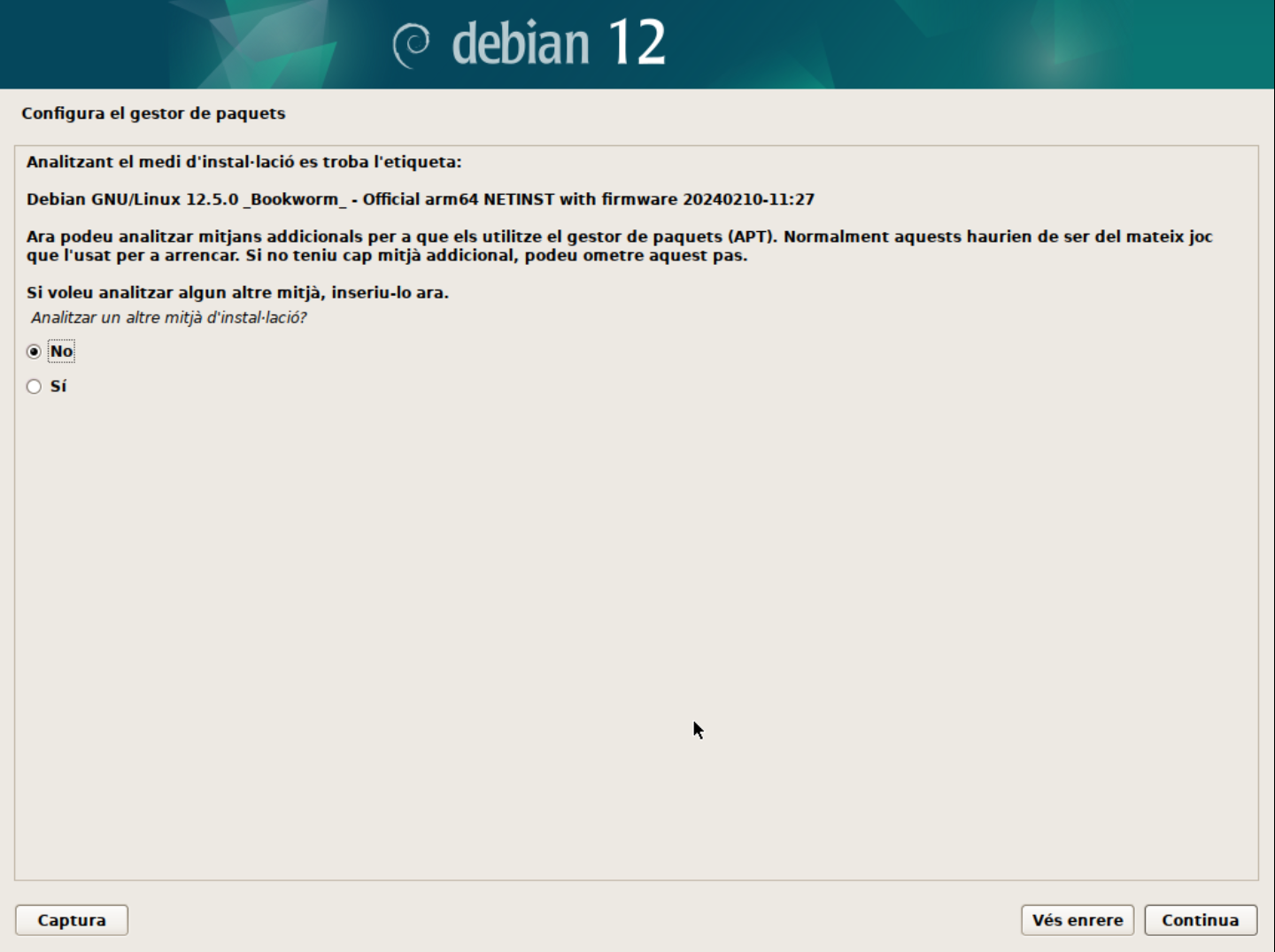

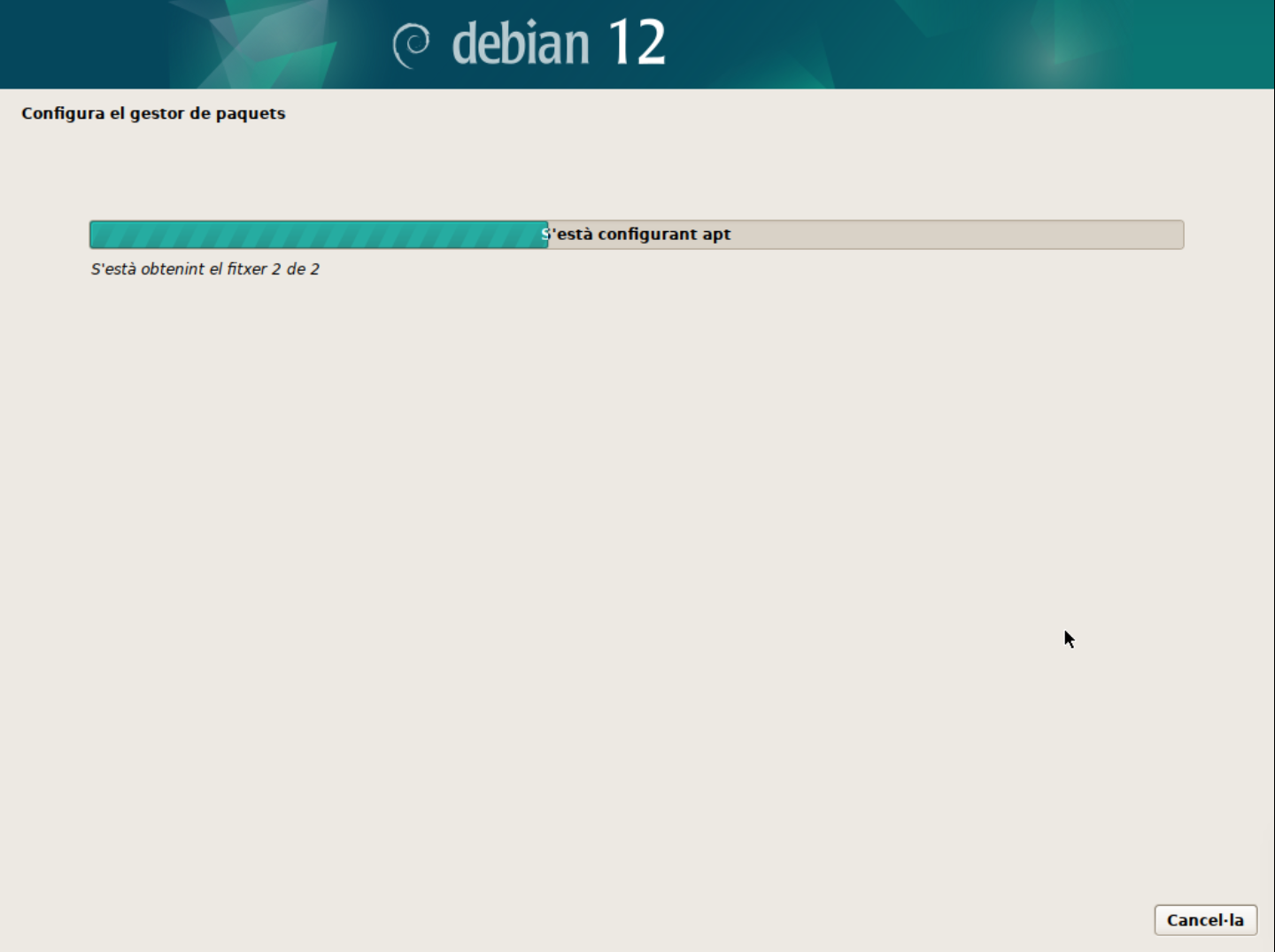

Configura el gestor de paquets.

- Analitzar els discos de la instal·lació. Aquest pas permet seleccionar els discos on es troben els paquets d'instal·lació. Normalment, aquest pas no cal modificar-lo.

-

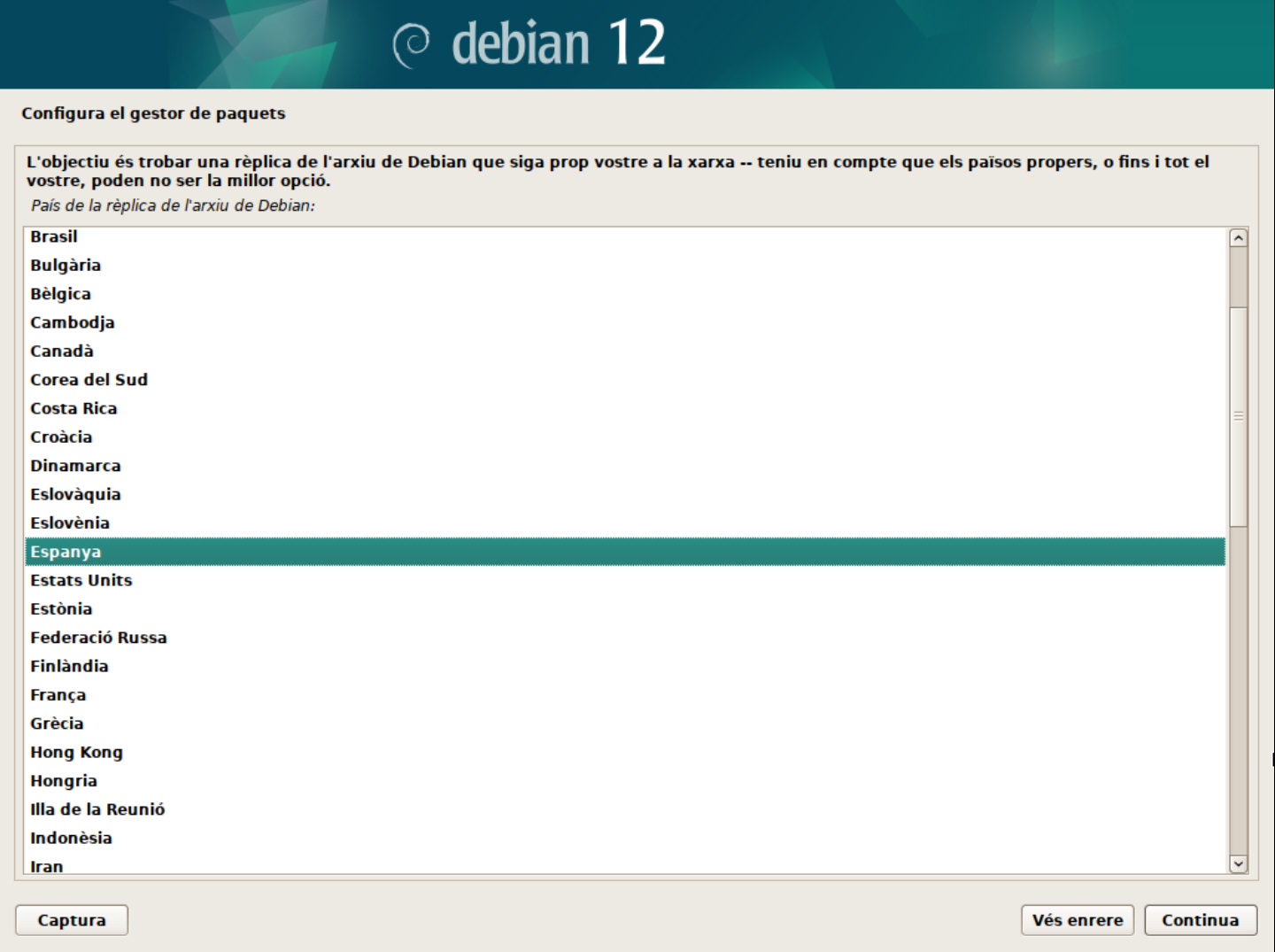

Configura el gestor de paquets. En aquest cas, seleccionarem el servidor de paquets més proper a la nostra ubicació.

-

Filtrar els servidors de paquets per ubicació.

-

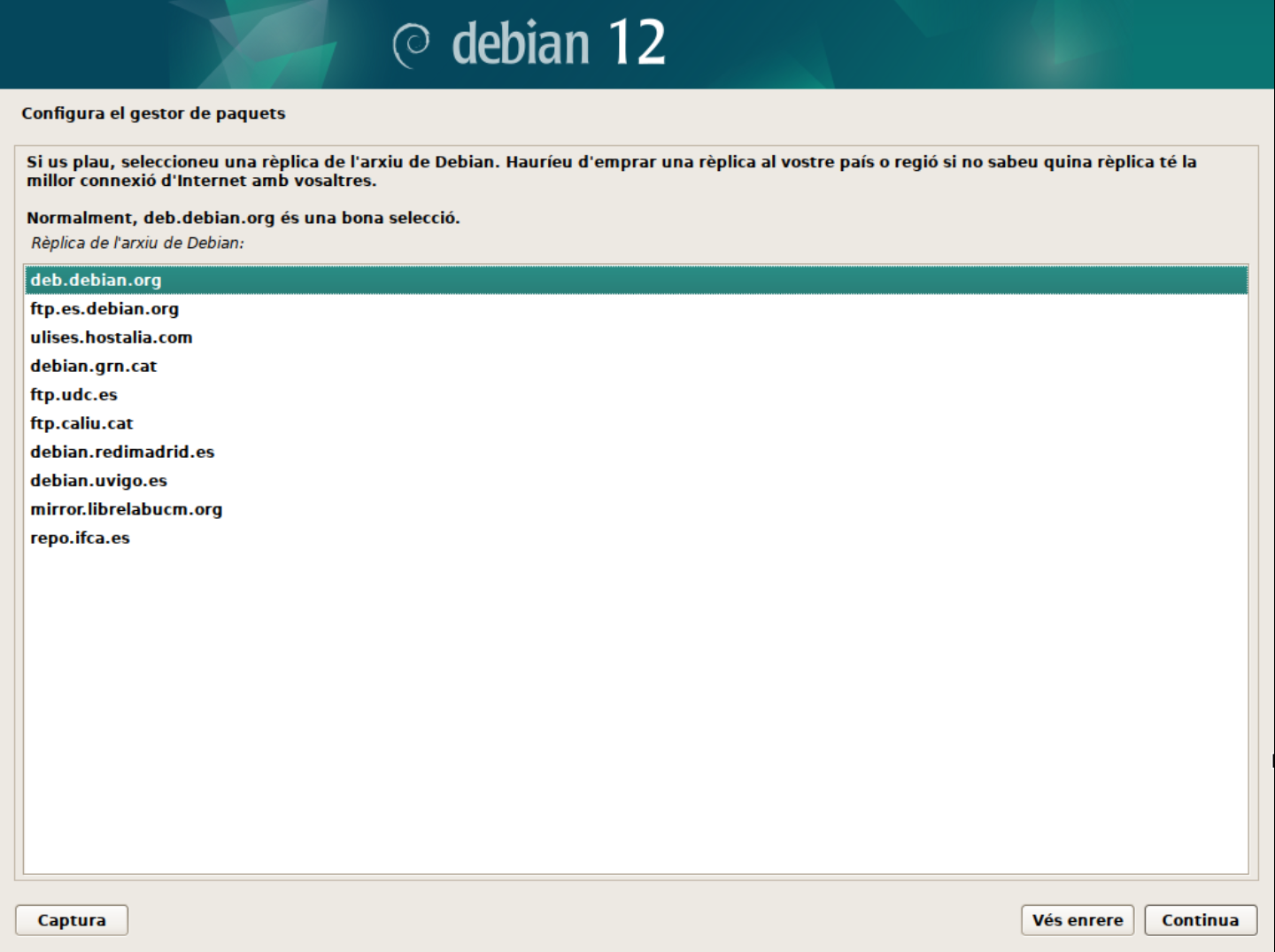

Seleccionar el servidor de paquets.

👀 Nota:

A vegades, els servidors de paquets poden estar saturats o no funcionar correctament. En aquest cas, podeu seleccionar un servidor alternatiu o provar més tard.

-

-

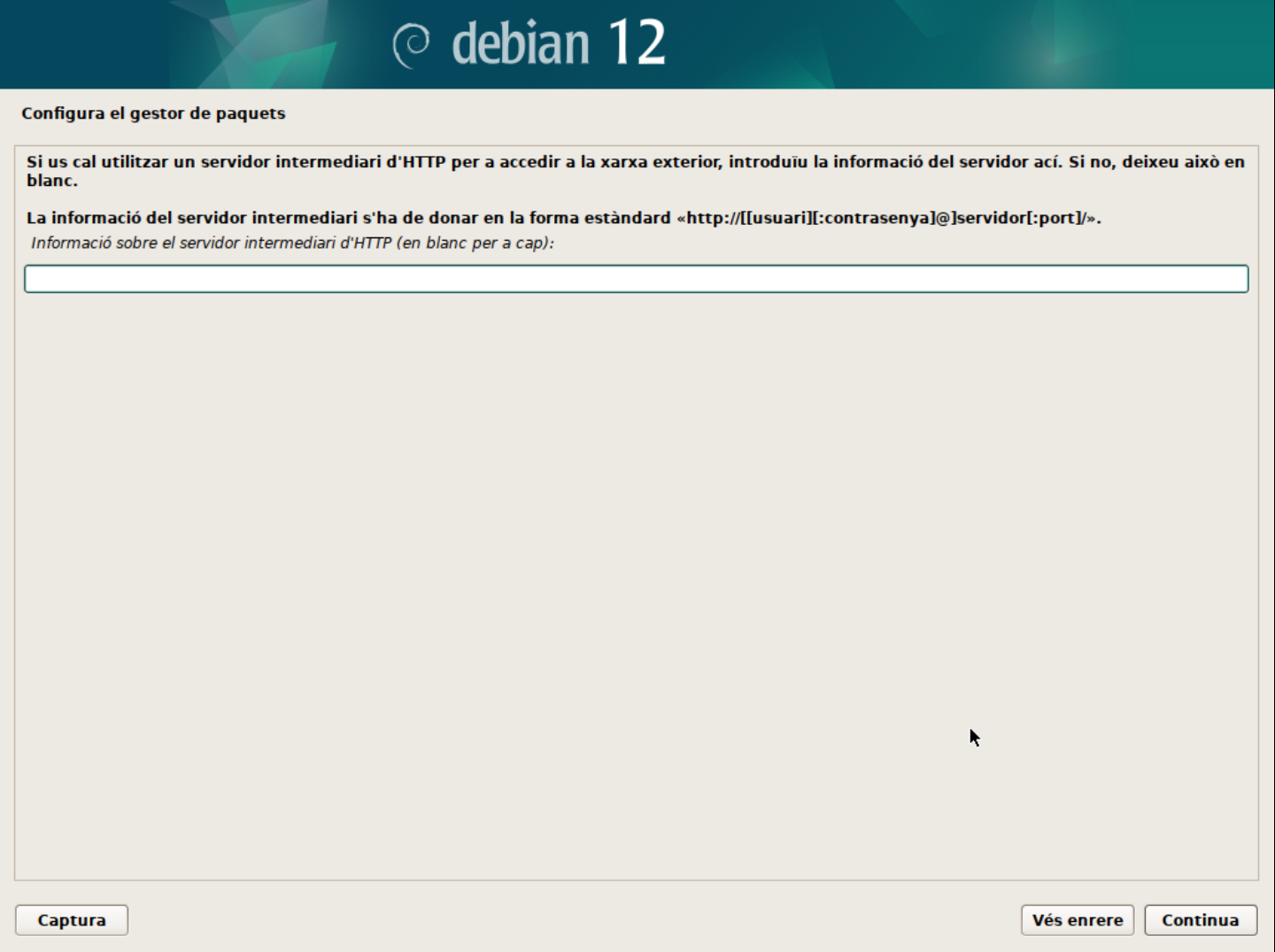

Configura el proxy. Si esteu darrere d'un proxy, podeu configurar-lo en aquest pas.

ℹ️ Què és un proxy?

Un proxy és un servidor intermediari entre el vostre sistema i Internet. Aquest servidor pot ser utilitzat per controlar l'accés a Internet, per protegir la vostra privacitat o per accelerar la connexió a Internet. Les peticions de connexió a Internet es fan a través del servidor proxy, que actua com a intermediari i reenvia les peticions al servidor de destinació. Per exemple, en una empresa, el proxy pot ser utilitzat per controlar l'accés a Internet dels empleats i protegir la xarxa interna de possibles amenaces.

-

Espera que s'instal·lin els paquets.

-

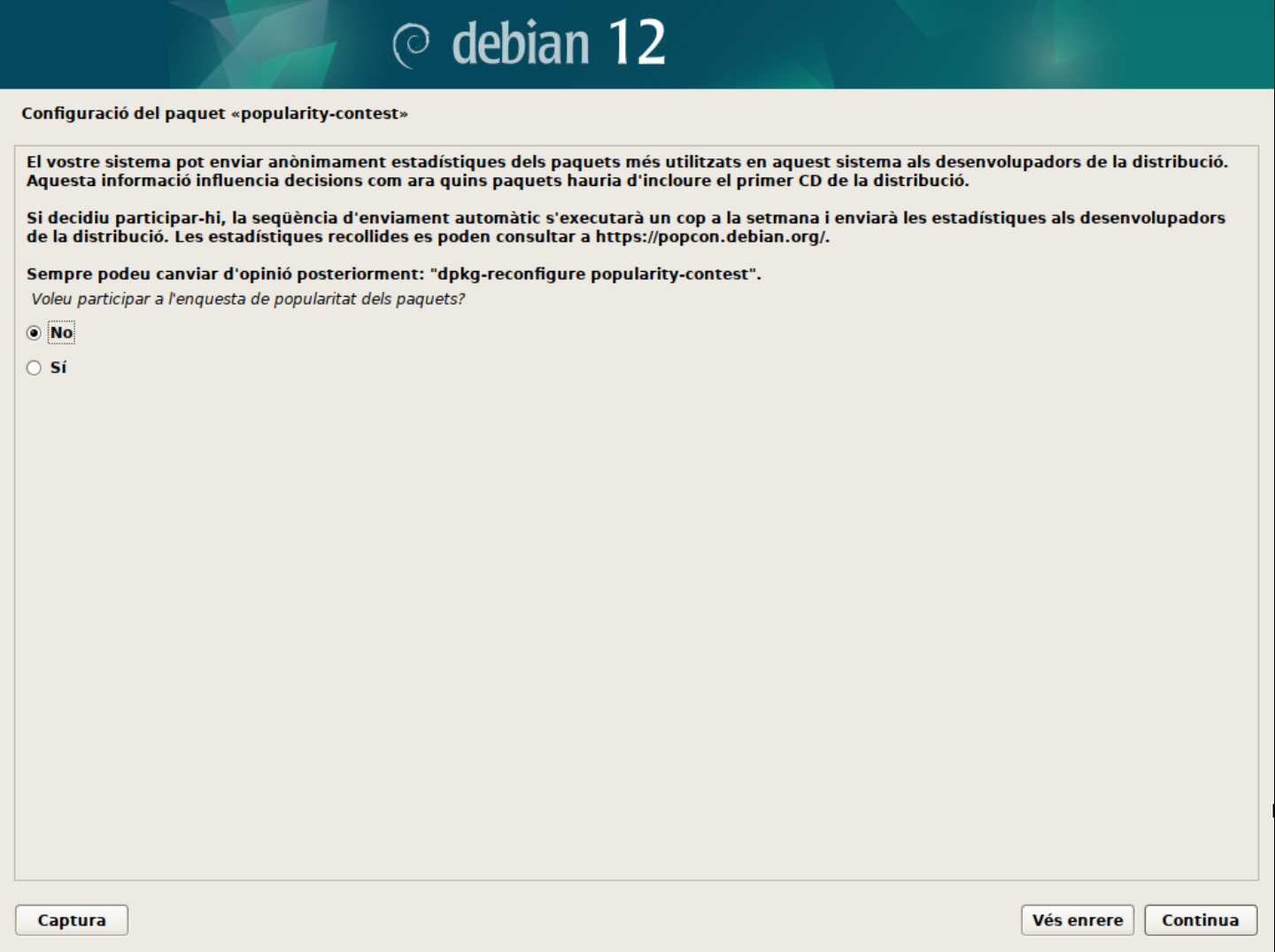

Configura el paquet

popularity-contest.- Aquest paquet permet enviar informació anònima sobre els paquets instal·lats al servidor de Debian per millorar la selecció de paquets i la qualitat dels paquets. Podeu seleccionar si voleu participar en aquest programa o no.

-

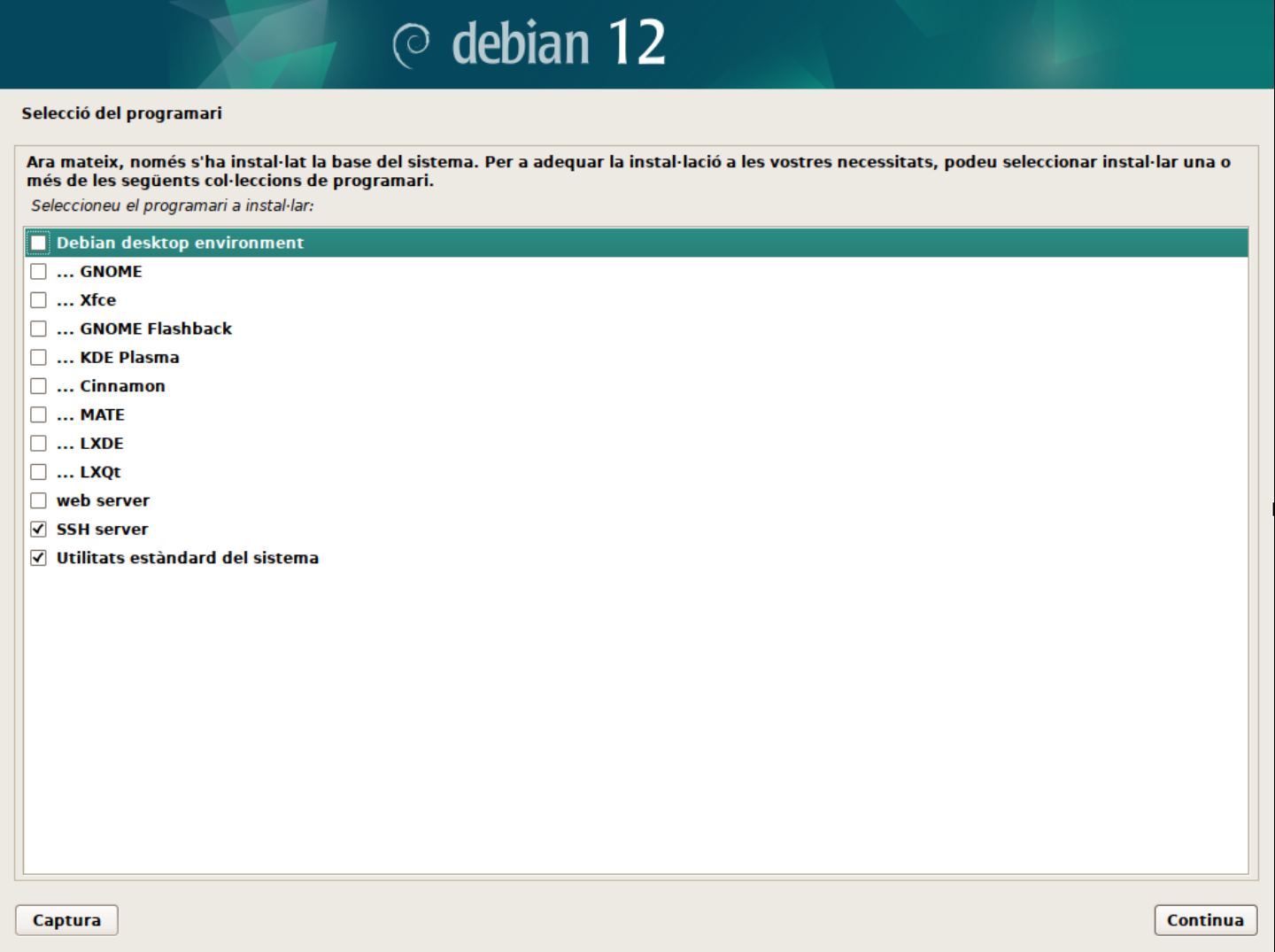

Selecció de programari. En aquest punt podeu seleccionar si voleu un servidor en mode text o amb interfície gràfica. També us permet seleccionar si voleu instal·lar els serveis web i ssh al servidor i finalment si voleu les utilitats estàndard del sistema. Aquestes opcions les anirem modifciant en funció dels laboratoris que realitzarem. Per defecte, seleccionarem el servidor en mode text, el servei SSH activat i les utilitats estàndard del sistema.

ℹ️ Què és un servidor en mode text?

Un servidor en mode text és un servidor que no té una interfície gràfica. Això significa que tota la interacció amb el servidor es fa a través de la línia de comandes. Aquest tipus de servidor és molt comú en entorns de producció, ja que consumeix menys recursos i és més segur que un servidor amb interfície gràfica.

ℹ️ Què és el servei SSH?

El servei SSH (Secure Shell) és un protocol de xifratament que permet connectar-se de forma segura a un servidor remot. Aquest servei és molt utilitzat per administrar servidors a distància, ja que permet accedir al servidor de forma segura i xifratada.

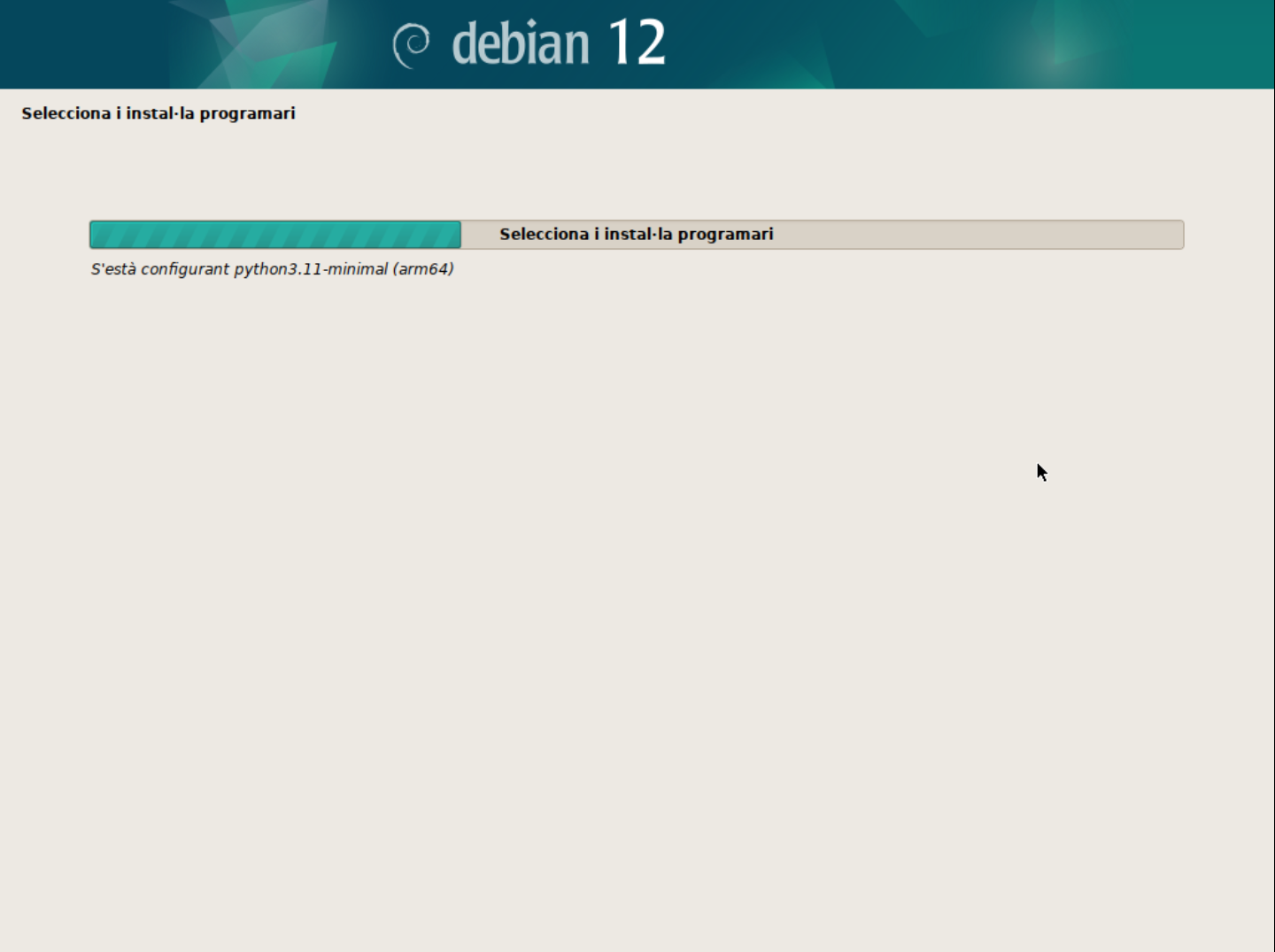

-

Espera que s'instal·li el programari.

-

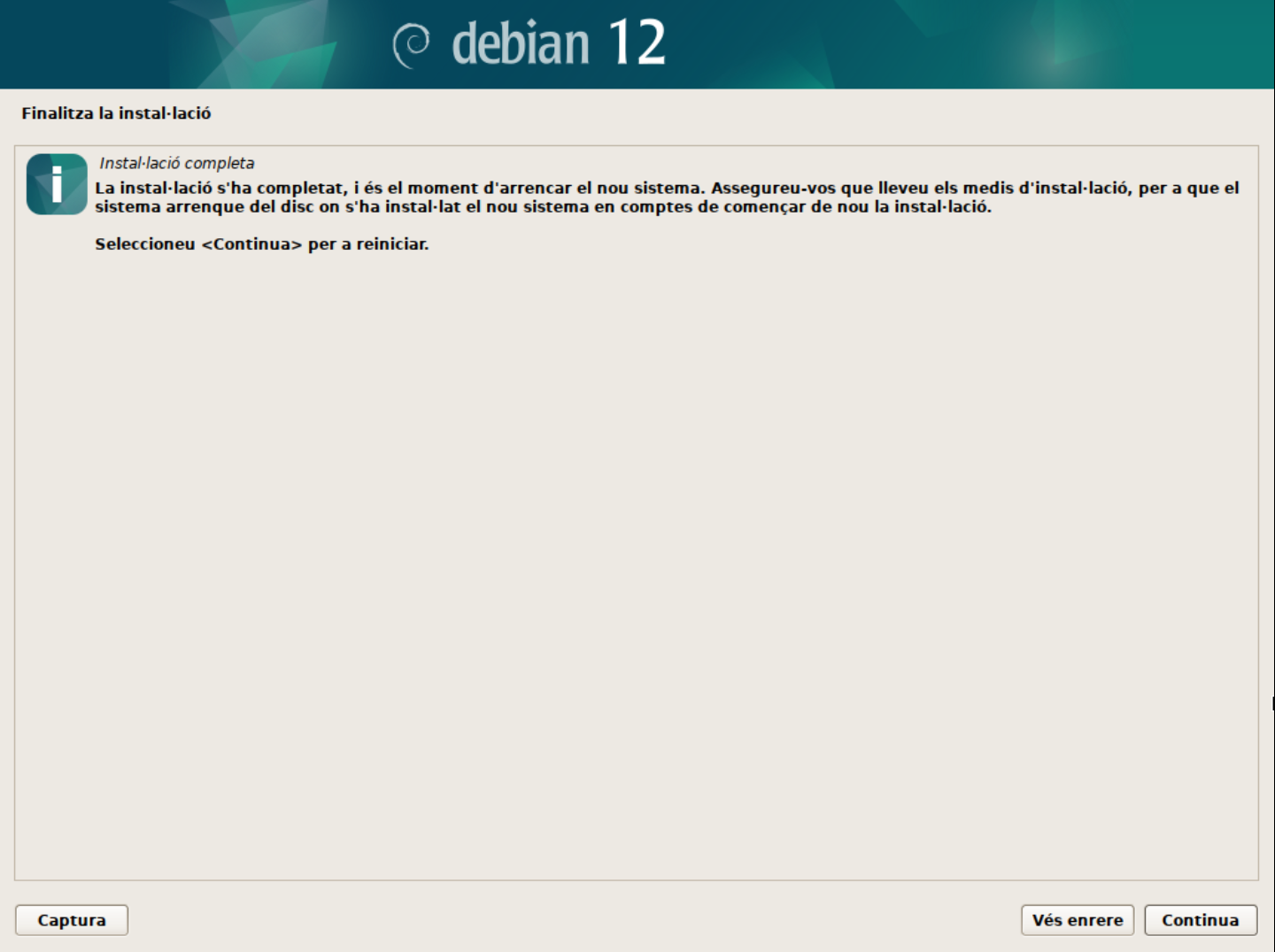

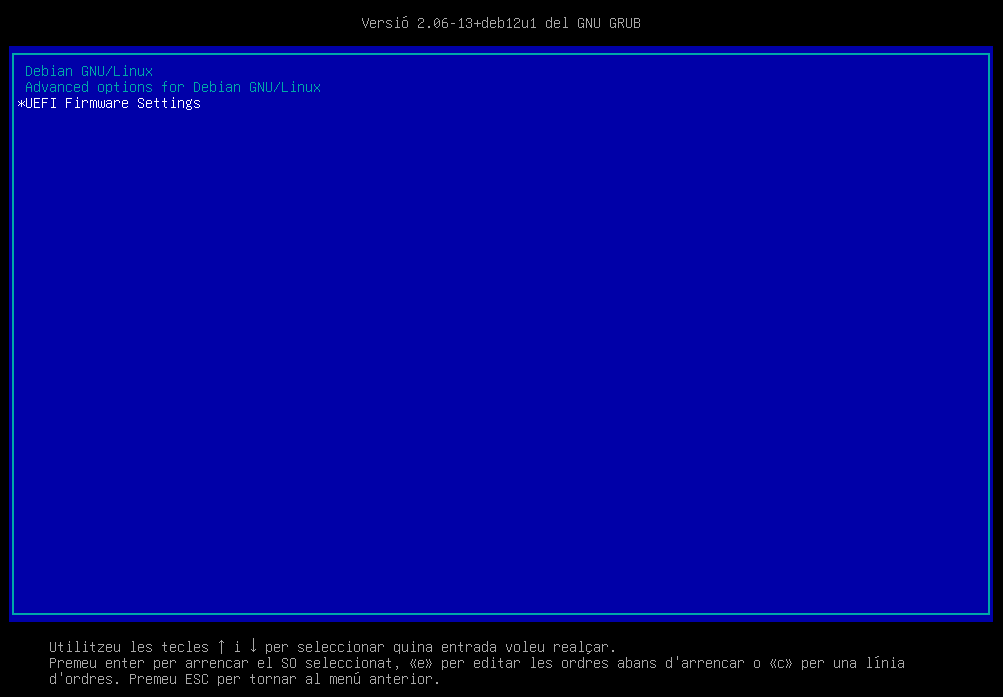

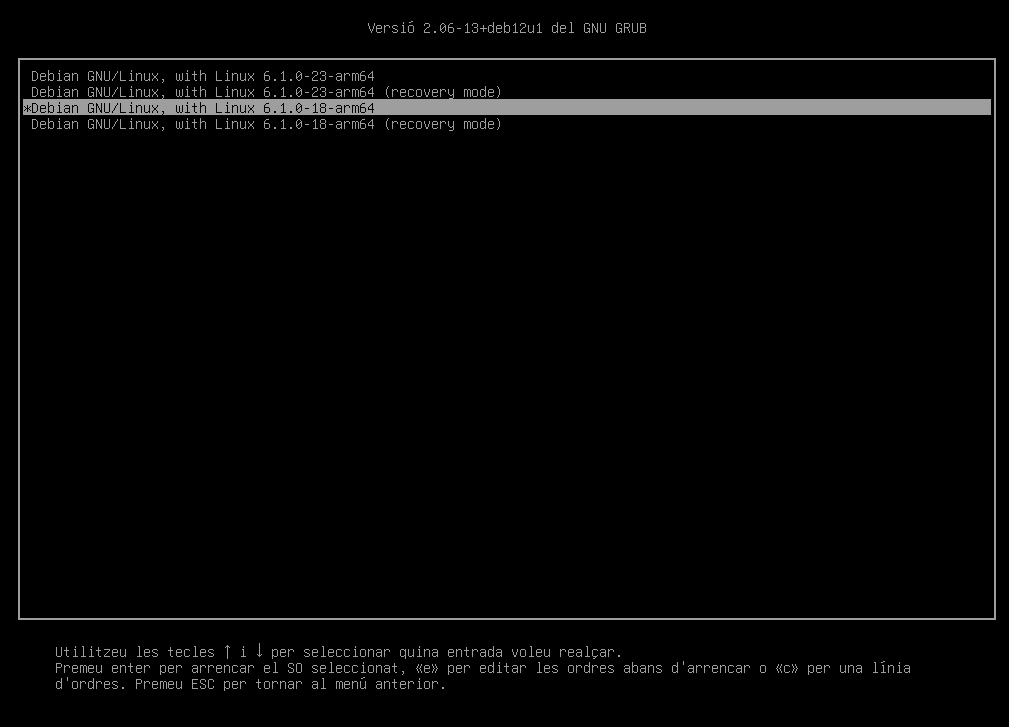

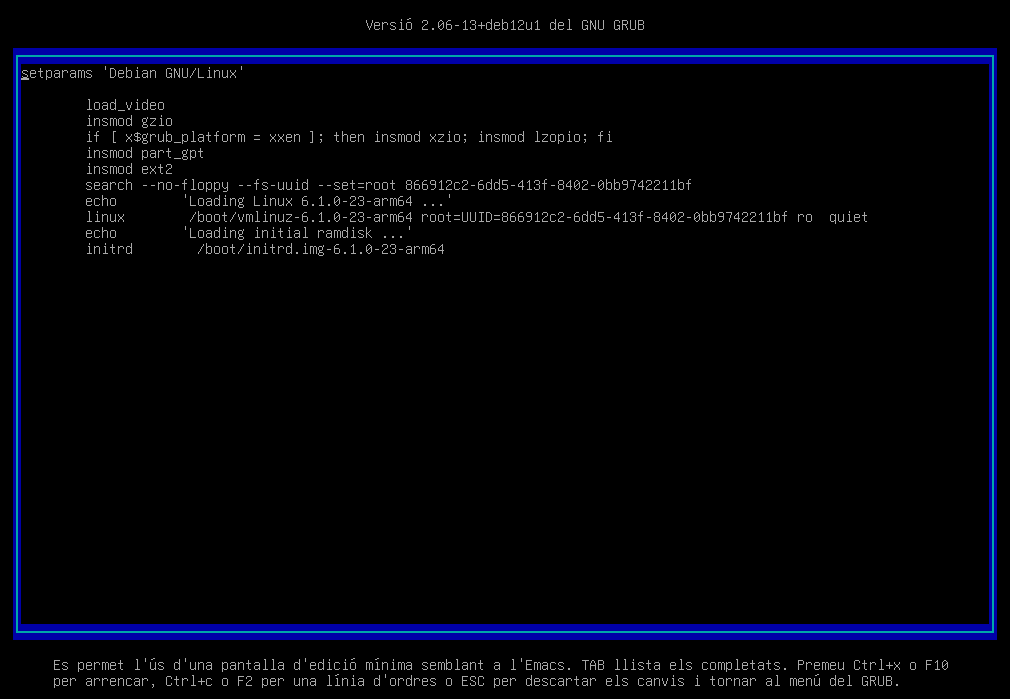

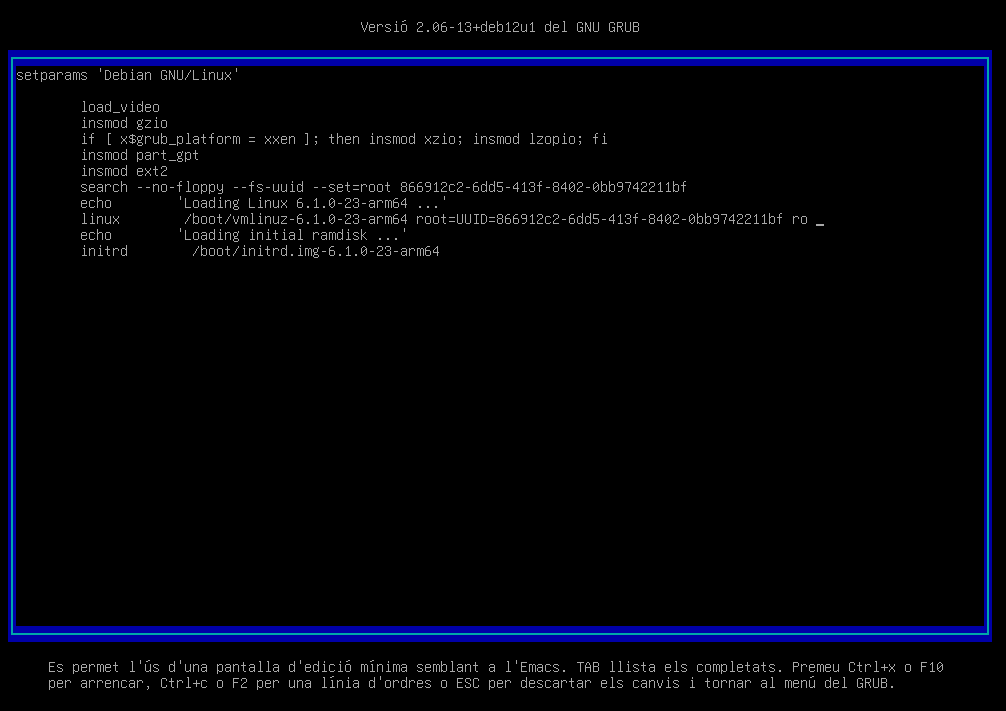

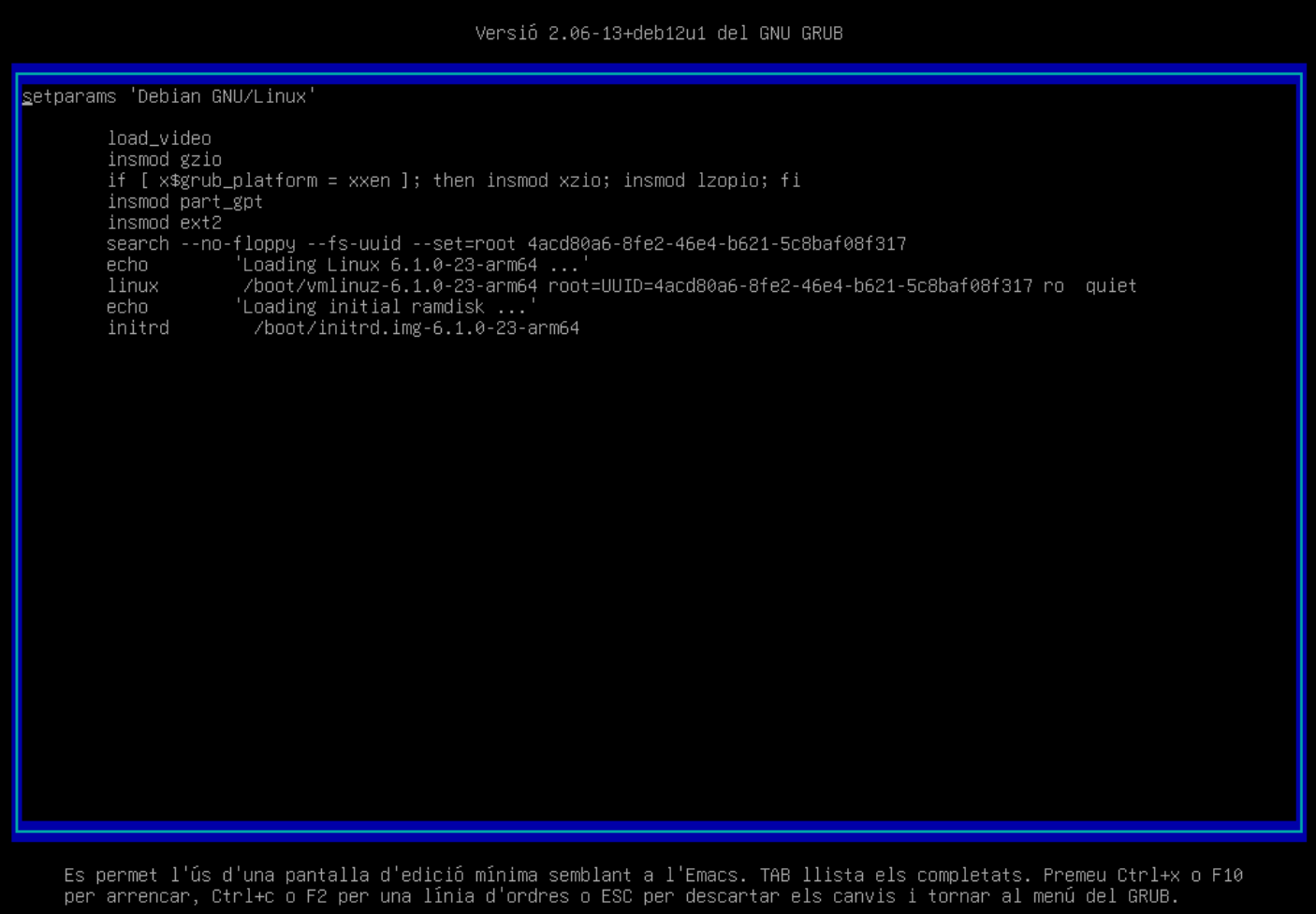

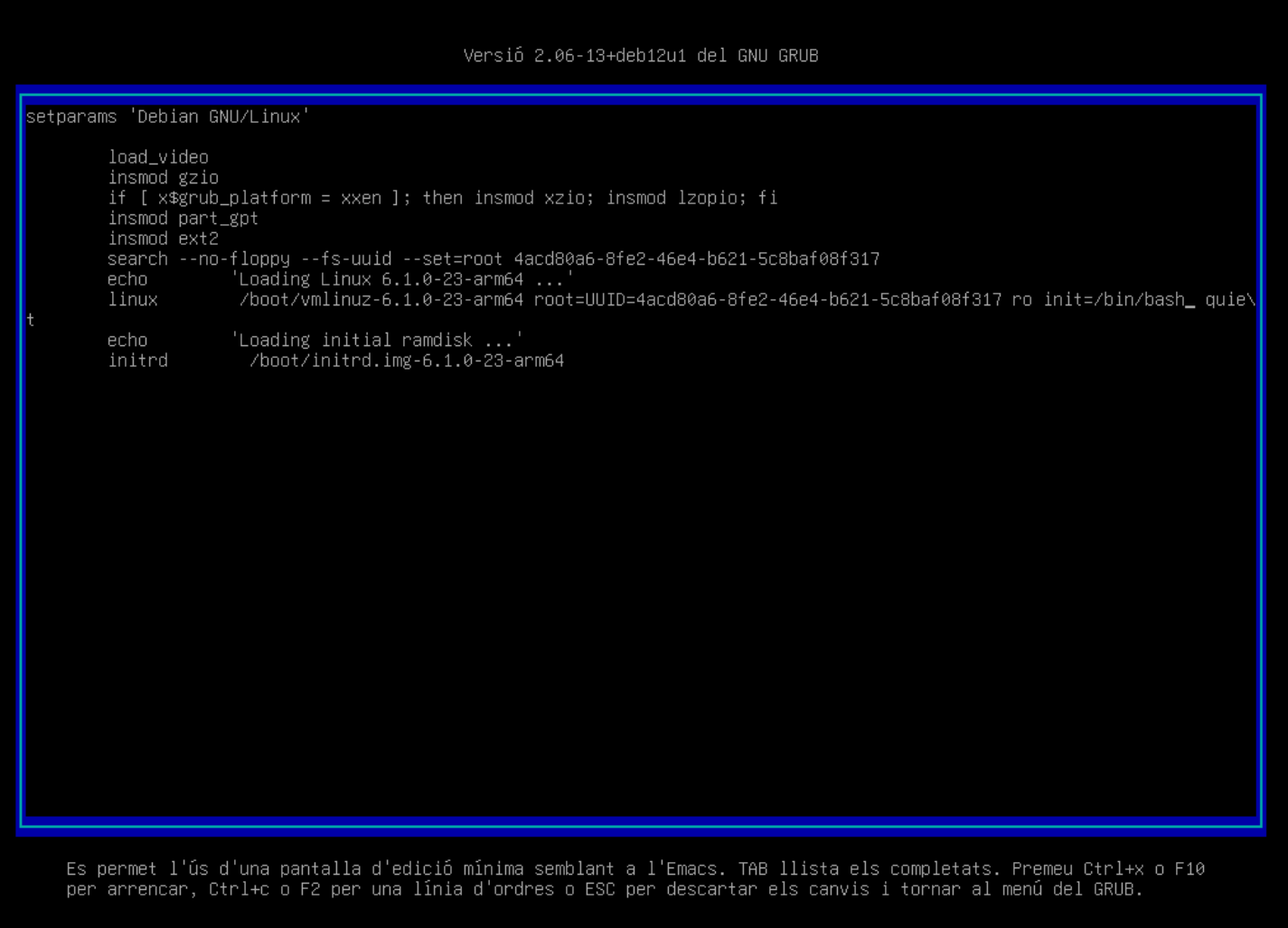

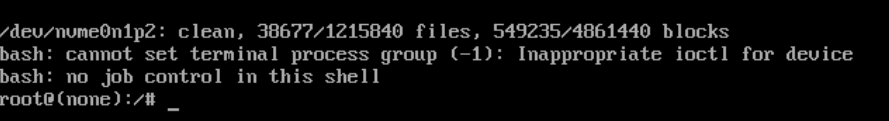

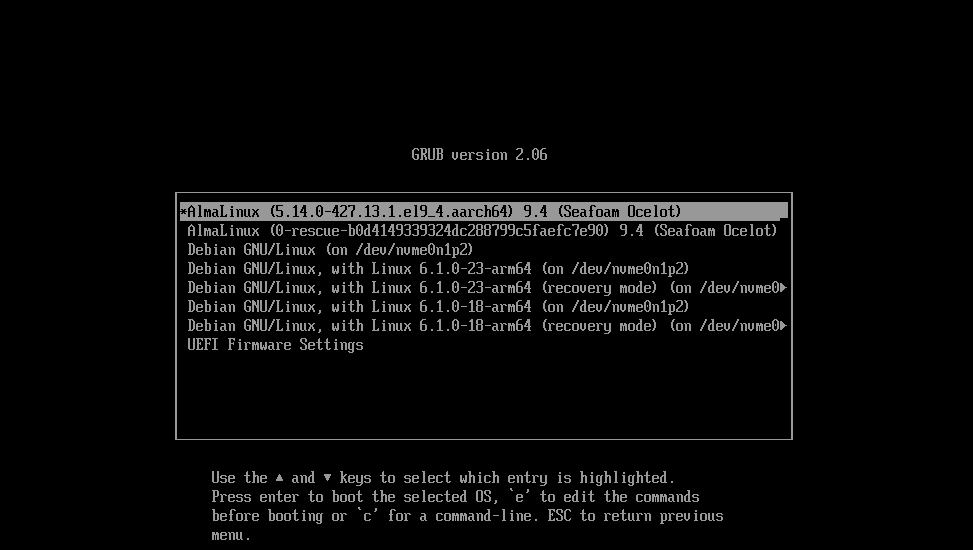

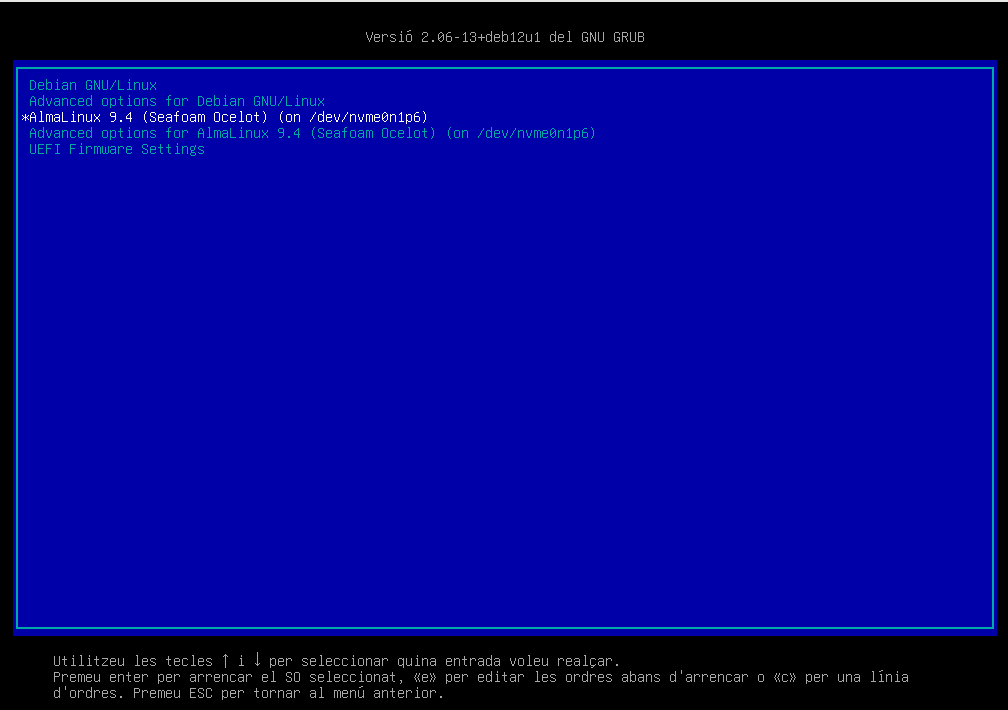

Instal·lació acabada. Un cop finalitzada la instal·lació, el sistema es reiniciarà i podreu accedir al GRUB per seleccionar el sistema operatiu.

-

El GRUB us permet accedir al sistema operatiu. En aquest cas, seleccionarem Debian GNU/Linux. La resta d'opcions les veurem més endavant en el curs.

ℹ️ Què és el GRUB?

Com veurem al capítol de Booting, el GRUB és un gestor d'arrencada que permet seleccionar el sistema operatiu que volem iniciar. Aquest gestor és molt útil en sistemes amb múltiples sistemes operatius o múltiples versions del mateix sistema operatiu.

-

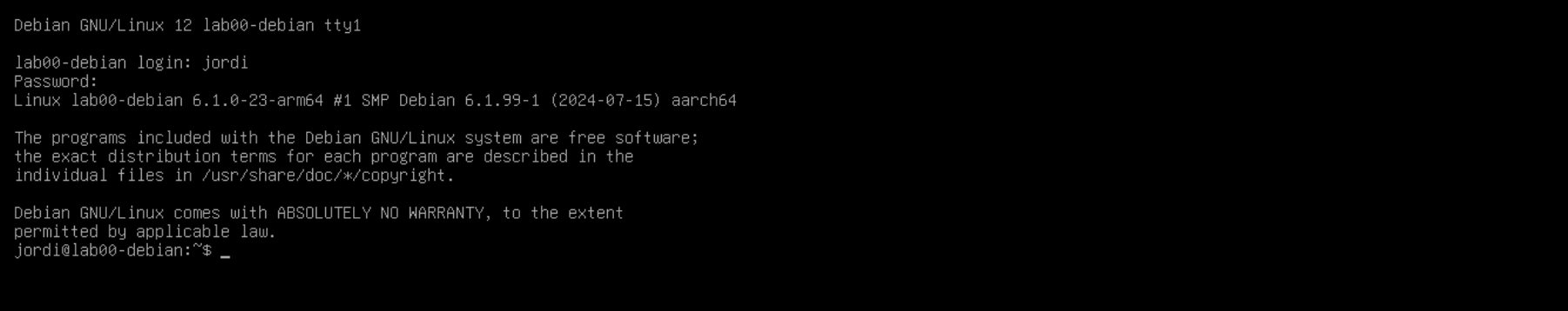

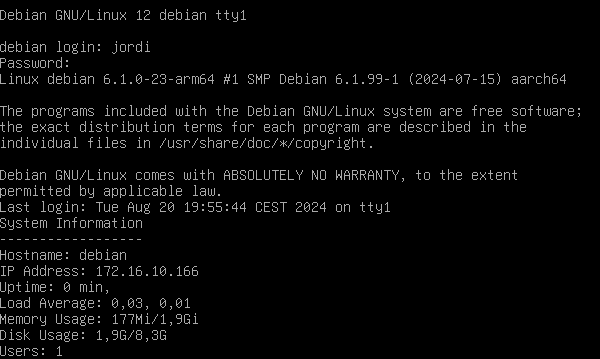

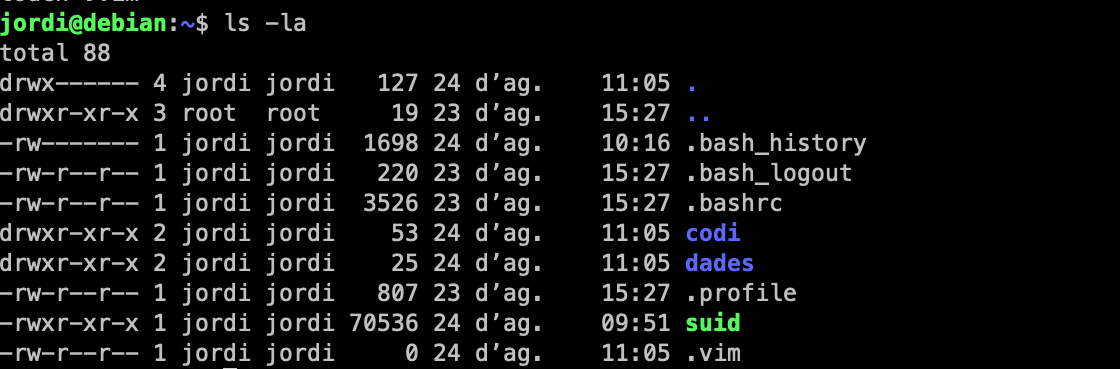

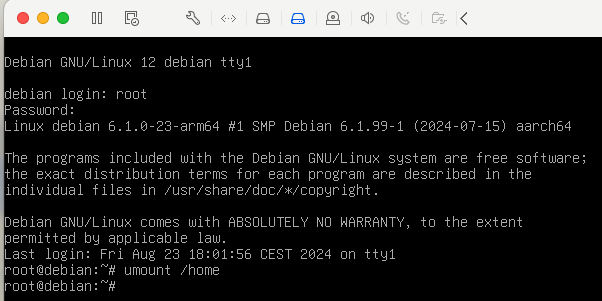

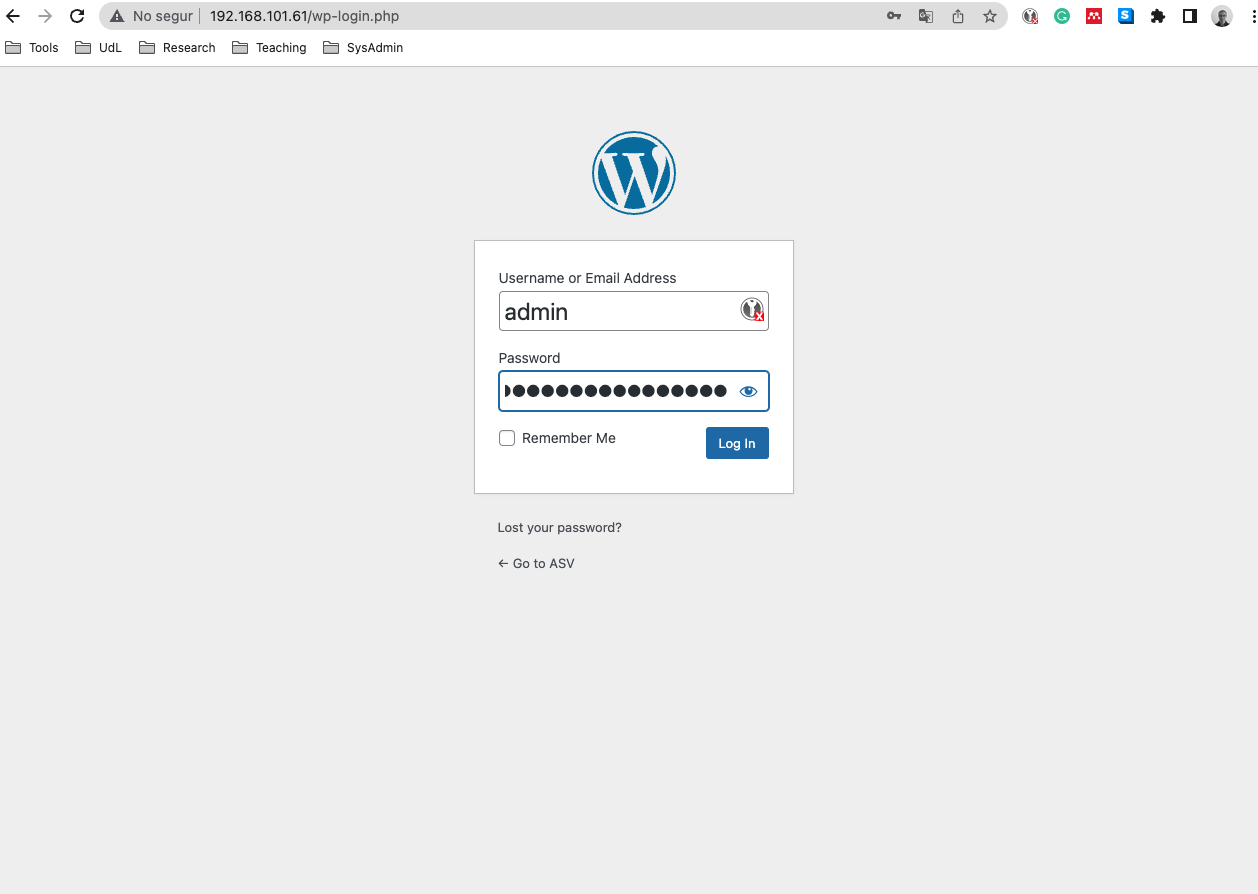

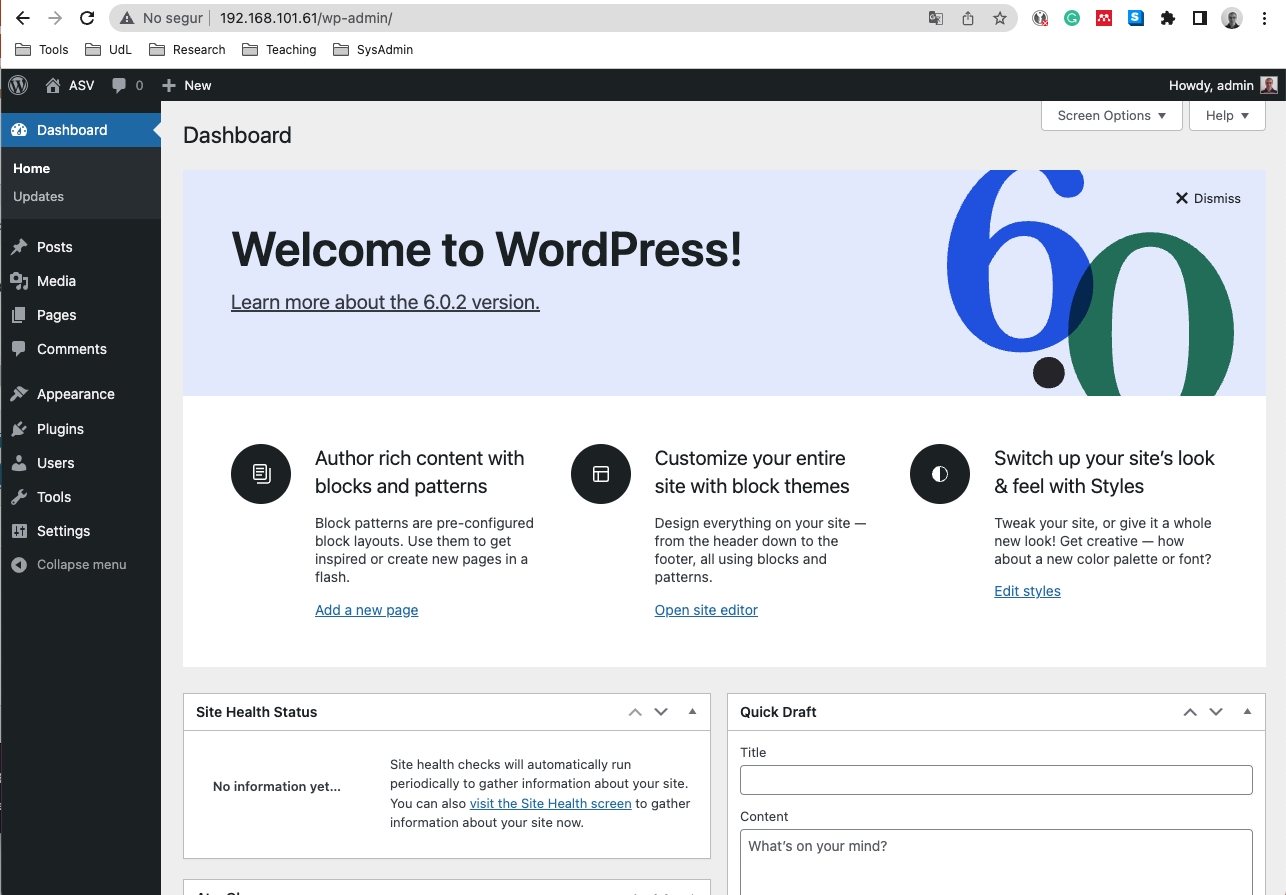

Inicieu sessió amb l'usuari i la contrasenya que heu configurat durant la instal·lació.

-

Tanqueu la sessió amb la comanda

exit. -

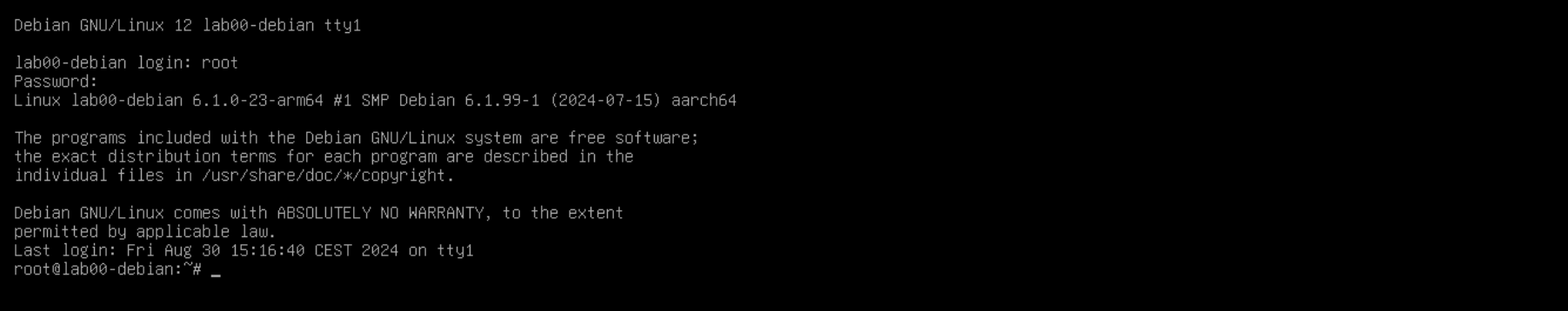

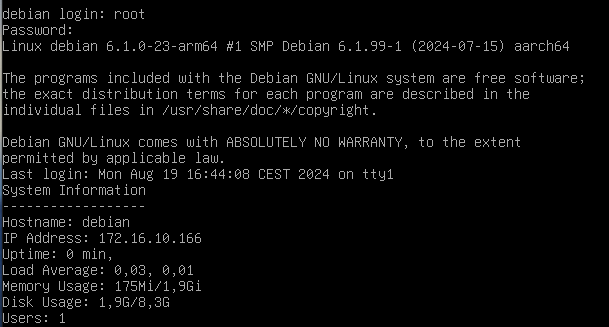

Inicieu sessió amb l'usuari

rooti la contrasenya que heu configurat durant la instal·lació.

Hostname

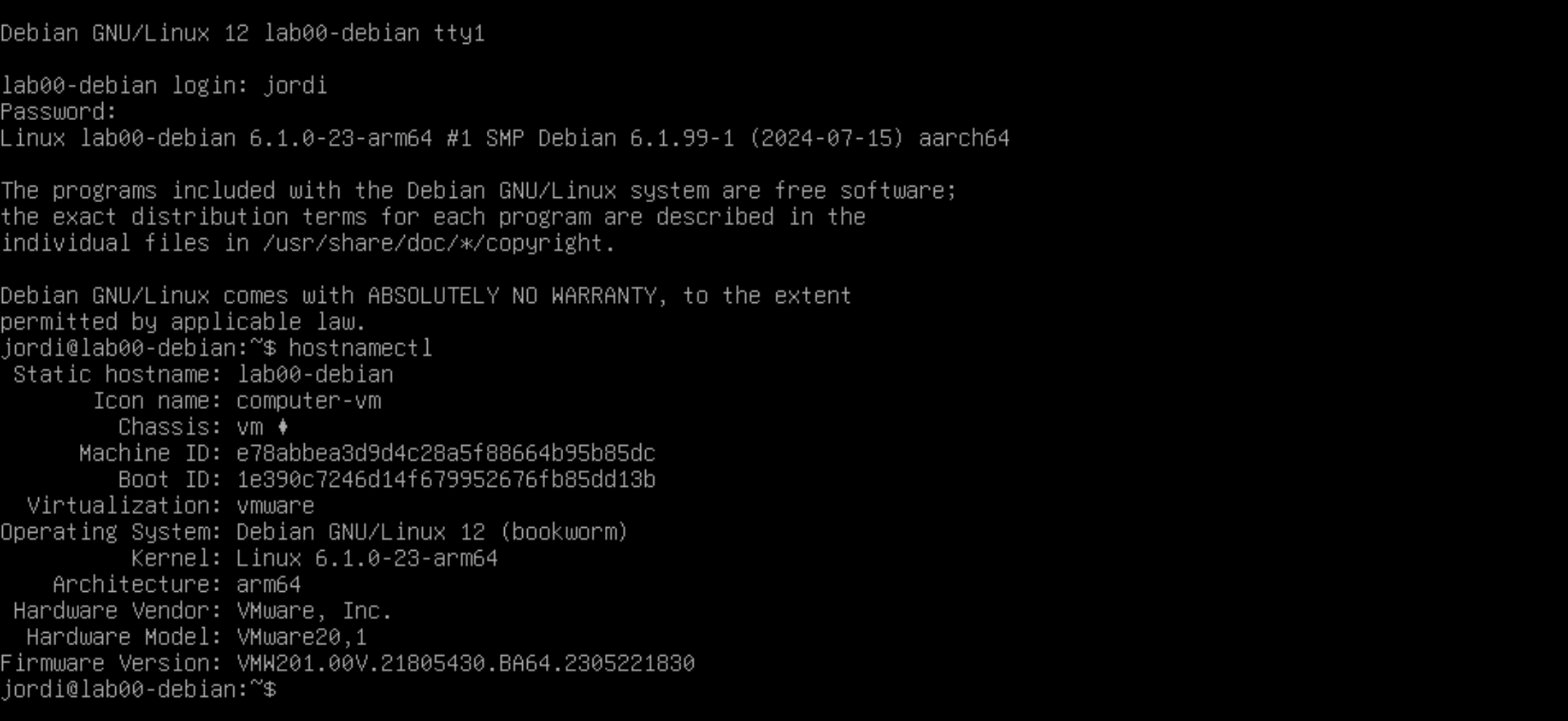

Els administradors de sistemes acostumen a administrar múltiples servidors i dispositius. Per tant, és important identificar cada dispositiu amb un nom únic per facilitar la gestió i la comunicació entre ells. El nom d'un dispositiu s'anomena nom d'amfitrió o hostname. Per a gestionar el nom d'amfitrió d'un sistema Linux, utilitzarem la comanda hostnamectl.

Comprovar el nom d'amfitrió actual

Per comprovar el nom d'amfitrió actual del vostre sistema, podeu utilitzar la comanda hostnamectl:

hostnamectl

Aquesta comanda us mostrarà informació sobre el vostre sistema, incloent el nom d'amfitrió actual.

A part del nom d'amfitrió, també podeu veure informació com la versió del sistema operatiu, el kernel, la data i l'hora actuals, etc.

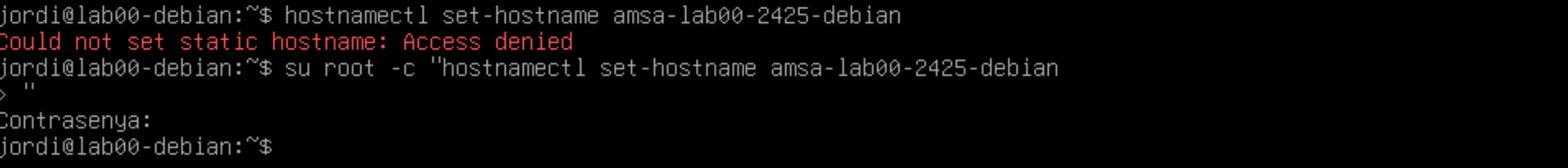

Modificar el nom d'amfitrió

Per canviar el nom d'amfitrió del vostre sistema, podeu utilitzar la comanda hostnamectl amb l'opció set-hostname. Per exemple, si voleu canviar el nom d'amfitrió a nou-nom, executeu la següent comanda:

hostnamectl set-hostname nou-nom

Aquesta comanda canviarà el nom d'amfitrió del vostre sistema a nou-nom. Si voleu comprovar que el canvi s'ha aplicat correctament, torneu a executar la comanda hostnamectl. Per aplicar el canvi, sortiu de la sessió actual exit i torneu a iniciar sessió.

🔗 Recordatori:

Cal tenir en compte que aquesta comanda requereix permisos d'administrador. Per tant, és possible que hàgiu de precedir la comanda amb

sudoo executar-la com a usuariroot.

Nom en xarxa

Hi ha dos maneres d'identificar un servidor o dispositiu connectat en una xarxa, o bé utilitzant la direcció IP del dispositiu o bé utilitzant el seu nom d'amfitrió. Per poder resoldre el nom d'amfitrió correctament, cal configurar-lo correctament en el sistema o disposar d'un servidor DNS que pugui resoldre el nom d'amfitrió en una adreça IP.

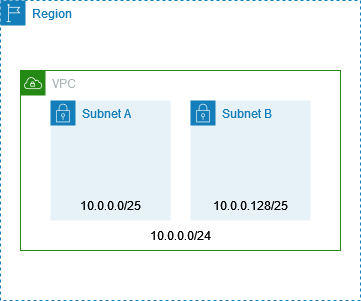

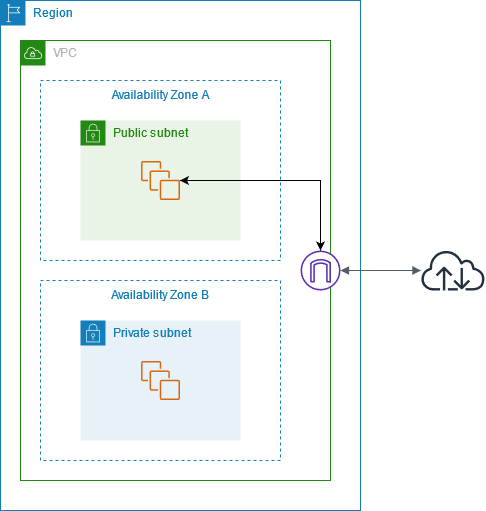

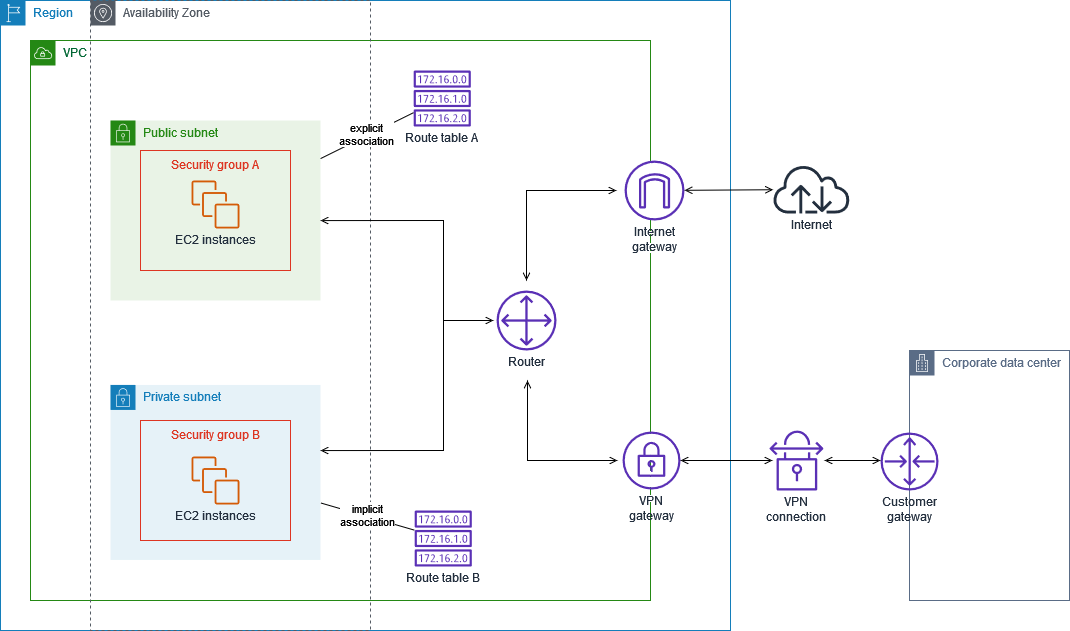

Network Address Translation (NAT)

Per defecte, VMWare utilitza una xarxa NAT per connectar les màquines virtuals. Per fer-ho, VMWare crea una xarxa privada a la qual es connecten les màquines virtuals i utilitza la xarxa de l'amfitrió per connectar-se a Internet. Això permet a les màquines virtuals connectar-se a Internet a través de l'amfitrió sense necessitat de configurar una xarxa addicional. Ara bé, això també significa que les màquines virtuals utilitzen una adreça IP privada que no és accessible des de l'exterior. Tot i això, aquesta configuració la podeu canviar si cal. Però, pels nostres laboratoris, aquesta configuració és suficient.

ℹ️ Què és NAT?

La xarxa NAT (Network Address Translation) és una tècnica que permet a diversos dispositius connectar-se a Internet utilitzant una única adreça IP pública. Aquesta tècnica és àmpliament utilitzada per a xarxes domèstiques i petites empreses per permetre a diversos dispositius connectar-se a Internet sense necessitat de disposar d'una adreça IP pública per a cada dispositiu.

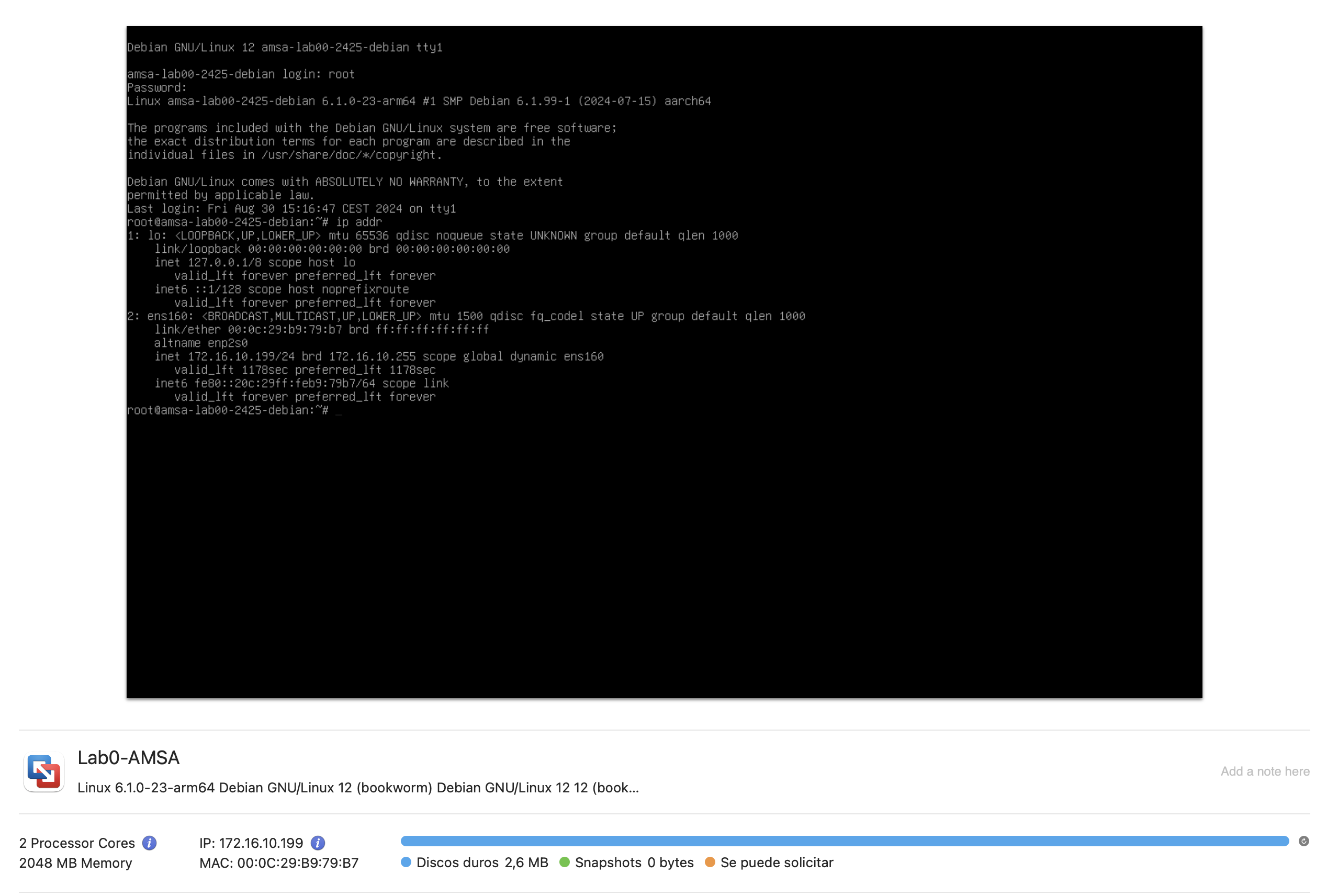

Ús de la direcció IP

La direcció IP és una forma única d'identificar un dispositiu en una xarxa. Cada dispositiu connectat a una xarxa ha d'estar configurat amb una adreça IP única per poder comunicar-se amb altres dispositius. Les adreces IP poden ser dinàmiques (assignades per un servidor DHCP) o estàtiques (configurades manualment).

Quan es crea una màquina virtual utilitzant el programari VMWare per defecte, la màquina virtual obté una adreça IP a través del servidor DHCP de VMWare. Aquesta adreça IP es pot utilitzar per accedir a la màquina virtual des de l'amfitrió o altres dispositius de la xarxa.

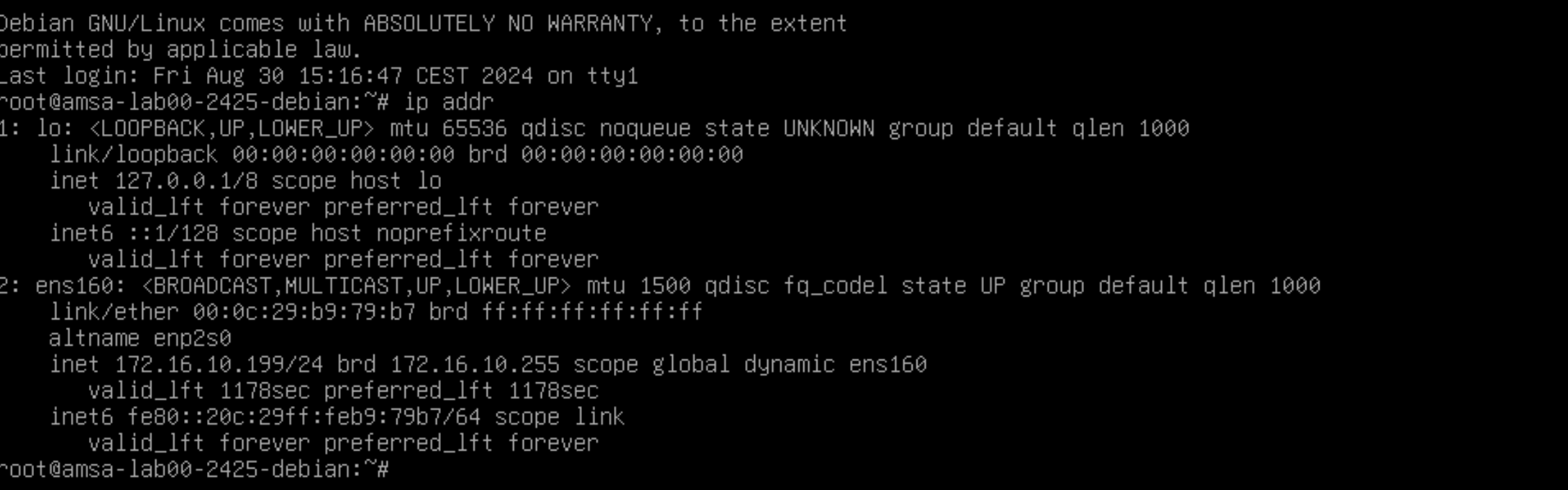

Per obtenir aquesta informació podeu consultar la interficie gràfica de VMWare o bé utilitzar la comanda ip addr en la terminal de la màquina virtual.

-

Interfície gràfica de VMWare:

-

Comanda

ip addr:ip addrAquesta comanda us mostrarà la informació de la interfície de xarxa de la màquina virtual, incloent la seva adreça IP.

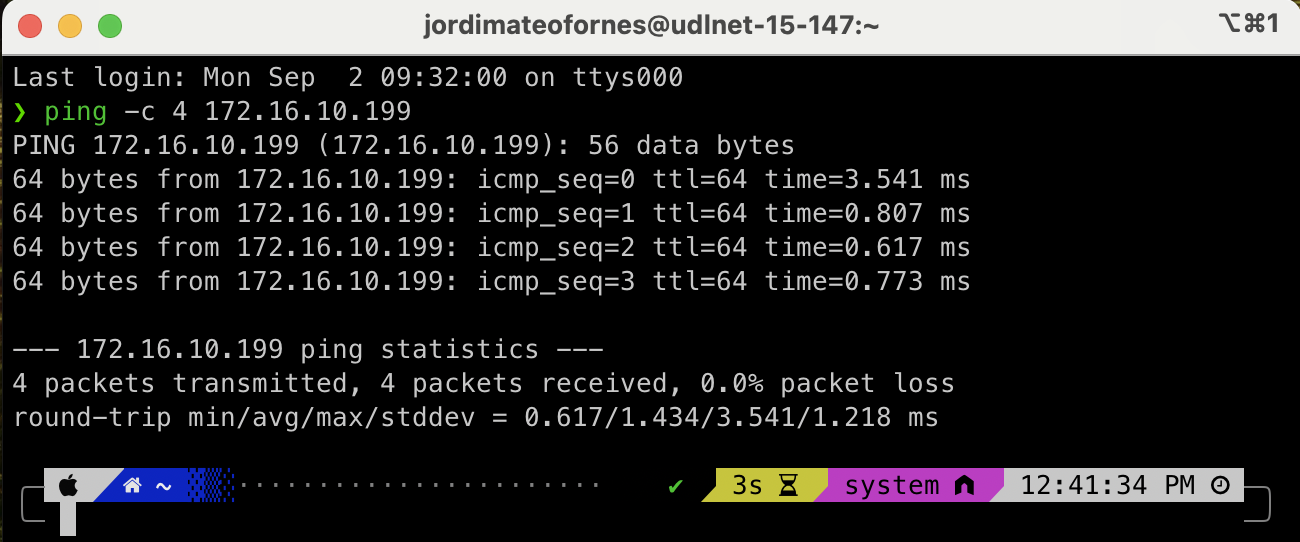

Podeu testar la connectivitat de la màquina virtual amb l'amfitrió o altres dispositius de la xarxa utilitzant la comanda ping. Per exemple, per provar la connectivitat amb l'amfitrió, podeu utilitzar la següent comanda:

ping -c 4 <adreça IP de l'amfitrió>

Ús del nom d'amfitrió

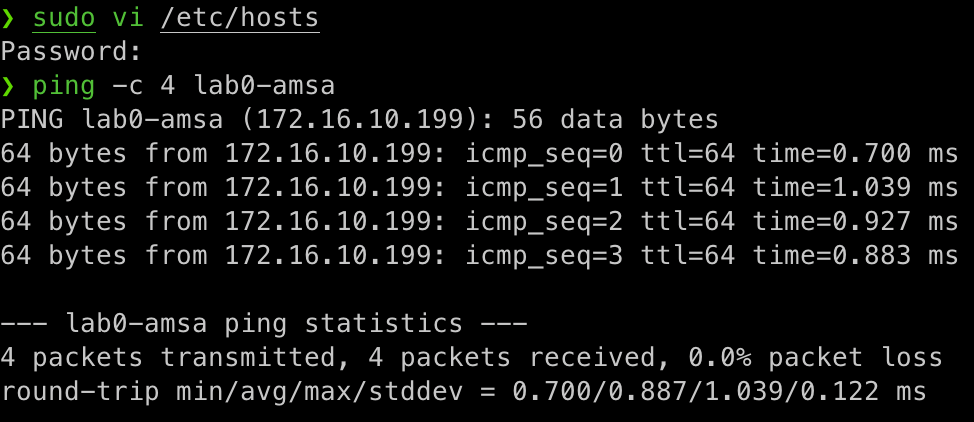

El nom d'amfitrió és una forma més fàcil de recordar i identificar un dispositiu en una xarxa. En lloc d'utilitzar una adreça IP, podeu utilitzar un nom d'amfitrió per connectar-vos a un dispositiu. Per exemple, en lloc de connectar-vos a 172.16.10.199, podeu connectar a lab0-amsa.

Per fer-ho, cal modificar la configuració del vostre ordinador local perquè pugui resoldre el nom d'amfitrió correctament. Això es pot fer afegint una entrada al fitxer /etc/hosts amb el nom d'amfitrió i la seva adreça IP. Per exemple afegint la següent línia al fitxer /etc/hosts:

# /etc/hosts

172.16.10.199 lab0-amsa

- Windows:

C:\Windows\System32\drivers\etc\hosts - Linux:

/etc/hosts - macOS:

/etc/hosts

Un cop afegida aquesta entrada, podeu provar la connectivitat amb la màquina virtual utilitzant el nom d'amfitrió:

ping -c 4 lab0-amsa

Una forma alternativa de resoldre el nom d'amfitrió és utilitzar un servidor DNS. Un servidor DNS és un servidor que tradueix els noms d'amfitrió en adreces IP i viceversa. Aquest és el cas de la majoria de xarxes corporatives i d'Internet, on es fa servir un servidor DNS per resoldre els noms de domini.

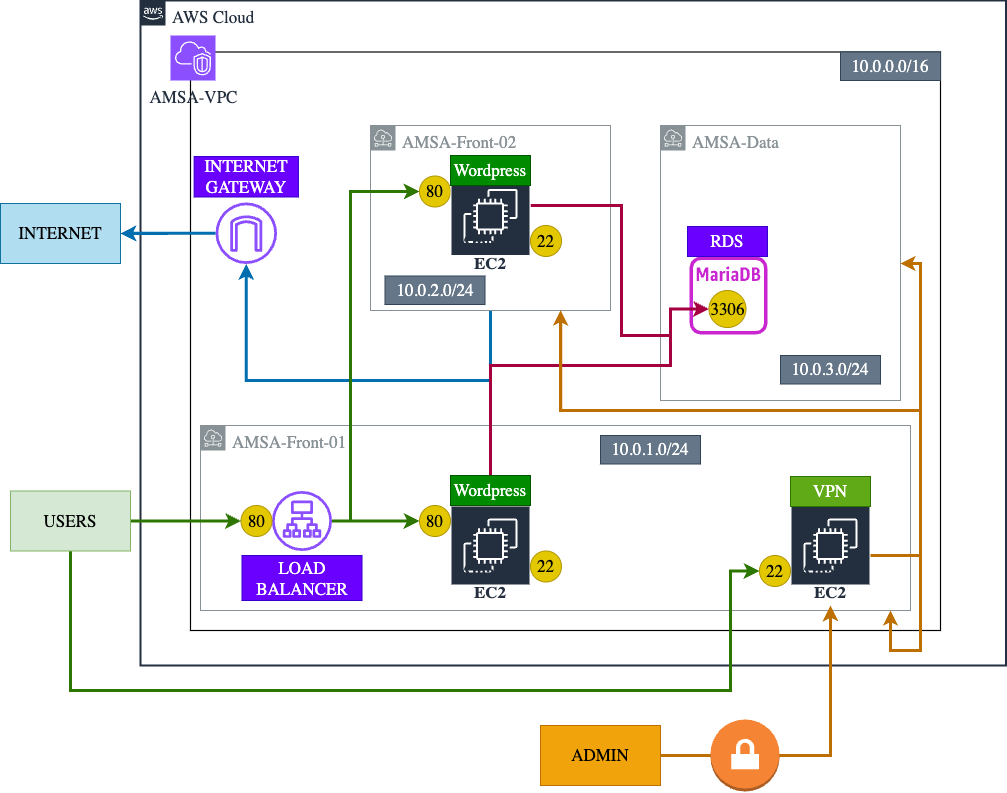

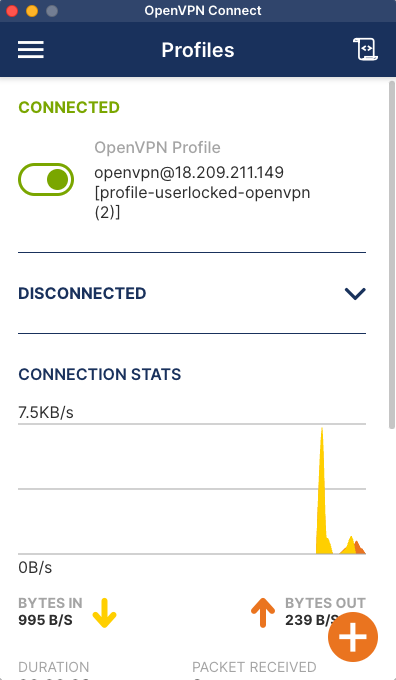

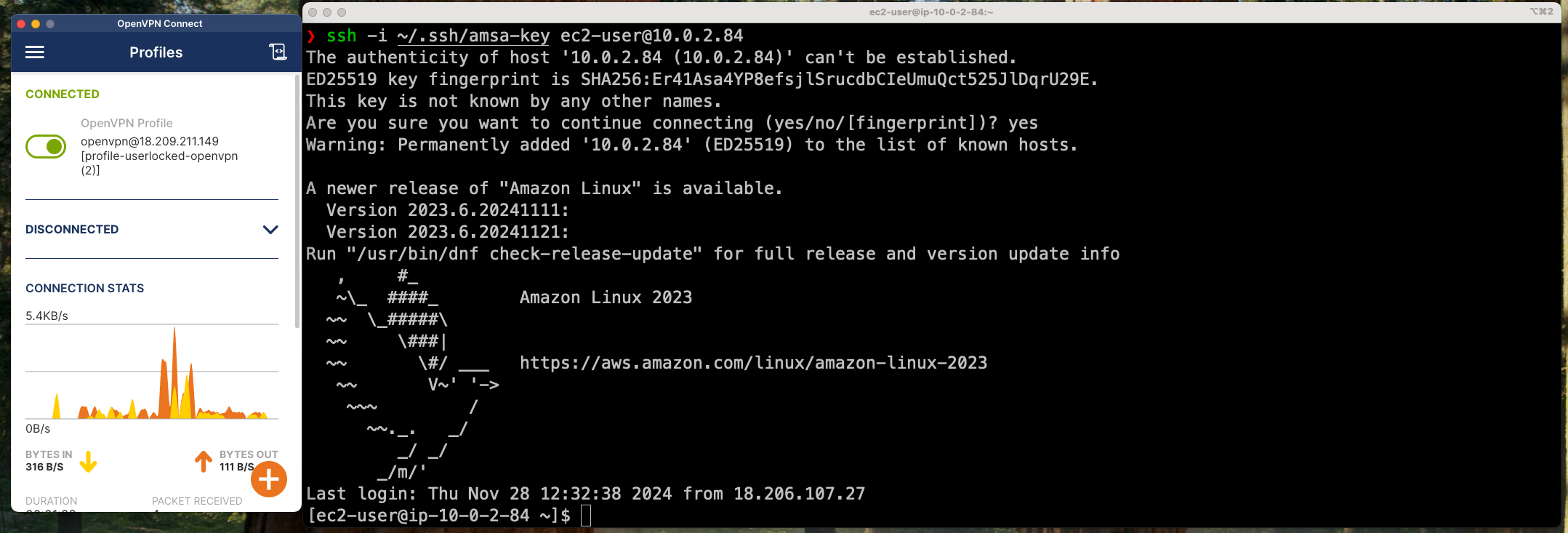

Connexió SSH i SFTP

En els nostres laboratoris, utilitzarem màquines virtuals per simular els nostres servidors. Per tant, sempre tindreu accés físic a les màquines virtuals a través de la interfície gràfica de VMWare. No obstant això, en un entorn de producció, no sempre tindreu accés físic als servidors o no us resultarà pràctic anar físicament a cada servidor per gestionar-los. Per tant, és important tenir una forma de connectar-vos als servidors de forma remota per poder gestionar-los de manera eficient.

ℹ️ Què és SSH?

SSH (Secure Shell) és un protocol de xarxa que permet als usuaris connectar-se a un dispositiu remot de forma segura. SSH utilitza una connexió xifrada per autenticar els usuaris i protegir les dades que es transmeten entre els dispositius. Això fa que SSH sigui una eina molt útil per connectar-se a servidors remots de forma segura.

ℹ️ Què és SFTP?

SFTP (SSH File Transfer Protocol) és un protocol de transferència de fitxers que permet als usuaris transferir fitxers de forma segura entre dos dispositius. SFTP utilitza SSH per autenticar els usuaris i xifrar les dades que es transmeten entre els dispositius. Això fa que SFTP sigui una eina molt útil per transferir fitxers de forma segura entre servidors remots.

ℹ️ Què és secure copy (SCP)?

SCP (Secure Copy) és una eina que permet als usuaris copiar fitxers de forma segura entre dos dispositius utilitzant SSH. SCP utilitza SSH per autenticar els usuaris i xifrar les dades que es transmeten entre els dispositius.

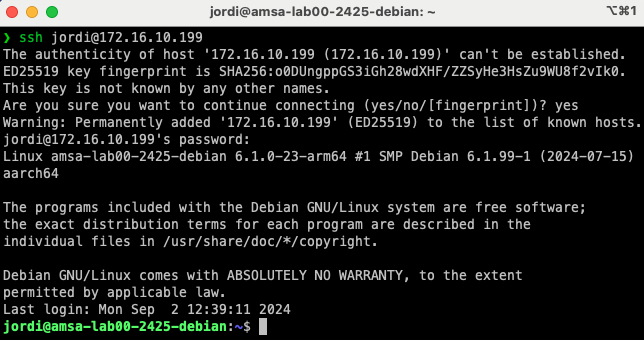

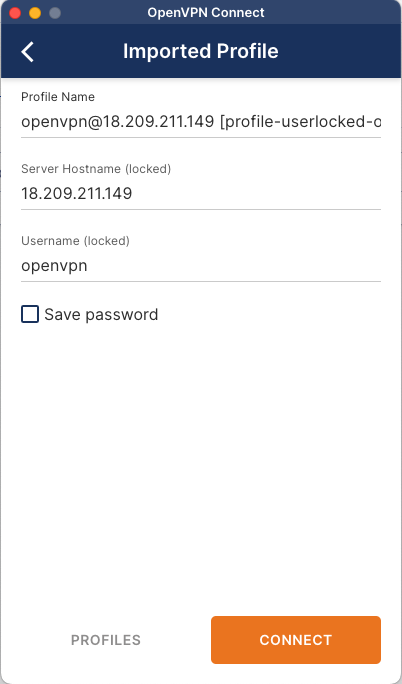

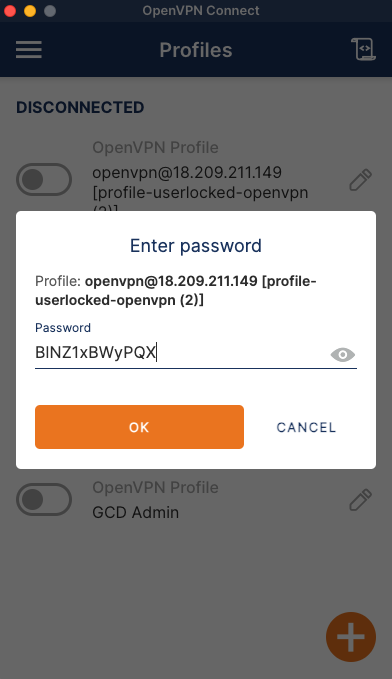

Connexió SSH entre la vostra màquina i la màquina virtual

Per connectar-vos a una màquina virtual utilitzant SSH, necessitareu l'adreça IP de la màquina virtual o bé el hostname de la màquina virtual. A més, necessitareu un client SSH instal·lat al vostre sistema local. A continuació, us mostrem com connectar-vos a una màquina virtual utilitzant SSH:

-

Mac/Linux:

ssh <usuari>@<adreça IP o hostname>

On: <usuari> és el nom d'usuari amb el qual voleu connectar-vos a la màquina virtual i <adreça IP o hostname> és l'adreça IP o el hostname de la màquina virtual a la qual voleu connectar-vos.

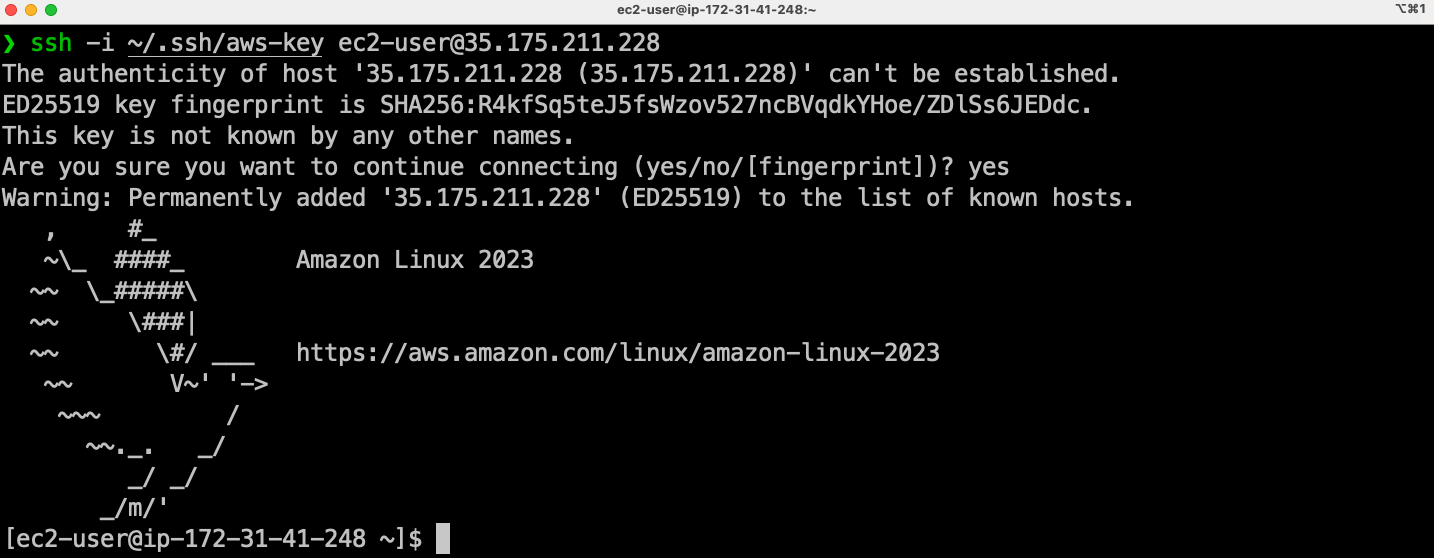

Un cop connectats, podreu interactuar amb la màquina virtual com si estiguéssiu connectats físicament a la màquina. Per sortir de la sessió SSH, executeu la comanda exit.

- Windows: Obrir una sessió de PowerShell i executar la comanda anterior. També podeu utilitzar un client SSH com PuTTY.

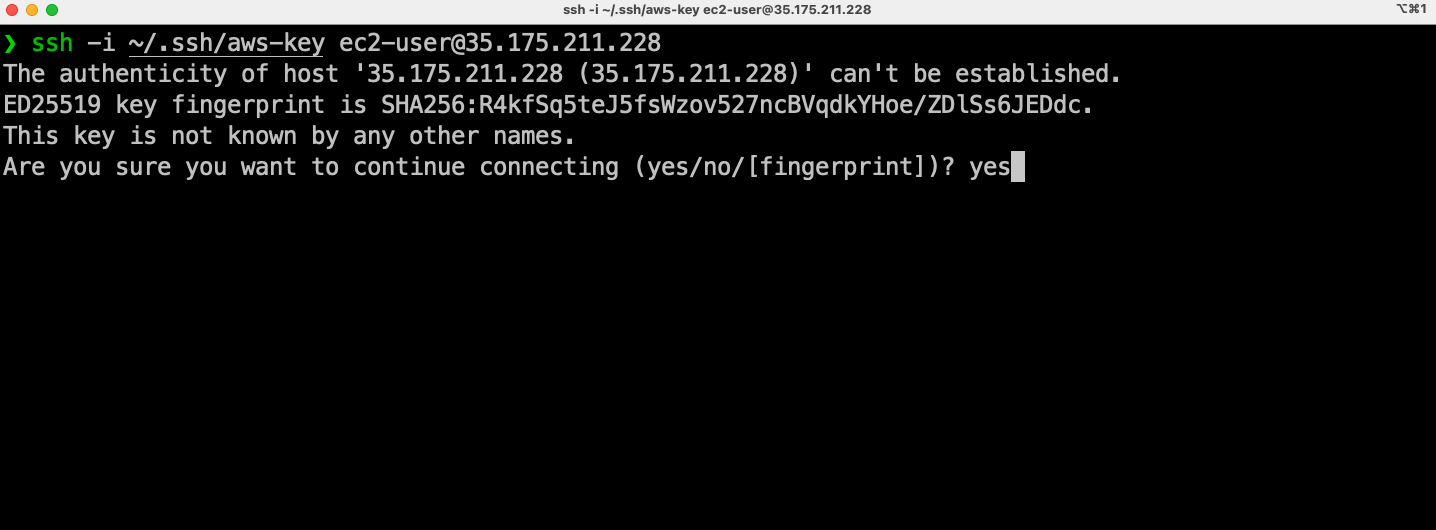

ℹ️ Què és el fingerprint que es mostra quan connecteu per primera vegada a un servidor SSH?

El fingerprint és una empremta digital única que identifica un servidor SSH. Quan connecteu per primera vegada a un servidor SSH, el vostre client SSH us mostrarà el fingerprint del servidor perquè pugueu verificar que esteu connectant-vos al servidor correcte. Això us protegeix contra atacs de suplantació de servidor.

😵💫 Troubleshooting:

Si una IP d'una màquina virtual a la qual havíeu accedit prèviament es reassigna a una altra màquina virtual i intenteu accedir a la màquina virtual original, el client SSH mostrarà un missatge d'advertència. Això succeeix perquè el fingerprint del servidor ha canviat. Quan connecteu per primera vegada a un servidor SSH, el vostre client SSH emmagatzema aquest fingerprint en el fitxer

~/.ssh/known_hostsper a futures referències.Si el fingerprint del servidor canvia (per exemple, perquè l'adreça IP s'ha reassignat a una altra màquina virtual), el client SSH detectarà aquesta discrepància i mostrarà un missatge d'advertència per protegir-vos contra possibles atacs de suplantació de servidor. Aquest missatge us informa que el servidor al qual esteu intentant connectar-vos no coincideix amb el fingerprint emmagatzemat.

Per resoldre aquest problema i poder connectar-vos al servidor, podeu eliminar l'entrada del servidor del fitxer

~/.ssh/known_hosts. Això permetrà al client SSH acceptar el nou fingerprint i establir la connexió sense mostrar l'advertència.Per resoldre aquest problema, simplement elimineu l'entrada del servidor del fitxer

~/.ssh/known_hostsi torneu a intentar connectar-vos al servidor. En el sistema operatiu Windows, el fitxerknown_hostses troba a la carpetaC:\Users\<usuari>\.ssh\known_hosts.

Transferència de fitxers amb SFTP

Per transferir fitxers entre la vostra màquina local i la màquina virtual utilitzant SFTP, necessitareu l'adreça IP de la màquina virtual o bé el hostname de la màquina virtual. A més, necessitareu un client SFTP instal·lat al vostre sistema local. A continuació, us mostrem com transferir fitxers entre la vostra màquina local i la màquina virtual utilitzant SFTP:

-

Mac/Linux:

sftp <usuari>@<adreça IP o hostname>:<ruta>On:

<ruta>és la ruta al directori de la màquina virtual on voleu transferir els fitxers.- Els fitxers es transferiran al directori actual de la vostra màquina local.

Un cop connectats, podeu utilitzar les comandes

putigetper transferir fitxers entre la vostra màquina local i la màquina virtual. Si voleu transferir un directori sencer, podeu utilitzar la comandaput -roget -r. Per acabar la sessió SFTP, executeu la comandaexit. -

Windows: Obrir una sessió de PowerShell i executar la comanda anterior. També podeu utilitzar un client SFTP com WinSCP.

Si voleu fer servir SCP en lloc de SFTP, podeu utilitzar la comanda scp en lloc de sftp. La sintaxi de la comanda scp és similar a la de la comanda cp de Linux. Per exemple, per copiar un fitxer de la vostra màquina local a la màquina virtual, executeu la següent comanda:

scp <fitxer> <usuari>@<adreça IP o hostname>:<ruta>

on:

<fitxer>és el fitxer que voleu copiar.<ruta>és la ruta al directori de la màquina virtual on voleu copiar el fitxer.- El fitxer es copiarà al directori especificat de la màquina virtual.

- Si voleu copiar un directori sencer, podeu utilitzar l'opció

-r.

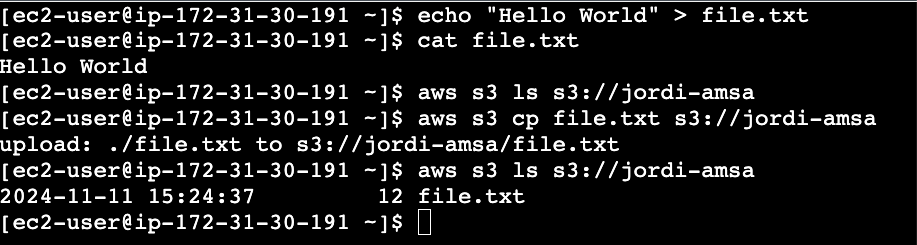

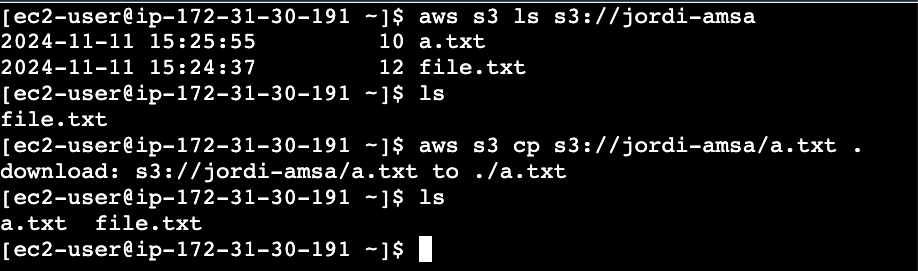

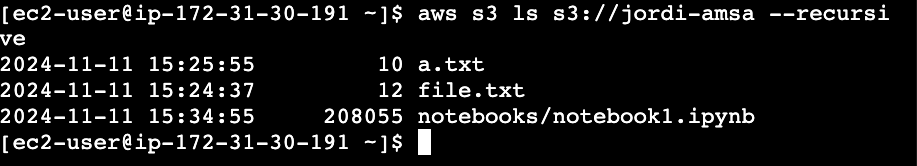

Exemple pràctic de transferència de fitxers

-

Crear un fitxer

fitxer.txta la vostra màquina local.echo "Aquest és un fitxer de prova" > fitxer.txt -

Copia el fitxer

fitxer.txta la màquina virtual a la ruta/home/usuari.- Amb scp:

scp fitxer.txt jordi@172.16.10.199:/home/jordi- Amb sftp:

sftp jordi@172.16.10.199:/home/jordi put fitxer.txt -

Edita el fitxer

fitxer.txta la màquina virtual.echo "Aquest és un fitxer de prova editat" > fitxer.txt -

Copia el fitxer

fitxer.txtde la màquina virtual a la vostra màquina local.sftp jordi@172.16.10.199:/home/jordi get fitxer.txt

Scripting

En aquest laboratori es realitzaran tasques de scripting amb Bash i Awk. Aquests llenguatges són molt utilitzats en l'administració de sistemes GNU/Linux per automatitzar tasques repetitives.

Objectius

- Repassar els conceptes bàsics de Bash estudiats al curs de Sistemes Operatius.

- Aprendre a utilitzar Awk per processar fitxers de text.

- Conèixer les diferències entre Bash i Awk.

- Combina Bash i Awk per a realitzar tasques més complexes.

Continguts

Activitat

Heu d’incorporar al repositori cinc exemples diferents, ordenats de menor a major complexitat. Cada exemple ha de ser únic i ha d’incloure una explicació detallada del que fa el codi, així com versions tant en bash com en AWK. Si l’exemple que tenies pensat ja ha estat implementat per un company, hauràs de buscar-ne un de nou. Per tant, és recomanable que revisis els exemples que ja han publicat els teus companys abans de publicar els teus propis exemples.

Rúbriques d'avaluació

Presentació d'un Pull Request amb els scripts realitzats: 100%

- Format: Markdown

- Fitxer:

Scripts/awk-repo.md

En aquest laboratori s'avaluarà la capacitat de l'estudiant per a generar nous scripts en Bash i Awk. Aquest scripts hauran de ser funcionals i correctes, així com també hauran de ser ben documentats.

| Criteris d'avaluació | Excel·lent (5) | Notable(3-4) | Acceptable(1-2) | No Acceptable (0) |

|---|---|---|---|---|

| Contingut | El contingut és molt complet i detallat. S'han cobert tots els aspectes de la tasca. | El contingut és complet i detallat. S'han cobert la majoria dels aspectes de la tasca. | El contingut és incomplet o poc detallat. Falten alguns aspectes de la tasca. | El contingut és molt incomplet o inexistent. |

| Operacionals | Els scripts generats són funcionals i correctes. No hi ha errors. | Els scripts generats són funcionals i correctes. Hi ha pocs errors. | Els scripts generats són funcionals i correctes. Hi ha errors. | Els scripts generats no són funcionals o correctes. |

| Creatius | Els scripts generats són originals i no s'han copiat de cap font. | Els scripts generats són originals i no s'han copiat de cap font. | Els scripts generats són originals i no s'han copiat de cap font. | Els scripts generats són còpia d'altres scripts. |

| Documentació | Els scripts estan ben documentats i s'ha explicat el seu funcionament. | Els scripts estan ben documentats i s'ha explicat el seu funcionament. | Els scripts estan documentats. Falta explicar el seu funcionament. | Els scripts no estan documentats. |

| Presentació | Els scripts s'han lliurat en un format adequat i s'han seguit les indicacions del professor. | Els scripts s'han lliurat en un format adequat i s'han seguit les indicacions del professor. | Els scripts s'han lliurat en un format adequat. Falten algunes indicacions del professor. | Els scripts no s'han lliurat en un format adequat. |

| Didàctics | Els scripts són fàcils de seguir i entenent per a qualsevol persona. | Els scripts són fàcils de seguir i entenent per a qualsevol persona. | Els scripts són fàcils de seguir i entenent per a qualsevol persona. | Els scripts són difícils de seguir i entenent. |

| Optimització | Els scripts són eficients i no es poden millorar. | Els scripts són eficients i no es poden millorar. | Els scripts són eficients i es poden millorar. | Els scripts no són eficients. |

Bash

En aquest laboratori repassarem els conceptes bàsics de Bash, el llenguatge de programació de scripts més utilitzat en sistemes GNU/Linux. Aquest laboratori està enfocat en repassar els conceptes bàsics que vau estudiar en l'assignatura de Sistemes Operatius.

Contextualització

En aquest laboratori crearem una aplicació per gestionar una llista de pokemons. Aquesta aplicació haurà de permetre afegir, llistar, eliminar i buscar pokemons. A més a més, haureu de fer servir un fitxer per emmagatzemar la informació dels pokemons.

Preparació

- Entorn de treball: Màquina virtual amb una distribució GNU/Linux instal·lada pot ser Debian o AlmaLinux.

Objectius

- Repassar els conceptes bàsics de Bash.

Tasques

-

Creeu un esquelet pel vostre script Bash.

#!/bin/bash # Constants # Functions # Main return 0 -

Implementeu una constant

POKEDEX_FILEamb el nom del fitxer on emmagatzemareu la informació dels pokemons.POKEDEX_FILE="pokedex.txt" -

Implementeu un menu amb la sintaxi

caseque permeti executar les següents comandes:help,list,search,deleteinew.case $1 in help) pokedex_help ;; list) pokedex_list ;; search) pokedex_search $2 ;; delete) pokedex_delete $2 ;; new) pokedex_new $2 $3 $4 $5 $6 $7 ;; *) echo "Comanda no trobada." pokedex_help ;; esac -

Implementeu la funció

pokedex_helpque mostri per pantalla les instruccions d'ús del script.function pokedex_help() { echo "Ús: ./pokedex.sh <comanda> <arguments>" echo "Comandes:" echo " list: Llistar pokemons" echo " search <name>: Buscar pokemon" echo " delete <name>: Eliminar pokemon" echo " new <name> <type> <hp> <attack> <defense> <speed>: Afegir pokemon" } -

Implementeu la funció

pokedex_listque llegeixi el fitxerPOKEDEX_FILEi mostri per pantalla la llista de pokemons.- Podeu fer servir la comanda

catper llegir el fitxerPOKEDEX_FILE.

function pokedex_list() { cat $POKEDEX_FILE }- Assegureu-vos que existeix el fitxer

POKEDEX_FILE.

if [[ ! -f $POKEDEX_FILE ]]; then echo "El fitxer $POKEDEX_FILE no existeix." return 1 fi - Podeu fer servir la comanda

-

Implementeu la funció

pokedex_search <name>que llegeixi el fitxerPOKEDEX_FILEi mostri per pantalla la informació del pokemon amb nom<name>.- Podeu fer servir la comanda

grepper buscar el pokemon amb nom<name>.

function pokedex_search() { grep $1 $POKEDEX_FILE }- Assegureu-vos que la funció

pokedex_searchrep un argument.

if [[ -z $1 ]]; then echo "Has d'indicar el nom del pokemon." echo "Ús: ./pokedex.sh search <name>" return 1 fi - Podeu fer servir la comanda

-

Implementeu la funció

pokedex_delete <name>que elimini el pokemon amb nom<name>del fitxerPOKEDEX_FILE.- Podeu fer servir la comanda

sedper eliminar el pokemon amb nom<name>.

function pokedex_delete() { sed -i "/$1/d" $POKEDEX_FILE }- Assegureu-vos que la funció

pokedex_deleterep un argument.

if [[ -z $1 ]]; then echo "Has d'indicar el nom del pokemon." echo "Ús: ./pokedex.sh delete <name>" return 1 fi - Podeu fer servir la comanda

-

Implementeu la funció

pokedex_new <name> <type> <hp> <attack> <defense> <speed>que permet afegir un nou pokemon a la pokedex.- Podeu fer servir la comanda

echoper afegir el nou pokemon al fitxerPOKEDEX_FILE.

function pokedex_new() { echo "$1 $2 $3 $4 $5 $6" >> $POKEDEX_FILE }- Assegureu-vos que la funció

pokedex_newrep tots els arguments necessaris.

if [[ -z $1 || -z $2 || -z $3 || -z $4 || -z $5 || -z $6 ]]; then echo "Has d'indicar el nom, tipus, hp, attack, defense i speed del pokemon." echo "Ús: ./pokedex.sh new <name> <type> <hp> <attack> <defense> <speed>" return 1 fi - Podeu fer servir la comanda

Introducció al llenguatge AWK

Objectius

- Entendre la sintaxi bàsica d'AWK.

- Aprendre a utilitzar AWK per processar fitxers de text.

- Entendre les diferències entre AWK i BASH.

Prerequisits

- Una màquina virtual amb sistema operatiu Linux, preferiblement AlmaLinux 9.4. Es recomana accedir a la màquina virtual mitjançant SSH.

Què és AWK?

AWK és un llenguatge de programació potent i versàtil, dissenyat específicament per a l’anàlisi de patrons i el processament de text. La seva funció principal és processar fitxers de text de manera eficient, permetent la transformació de dades, la generació d’informes i la filtració de dades.

Pràcticament tots els sistemes Unix disposen d’una implementació d’AWK. Això inclou sistemes operatius com GNU/Linux, macOS, BSD, Solaris, AIX, HP-UX, entre d’altres. Per consultar el manual d’AWK, pots utilitzar la comanda man awk. Per consultar la versió d’AWK instal·lada al teu sistema, pots utilitzar la comanda awk -W version.

AWK es caracteritza per ser compacte, ràpid i senzill, amb un llenguatge d’entrada net i comprensible que recorda al llenguatge de programació C. Disposa de construccions de programació robustes que inclouen if/else, while, do/while, entre d’altres. L’eina AWK processa una llista de fitxers com a arguments. En cas de no proporcionar fitxers, AWK llegeix de l’entrada estàndard, permetent així la seva combinació amb pipes per a operacions més complexes.

Utilització de l'eina AWK

Pots trobar tota la informació sobre el funcionament de l’eina AWK a la pàgina de manual. Per exemple, per obtenir informació sobre la comanda awk, pots utilitzar la comanda man awk. Aquesta comanda et proporcionarà tota la informació necessària per utilitzar l’eina AWK.

-

Pots utilitzar l’eina amb el codi escrit directament acció-awk a la línia de comandes o combinada en un script:

awk [-F] '{acció-awk}' [ fitxer1 ... fitxerN ] -

També pots utilitzar l’eina amb tota la sintaxi awk guardada en un fitxer script-awk des de la línia de comandes o combinada amb altres scripts:

awk [-F] -f script-awk [ fitxer1 ... fitxerN ]

En aquests exemples, [-F] és una opció que permet especificar el caràcter delimitador de camps, {acció-awk} és el codi AWK que vols executar, i [ fitxer1 ... fitxerN ] són els fitxers d’entrada que AWK processarà. Si no s’especifica cap fitxer, AWK llegirà de l’entrada estàndard.

Fitxer de Dades d'Exemple per utilitzar en aquest Laboratori

En aquest laboratori, farem servir un fitxer de dades específic com a conjunt de dades d’exemple. Aquest fitxer representa una pokedex i es pot obtenir amb la següent comanda:

curl -O https://gist.githubusercontent.com/armgilles/194bcff35001e7eb53a2a8b441e8b2c6/raw/92200bc0a673d5ce2110aaad4544ed6c4010f687/pokemon.csv

Aquest fitxer conté 801 línies (800 pokemons + 1 capçalera) i 13 columnes. Les columnes són les següents:

- #: Número de pokémon

- Name: Nom del pokémon

- Type 1: Tipus 1 del pokémon

- Type 2: Tipus 2 del pokémon

- Total: Total de punts de tots els atributs

- HP: Punts de vida

- Attack: Atac

- Defense: Defensa

- Sp. Atk: Atac especial

- Sp. Def: Defensa especial

- Speed: Velocitat

- Generation: Generació

- Legendary: Llegendari (0: No, 1: Sí)

Per comprovar aquestes dades, podem fer servir les següents comandes:

-

Utilitzeu la comanda

wcper comptar el nombre de línies del fitxer:wc -l pokemon.csv -

Utilitzeu la comanda

headper mostrar les primeres 10 línies del fitxer:head pokemon.csv -

Utilitzeu les comandes

wciheadper comptar el nombre de columnes del fitxer. Recordeu que les columnes estan separades per comes:head -1 pokemon.csv | tr ',' '\n' | wc -l

Awk - Bàsic

Estrucutra Bàsica d'AWK

El llenguatge AWK s'organitza amb duples de la forma patró { acció }. El patró pot ser una expressió regular o una condició lògica. L’acció és el que es vol realitzar amb les línies que compleixen el patró. Per tant, AWK processa els fitxers línia per línia. Per cada línia del fitxer, AWK avalua el patró. Si el patró és cert, executa l’acció. Si el patró és fals, passa a la següent línia.

Per exemple, si volem imprimir totes les línies d'un fitxer (acció) que contenten una expressió regular definida a regex (patró), podem fer servir la següent sintaxi:

awk '/regex/ { print }' fitxer

Observeu que utilitzem el caràcter / per indicar que el patró és una expressió regular.

A més, AWK ens permet utilitzar una estructura de control BEGIN i END. La clàusula BEGIN s'executa abans de processar qualsevol línia i la clàusula END s'executa després de processar totes les línies. Aquestes clausules són opcionals i no són necessàries en tots els casos.

BEGIN { acció }

patró { acció }

END { acció }

Per exemple, si volem indicar que estem començant a processar un fitxer, podem fer servir la clàusula BEGIN. I si volem indicar que hem acabat de processar el fitxer, podem fer servir la clàusula END. A continuació, teniu un exemple de com utilitzar les clàusules BEGIN i END:

awk '

BEGIN { print "Començant a processar el fitxer..." }

/regex/ { print }

END { print "Finalitzant el processament del fitxer..." }

' fitxer

Aprenent a utilitzar AWK amb Exemples

Sintaxis Bàsica

En aquesta secció veurem com podem utiltizar AWK per substituir algunes comandes bàsiques de bash com cat, grep, cut.

cat

La comanda cat ens permet mostrar el contingut d'un fitxer. Per exemple, per mostrar el contingut del fitxer pokemon.csv:

cat pokemon.csv

Podem fer servir AWK per fer el mateix. Per exemple, per mostrar el contingut del fitxer pokemon.csv:

awk '{print}' pokemon.csv

on {print} és l'acció que volem realitzar. En aquest cas, volem imprimir totes les línies del fitxer. Això és equivalent a la comanda cat.

AWK també ens permet acompanyar l'acció amb variables. Per exemple, la variable $0 conté tota la línia. Per tant, podem utilitzar la variable $0 per imprimir totes les línies del fitxer:

awk '{print $0}' pokemon.csv

Nota: AWK processa els fitxers línia per línia. Per cada línia del fitxer, AWK avalua l'acció. Es a dir, amb la comanda awk '{print $0}' pokemon.csv estem indicant que per cada línia del fitxer, imprimeixi la línia sencera. Per tant, aquesta comanda és equivalent a la comanda cat.

Podeu comparar les sortides de les comandes cat i awk per assegurar-vos que són les mateixes utilitzant la comanda diff:

diff <(cat pokemon.csv) <(awk '{print $0}' pokemon.csv)

grep

La comanda grep ens permet cercar patrons en un fitxer. Per exemple, per mostrar totes les línies que contenen la paraula "Char" al fitxer pokemon.csv:

grep Char pokemon.csv

Podem fer servir AWK per fer el mateix. Per exemple, per mostrar totes les línies que contenen la paraula "Char" al fitxer pokemon.csv:

awk '/Char/ {print}' pokemon.csv

on /Char/ és el patró que volem cercar. Per tant, tenim un patró de cerca i una acció a realitzar. En aquest cas, estem cercant linia per linia la paraula "Char" i si la trobem, imprimim tota la línia. Això és equivalent a la comanda grep.

Una confusió comuna es pensar que l'expressió /Char/ indica que la línia comença per "Char". Això no és cert. L'expressió /Char/ indica que la línia conté la paraula "Char". Per exemple, podem buscar totes les línies del fitxer pokemon.csv que contenen el patró "ois":

awk '/ois/ {print}' pokemon.csv

En la sortida, veureu que tant les paraules "poison" del tipus de pokémon com els diferents noms de pokémon que contenen la paraula "ois" són mostrats.

1,Bulbasaur,Grass,Poison,318,45,49,49,65,65,45,1,False

9,Blastoise,Water,-,530,79,83,100,85,105,78,1,False

...

71,Victreebel,Grass,Poison,490,80,105,65,100,70,70,1,False

...

691,Dragalge,Poison,Dragon,494,65,75,90,97,123,44,6,False

Conteu quantes línies compleixen aquest patró, combinant AWK amb la comanda wc:

awk '/ois/ {print}' pokemon.csv | wc -l

En aquest cas, hi ha 64 entrades que satisfan aquest patró.

cut

La comanda cut ens permet extreure columnes d'un fitxer. Per exemple, per mostrar només la primera columna del fitxer pokemon.csv:

cut -d, -f1 pokemon.csv

on -d, indica que el separador de camps és la coma i -f1 indica que volem la primera columna. Podem fer servir AWK per fer el mateix. Per exemple, per mostrar només la primera columna del fitxer pokemon.csv:

awk -F, '{print $1}' pokemon.csv

on -F, indica que el separador de camps és la coma i {print $1} indica que volem la primera columna. Això és equivalent a la comanda cut.

Cada item separat pel separador de camps es denomina camp. Per exemple, en el fitxer pokemon.csv, cada columna separada per una coma és un camp. Per defecte, el separador de camps és l'espai en blanc. Per tant, si no especifiquem el separador de camps, AWK utilitzarà l'espai en blanc com a separador de camps.

Si intentem imprimir la tercera columna sense especificar el separador de camps, la sortida no serà correcta:

awk '{print $3}' pokemon.csv

Això és degut a que el separador de camps per defecte és l'espai en blanc i no la coma. Ara bé, si modifiquem el separador de camps a l'espai en blanc, enlloc de la coma, podem obtenir la sortida correcta:

sed 's/,/ /g' pokemon.csv | awk '{print $3}'

En aquest cas, estem substituint totes les comes per espais en blanc i després utilitzant AWK per imprimir la tercera columna.

Verificacions lògiques

Es pot utilitzar com a patró una expressió composta amb operadors i retornar true o false.

| Operador | Significat |

|---|---|

| < | Menor |

| > | Major |

| <= | Menor o igual |

| >= | Major o igual |

| == | Igualtat |

| != | Desigualtat |

| ~ | Correspondència amb expressió regular |

| !~ | No correspondència amb expressió regular |

| ! | Negació |

| && | AND |

| || | OR |

| () | Agrupació |

Per utilizar aquestes expressions, podem fer servir la següent sintaxi:

awk 'patró { acció }' fitxer

on el patró és una expressió composta amb operadors lògics i l'acció és el que es vol fer amb les línies que compleixen el patró. Per exemple:

-

Mostrar tots els pokemons que tenen més de 100 punts d'atac (valor de la columna 7):

awk -F, '$7 > 100 {print}' pokemon.csv -

Mostrar tots els pokemons que tenen més de 100 punts d'atac (valor de la columna 7) i són de la primera generació (valor de la columna 12):

awk -F, '$7 > 100 && $12 == 1 {print}' pokemon.csv -

Mostrar tots els pokemons que tenen més de 100 punts d'atac (valor de la columna 7) o són de la primera generació (valor de la columna 12):

awk -F, '$7 > 100 || $12 == 1 {print}' pokemon.csv -

Mostrar tots els pokemons que són Mega pokemons (contenen la paraula "Mega" a la columna 2):

awk -F, '$2 ~ /Mega/ {print}' pokemon.csv -

Mostra tots els pokemons que no són Mega pokemons (no contenen la paraula "Mega" a la columna 2):

awk -F, '$2 !~ /Mega/ {print}' pokemon.csv

Exercicis Bàsics

Aquests exercicis estan resolts en bash i en AWK. Podeu provar-los en el vostre sistema per entendre com funcionen. Intenta resoldre primer els exercicis en bash i després en AWK. Un cop pensada la solució, podeu comparar-la amb la solució proporcionada.

-

Implementeu una comanda que permeti filtrar tots els pokemon de tipus foc (Foc) i imprimir únicament per stdout el nom i els seus tipus (columnes 2, 3 i 4).

- En bash podem fer servir la comanda grep per filtrar les línies que contenen la paraula "Fire" i la comanda cut per extreure les columnes 2, 3 i 4:

grep Fire pokemon.csv | cut -d, -f2,3,4- En AWK:

awk -F, '/Fire/ {print $2,$3,$4}' pokemon.csv -

Implementeu una comanda que permeti imprimir totes les línies que continguin una 'b' o una 'B' seguida de "ut". Mostra només el nom del pokémon (columna 2).

- En AWk podem fer servir l'expressió regular [bB]ut:

awk -F, '/[bB]ut/ {print $2}' pokemon.csv- En bash podem fer servir la comanda grep amb l'argument -i per ignorar la diferència entre majúscules i minúscules:

grep -i "but" pokemon.csv | cut -d, -f2 -

Implementeu una comanda que permeti imprimir totes les línies que comencin per un "K" majúscula. Mostra només el nom del pokémon (columna 2).

- En bash podem fer servir la comanda grep amb el meta caràcter ^ per indicar que la línia comença per "K" majúscula:

grep "^K" pokemon.csv | cut -d, -f2- En AWK:

awk -F, '$2 ~ /^K/ {print $2}' pokemon.csv!Compte: Per defecte, les expressions regulars actuen sobre tota la línia $0. Si voleu aplicar l'expressió regular a una columna determinada, necessiteu l'operador (~). Si intenteu aplicar:

awk -F,'/^K/ {print $2}' pokemon.csvno funcionarà ja que l'inici ^ de $0 serà un enter. -

Imprimiu tots els pokemons que siguin del tipus foc o lluita. Imprimiu el nom, tipus 1 i tipus 2. Podeu fer servir l'operador | per crear l'expressió regular.

- En AWK podem fer servir l'operador | per combinar dos patrons:

awk -F, '/Fire|Fighting/ {print $2,$3,$4}' pokemon.csv- En bash, podeu fer servir l'argument -E per utilitzar expressions regulars exteses amb la comanda grep:

grep -E "Fire|Fighting" pokemon.csv | cut -d, -f2,3,4 -

Imprimiu tots els pokemons que siguin del tipus foc i lluita. Imprimiu el nom, tipus 1 i tipus 2. Podeu fer servir l'operador && per crear l'expressió regular.

- En AWK podem fer servir l'operador && per combinar dos patrons:

awk -F, '/Fire/ && /Fighting/ {print $2,$3,$4}' pokemon.csv- En bash, podeu fer servir l'argument -E per utilitzar expressions regulars exteses amb la comanda grep:

grep -E "Fire.*Fighting|Fighting.*Fire" pokemon.csv | cut -d, -f2,3,4En aquest cas no podem fer servir l'operador && ja que grep no permet aquesta funcionalitat. Per tant, hem de fer servir l'operador | per combinar els dos patrons. A més, hem de fer servir l'expressió regular **Fire.Fighting|Fighting.Fire per indicar que volem les línies que contenen "Fire" seguit de "Fighting" o "Fighting" seguit de "Fire".

-

Imprimiu el nom de tots els pokemons de la primera generació que siguin llegendaris. Per fer-ho utilitzeu les columnes 12 i 13. La columna 12 indica la generació amb valors númerics (1,2,3,...) i la columna 13 indica si un pokémon és llegendari o no (0: No, 1: Sí).

- En AWK podem fer servir l'operador && per combinar dos patrons:

awk -F, '$12 == 1 && $13 == "True" {print $2}' pokemon.csv- En bash, podem fer servir la comanda grep per filtrar les línies que contenen la primera generació i són llegendaris i la comanda cut per extreure la columna 2:

grep "1,True" pokemon.csv | cut -d, -f2Aquesta solució no és la més òptima, ja que es podria donar el cas que altres columnes continguessin la paraula "1,True". Per solucionar-ho podem fer un script més complex que comprovi que la columna 12 conté el valor 1 i la columna 13 conté la paraula "True".

#!/bin/bash while IFS=, read -r col1 col2 col3 col4 col5 col6 col7 col8 col9 col10 col11 col12 col13; do if [[ "$col12" == "1" ]] && [[ "$col13" == "True" ]]; then echo "$col2" fi done < pokemon.csv

Awk - Intermedi

Variables en AWK

El llenguatge de programació AWK ens permet definir variables i utilitzar-les en les nostres accions. Les variables en AWK són dinàmiques i no necessiten ser declarades abans d'utilitzar-les. Això significa que podem utilitzar una variable sense haver-la declarat prèviament.

Per exemple, si volem comptar el nombre de línies que hi ha al fitxer pokemon.csv, podem fer servir una variable per a emmagatzemar el nombre de línies. A continuació, mostrem un exemple de com comptar el nombre de línies del fitxer pokemon.csv:

awk 'BEGIN { n=0 } { ++n } END{ print n }' pokemon.csv

On n és la variable que utilitzem per emmagatzemar el nombre de línies. Per començar, inicialitzem la variable n a 0 amb la clàusula {BEGIN}. Aquesta clausula és opcional, ja que les variables en AWK són dinàmiques i no necessiten ser declarades prèviament. Després, incrementem la variable n per a cada línia amb la clàusula {++n}. Finalment, utilitzem la clàusula {END} per imprimir el valor de la variable n després de processar totes les línies.

Operacions Aritmètiques

| Operador | Aritat | Signigicat |

|---|---|---|

| + | Binari | Suma |

| - | Binari | Resta |

| * | Binari | Multiplicació |

| / | Binari | Divisió |

| % | Binari | Mòdul |

| ^ | Binari | Exponent |

| ++ | Unari | Increment 1 unitat |

| -- | Unari | Decrement 1 unitat |

| += | Binari | x = x+y |

| -= | Binari | x = x-y |

| *= | Binari | x=x*y |

| /= | Binari | x=x/y |

| %= | Binari | x=x%y |

| ^= | Binari | x=x^y |

Implementeu un script que comprovi que el Total (columna 5) és la suma de tots els atributs (columnes 6,7,8,9,10 i 11). La sortida ha de ser semblant a:

Charmander->Total=309==309

Charmeleon->Total=405==405

Charizard->Total=534==534

-

En AWK:

awk -F, '{ print $2"->Total="$5"=="($6+$7+$8+$9+$10+$11)}' pokemon.csv -

En bash:

#!/bin/bash while IFS=, read -r col1 col2 col3 col4 col5 col6 col7 col8 col9 col10 col11 col12 col13; do if [[ "$col5" == "$((col6+col7+col8+col9+col10+col11))" ]]; then echo "$col2->Total=$col5==$((col6+col7+col8+col9+col10+col11))" fi done < pokemon.csv

Variables Internes

AWK té variables internes que són molt útils per a la manipulació de dades. Aquestes variables són:

| Variable | Contingut |

|---|---|

| $0 | Conté tot el registre actual |

| NF | Conté el valor del camp (columna) actual. |

| $1,$2..., | $1 conté el valor del primer camp i així fins l'últim camp. noteu que $NF serà substituït al final pel valor de l'últim camp. |

| NR | Índex del registre actual. Per tant, quan es processa la primera línia aquesta variable té el valor 1 i quan acaba conté el nombre de línies processades. |

| FNR | Índex del fitxer actual que estem processant. |

| FILENAME | Nom del fitxer que estem processant. |

Per exemple:

-

Utilitzeu la variable NR per simplificar la comanda per comptar el nombre de línies del fitxer pokemon.csv:

awk 'END{ print NR }' pokemon.csv -

Traduïu la capçalera del fitxer pokemon.csv al catala. La capçalera és la següent: # Name Type 1 Type 2 Total HP Attack Defense Sp. Atk Sp. Def Speed Generation Legendary. La traducció és la següent: # Nom Tipus 1 Tipus 2 Total HP Atac Defensa Atac Especial Defensa Especial Velocitat Generació Llegendari. I després imprimiu la resta de línies del fitxer.

awk 'NR==1 { $1="#"; $2="Nom"; $3="Tipus 1"; $4="Tipus 2"; $5="Total"; $6="HP"; $7="Atac"; $8="Defensa"; $9="Atac Especial"; $10="Defensa Especial"; $11="Velocitat"; $12="Generació"; $13="Llegendari"; print $0 } NR>1 {print}' pokemon.csv -

Implementeu una comanda que permeti detectar entrades incorrectes a la pokedex. Un entrada incorrecta és aquella que no té 13 valors per línia. En cas de detectar una entrada incorrecta, la eliminarem de la sortida i comptarem el nombre de línies eliminades per mostrar-ho al final.

awk 'NF != 13 { n++ } NF == 13 { print } END{ print "There are ", n, "incorrect entries." }' pokemon.csv

Condicionals

Les sentències condicionals s'utilitzen en qualsevol llenguatge de programació per executar qualsevol sentència basada en una condició particular. Es basa en avaluar el valor true o false en les declaracions if-else i if-elseif. AWK admet tot tipus de sentències condicionals com altres llenguatges de programació.

Implementeu una comanda que us indiqui quins pokemons de tipus foc són ordinaris o llegendaris. Busquem una sortida semblant a:

Charmander is a common pokemon.

Charizard is a legendary pokemon.

...

La condició per ser un pokémon llegendari és que la columna 13 sigui True.

awk -F, '/Fire/ { if ($13 == "True") { print $2, "is a legendary pokemon." } else { print $2, "is a common pokemon." } }' pokemon.csv

Es pot simplificar la comanda anterior amb l'ús de l'operador ternari ?::

awk -F, '/Fire/ { print $2, "is a", ($13 == "True" ? "legendary" : "common"), "pokemon." }' pokemon.csv

Formatant la sortida

AWK ens permet també utilitzar una funció semblant al printf de C. Permet imprimir la cadena

amb diferents formats: printf("cadena",expr1,,expr2,...)

| %20s | Es mostraran 20 caràcters de la cadena alineats a la dreta per defecte. |

| %-20s | Es mostraran 20 caràcters de la cadena alineats a l'esquerra per defecte. |

| %3d | Es mostrarà un enter de 3 posicions alineat a la dreta |

| %03d | Es mostrarà un enter de 3 posicions completat amb un 0 a l'esquerra i tot alineat a la dreta |

| %-3d | Es mostrarà un enter de 3 posicions alineat a la esquerra. |

| &+3d | Idem amb signe i alineat a la dreta |

| %10.2f | Es mostrarà un nombre amb coma flotant amb 10 posicions, 2 de les quals seràn decimals. |

Per exemple:

awk -F, \

' BEGIN{

max=0

min=100

}

{

if ($3 =="Fire") {

n++

attack+=$7

if ($7 > max){

pmax=$2

max=$7

}

if ($7 < min){

pmin=$2

min=$7

}

}

}

END{ printf("Avg(Attack):%4.2f \nWeakest:%s \nStrongest:%s\n",attack/n,pmin,pmax)

}' pokemon.csv

Exercicis Intermedis

-

Implementeu un script que compti tots els pokemons que tenim a la pokedex i que tingui la sortida següent:

Counting pokemons... There are 800 pokemons.Recordeu que la primera línia és la capçalera i no la volem comptar.

-

En bash:

!/bin/bash echo "Counting pokemons..." n=`wc -l pokemon.csv` n=`expr $n - 1` echo "There are $n pokemons." -

En AWK:

awk 'BEGIN { print "Counting pokemons..." } { ++n } END{ print "There are ", n-1, "pokemons." }' pokemon.csv

-

-

Implementeu un comptador per saber tots els pokemons de tipus foc de la primera generació descartant els Mega pokemons i que tingui la sortida següent:

Counting pokemons... There are 12 fire type pokemons in the first generation without Mega evolutions.-

Per fer-ho en bash, podeu combinar les comandes grep, cut, wc i expr. Nota, l'argyment -v de grep exclou les línies que contenen el patró i la generació s'indica a la columna 12 amb el valor 1:

!/bin/bash echo "Counting pokemons..." n=`grep Fire pokemon.csv | grep -v "Mega" | cut -d, -f12 | grep 1 | wc -l` n=`expr $n - 1` echo "There are $n pokemons in the first generation without Mega evolutions."- Per fer-ho en AWK, teniu el negador ! per negar el patró:

awk -F, 'BEGIN { print "Counting pokemons..." } /Fire/ && !/Mega/ && $12 == 1 { ++n } END{ print "There are ", n, "fire type pokemons in the first generation without Mega evolutions." }' pokemon.csvEn aquest exemple, hem utilitzat l'operador lògic && per combinar dos patrons. Això significa que la línia ha de contenir el patró Fire i no ha de contenir el patró Mega. Això ens permet filtrar els Mega pokemons del nostre comptador. A més, hem utilitzat l'operador ! per negar el patró Mega. Això significa que la línia no ha de contenir el patró Mega. Finalment, hem utilitzat la clàusula {END} per imprimir el resultat final.

-

-

Indiqueu a quina línia es troba cada pokémon del tipus foc. Volem imprimir la línia i el nom del pokémon. La sortida ha de ser semblant a:

Line: 6 Charmander Line: 7 Charmeleon Line: 8 Charizard Line: 9 CharizardMega Charizard X Line: 10 CharizardMega Charizard Y ... Line: 737 Litleo Line: 738 Pyroar Line: 801 Volcanionon el format de cada línia és Line: n\tNom del pokémon.

-

En AWK podem fer servir la variable NR per obtenir el número de línia actual. A més a més, podeu formatar la sortida amb

print cadena,variable,cadena,variable,...:awk -F, '/Fire/ {print "Line: ", NR, "\t" $2}' pokemon.csv -

En bash:

#!/bin/bash while IFS=, read -r col1 col2 col3 rest; do ((line_number++)) # Check if the line contains the word "Fire" if [[ "$col2" == *"Fire"* || "$col3" == *"Fire"* ]]; then echo "Line: $line_number $col2" fi done < pokemon.csv

-

-

Implementeu un script que permeti comptar el nombre de pokemons de tipus foc i drac. La sortida ha de ser semblant a:

Fire:64 Dragon:50 Others:689-

En AWK:

awk -F, 'BEGIN{ fire=0; dragon=0; others=0 } /Fire/ { fire++ } /Dragon/ { dragon++ } !/Fire|Dragon/ { others++ } END{ print "Fire:" fire "\nDragon:" dragon "\nOthers:" others }' pokemon.csv -

En bash:

#!/bin/bash fire=0 dragon=0 others=0 while IFS=, read -r col1 col2 col3 col4 col5 col6 col7 col8 col9 col10 col11 col12 col13; do if [[ "$col3" == *"Fire"* || "$col4" == *"Fire"* ]]; then ((fire++)) fi if [[ "$col3" == *"Dragon"* || "$col4" == *"Dragon"* ]]; then ((dragon++)) fi if [[ "$col3" != *"Fire"* && "$col4" != *"Fire"* && "$col3" != *"Dragon"* && "$col4" != *"Dragon"* ]]; then ((others++)) fi done < pokemon.csv echo "Fire:$fire" echo "Dragon:$dragon" echo "Others:$others"

-

-

Imprimiu la pokedex amb una nova columna que indiqui la mitjana aritmètica dels atributs de cada pokémon. La sortida ha de ser semblant a:

#,Name,Type 1,Type 2,Total,HP,Attack,Defense,Sp. Atk,Sp. Def,Speed,Generation,Legendary,Avg 1,Bulbasaur,Grass,Poison,318,45,49,49,65,65,45,1,False,53 2,Ivysaur,Grass,Poison,405,60,62,63,80,80,60,1,False,67.5 3,Venusaur,Grass,Poison,525,80,82,83,100,100,80,1,False,87.5-

En AWK:

awk -F, '{ if (NR==1) print $0",Avg"; else print $0","($6+$7+$8+$9+$10+$11)/6 }' pokemon.csv -

En bash:

#!/bin/bash while IFS=, read -r col1 col2 col3 col4 col5 col6 col7 col8 col9 col10 col11 col12 col13; do if [[ "$col1" == "#" ]]; then echo "$col1,$col2,$col3,$col4,$col5,$col6,$col7,$col8,$col9,$col10,$col11,$col12,$col13,Avg" else avg=$((($col6+$col7+$col8+$col9+$col10+$col11)/6)) echo "$col1,$col2,$col3,$col4,$col5,$col6,$col7,$col8,$col9,$col10,$col11,$col12,$col13,$avg" fi done < pokemon.csvNota: Bash de forma nativa no permet operacions aritmètiques amb nombres decimals. Per fer-ho, cal utilitzar una eina com

bc. En aquest cas, podeu adaptar el codi per utilitzarbcquan calculeu la mitjana i fer servirprintfper formatar la sortida amb el nombre de decimals que vulgueu.

-

-

Cerca el pokémon més fort i més feble tenint en compte el valor de la columna 7 dels pokemons de tipus foc de la primera generació.

-

En AWK, assumiu que el valors de la columna 7 van de 0 a 100:

awk -F, 'BEGIN{ max=0; min=100 } /Fire/ && $12 == 1 { if ($7 > max) { max=$7; pmax=$2 } if ($7 < min) { min=$7; pmin=$2 } } END{ print "Weakest: "pmin "\nStrongest: "pmax }' pokemon.csv -

En bash:

#!/bin/bash max=0 min=100 while IFS=, read -r col1 col2 col3 col4 col5 col6 col7 col8 col9 col10 col11 col12 col13; do if [[ "$col3" == *"Fire"* ]] && [[ "$col12" == "1" ]]; then if [[ "$col7" -gt "$max" ]]; then max=$col7 pmax=$col2 fi if [[ "$col7" -lt "$min" ]]; then min=$col7 pmin=$col2 fi fi done < pokemon.csv echo "Weakest: $pmin" echo "Strongest: $pmax"

-

Awk - Avançat

Variables definides quan executem AWK

| Variable | Valor per defecte | Significat |

|---|---|---|

| RS | /n (Salt de línia) | Valor que fem servir per separar els registres (entrada) |

| FS | Espais o tabulacions | Valor que fem servir per separar els camps en l'entrada. |

| OFS | espai | Valor que fem servir per separar el camps en la sortida. |

| ORS | /n (Salt de línia) | Valor que fem servir per separar els registres (sortida). |

| ARGV | - | Taula inicialitzada amb els arguments de la línia de comandes (opcions i nom del script awk s'exclouen). |

| ARGC | - | Nombre d'arguments. |

| ENVIRON | Variables entorn | Taula amb les variables entorn exportades per la shell. |

Per exemple:

-

Transformeu el fitxer pokemon.csv en un fitxer amb els camps separats per tabulacions:

awk -F, 'BEGIN{OFS="\t"} {print $0}' pokemon_tab.csv -

Per fer servir el fitxer pokemon_tab.csv podem utilitzar els mateixos scripts que hem fet servir amb el fitxer pokemon.csv. Però indicant que el separador de camps és un tabulador. Per exemple, per comptar el nombre de pokemons lluitadors:

awk -F"\t" '/Fighting/ {print $2}' pokemon_tab.csv -

Si volem fer servir una variable entorn per indicar el tipus de pokemons que volem comptar, podem fer-ho així:

awk -F"\t" -v type=$TYPE '{ if ($3 == type) { print $2 } }' pokemon_tab.csvon $TYPE és una variable entorn que conté el tipus de pokemons que volem comptar.

Bucles

El llenguatge AWK també ens permet fer bucles accepta les següents estructures:

for (expr1;expr2;expr3) { acció }: Aquest bucle executa la primera expressió, després avalua la segona expressió i si és certa executa l'acció. Després executa la tercera expressió i torna a avaluar la segona expressió. Això es repeteix fins que la segona expressió sigui falsa.

Per exemple, transformeu el fitxer pokemon.csv en un fitxer amb els camps separats per ; utilitzant un bucle for:

awk -F, \

'BEGIN{OFS=";";}

{

for (i=1;i<=NF;i++)

printf("%s%s",$i,(i==NF)?"\n":OFS)

}' pokemon.csv

while (condició) { acció }: Aquest bucle executa l'acció mentre la condició sigui certa.

Per exemple, substituïu els camps del tipus de pokemon per un camps tipus compost per els dos tipus de pokemon separats per un / dels primers 10 pokemons:

awk -F, \

'BEGIN{OFS=",";}

{

while (NR>1 && NR <= 11) {

print $1, $2, $3 "/" $4, $5, $6, $7, $8, $9, $10, $11, $12, $13

getline

}

}' pokemon.csv

La comanda getline ens permet llegir la següent línia de l'entrada. Això ens permet llegir la següent línia dins del bucle while. Si no fem servir la comanda getline, el bucle while es quedaria en un bucle infinit ja que la condició NR <= 11 sempre seria certa.

do { acció } while (condició): Aquest bucle executa l'acció una vegada i després avalua la condició. Si la condició és certa, torna a executar l'acció.

Per exemple, utilitzeu el bucle do per comptar el nombre de pokemons de tipus foc:

awk -F, \

'BEGIN{print "Counting pokemons..."; n=0}

{

do {

if ($3 == "Fire" || $4 == "Fire")

n++

} while (getline)

}

END{print "There are ", n, "fire type pokemons."}' pokemon.csv

Instruccions de control:

break: Finalitza el bucle actual.continue: Salta a la següent iteració del bucle.next: Salta a la següent línia de l'entrada.

Per exemple:

-

Cerqueu la primera entrada que compleixi les següents condicions: el tipus de pokemon és "Fire" i la seva velocitat és més gran que 100:

awk -F, 'BEGIN {found = 0} { if (found == 0) { for (i=1; i<=NF; i++) { if ($i == "Fire" && $7 > 100) { print "El primer Pokémon de tipus Fire amb velocitat superior a 100 és: " $2; found = 1; break } } } }' pokemon.csvObservació:

breakfinalitza el bucle actual que recorre els camps de la línia. Per tant, ens permet deixar de buscar en una línia quan ja hem trobat el que volem. -

Cerqueu totes les entrades que compleixen les següents condicions: el tipus de pokemon és "Fire" i la seva velocitat és més gran que 100:

awk -F, '{ for (i=1; i<=NF; i++) { if ($i == "Fire" && $7 > 100) { print $2 } } }' pokemon.csvo bé

awk -F, '{ for (i=1; i<=NF; i++) { if ($i == "Fire" && $7 > 100) { print $2; break } } }' pokemon.csvObservació:

breakens permet que quan trobem un pokemon que compleix les condicions, no cal seguir buscant en la mateixa línia i podem passar a la següent. En aquest cas,nextseria equivalent abreak. -

Cerqueu tots els pokemons que són voladors i de foc assumint que les columnes poden estar en qualsevol ordre i que cada entrada pot estar ordenada de forma diferent:

awk -F, '{ for (i=1; i<=NF; i++) { if ($i == "Fire") { for (j=1; j<=NF; j++) { if ($j == "Flying") { print $2; next } } } } }' pokemon.csvObservació:

nextens permet que quan trobem un pokemon que compleix les condicions, no cal seguir buscant en la mateixa línia i podem passar a la següent.Observació:

breakens donaria el mateix resultat en aquest cas. Perònextés més eficient perquè no cal seguir recorrent els camps de la línia. La comandabreakseguiria recorrent els camps al bucle de la variable i.

Arrays

AWK també ens permet fer servir arrays. Per exemple, podem fer servir un array per comptar el nombre de pokemons de cada tipus:

awk -F, '

{

if (NR > 1) {

type1 = $3

type2 = $4

types[type1]++

if (type2 != "") {

types[type2]++

}

}

}

END {

for (type in types) {

print type, types[type]

}

}' pokemon.csv

Els arrays en AWK són associatius, és a dir, no cal indicar la posició de l'element en l'array. Per exemple, si volem comptar el nombre de pokemons de cada tipus per generació:

gawk -F, '

{

if (NR > 1) {

type1 = $3

type2 = $4

gen = $12

types[type1][gen]++

if (type2 != "") {

types[type2][gen]++

}

}

}

END {

for (type in types) {

printf "%s\n", type

for (gen in types[type]) {

printf " Gen %d: %d\n", gen, types[type][gen]

}

}

}' pokemon.csv

Nota: En aquest exemple, hem fet servir un array bidimensional. El llenguatge

awkno permet declarar arrays multidimensionals, per poder fer-lo servir necessitem la extensió gawk. Per instal·lar-la, podeu fer servir la comandaapt install gawkodnf install gawk.

Per fer-ho en AWK, podem utiltizar una clau combinada amb el tipus i la generació i la funció split per separar les dues claus:

awk -F, '

{

if (NR > 1) {

type1 = $3

type2 = $4

gen = $12

types[type1 " " gen]++

if (type2 != "") {

types[type2 " " gen]++

}

}

}

END {

for (typegen in types) {

split(typegen, temp, " ")

type = temp[1]

gen = temp[2]

printf "%s %d: %d\n", type, gen, types[typegen]

}

}' pokemon.csv | sort -k2 -n

Exercicis Avançats AWK

-

Implementeu un script que mostri la pokedex en ordre invers. Però mantenint la primera línia com a capçalera.

awk -F, ' { if (NR == 1) { print $0 } else { lines[NR] = $0 } } END { for (i = NR; i > 1; i--) { print lines[i] } }' pokemon.csv -

Implementeu un script que simuli la comanda

sort -t, -k5 -n pokemon.csv. Aquesta comanda ordena el fitxer pokemon.csv pel camp Total de forma numèrica. Podeu fer servir la funcióasortper ordenar els pokemons. Aquesta funció ordena un array i retorna el nombre d'elements de l'array ordenat. Per exemple:asort(array, sorted, "@val_num_asc")ordena l'array array de forma numèrica ascendent i guarda el resultat a l'array sorted.

A més, podeu fer servir la funció

splitque ens permet dividir una cadena de text en un array. Per exemple:split("a,b,c,d", array, ",")divideix la cadena de text "a,b,c,d" en l'array array amb els valors "a", "b", "c" i "d".

awk -F, ' { if (NR == 1) { print $0 } else { lines[NR] = $0 totals[NR] = $5 " " NR } } END { n = asort(totals, sorted, "@val_num_asc") for (i = 1; i <= n; i++) { split(sorted[i], temp, " ") line = temp[2] print lines[line] } }' pokemon.csv -

Implementeu un script que mostri una taula resum amb els pokemons de cada tipus a cada generació. Un exemple de la sortida esperada:

Tipus Gen 1 Gen 2 Gen 3 Gen 4 Gen 5 Gen 6 Normal 24 15 18 18 19 8 Dragon 4 2 15 8 12 9 Ground 14 11 16 12 12 2 Electric 9 9 5 12 12 3 Poison 36 4 5 8 7 2 Steel 2 6 12 12 12 5 Bug 14 12 14 11 18 3 Grass 15 10 18 17 20 15 Fire 14 11 9 6 16 8 Dark 1 8 13 7 16 6 Ice 5 5 7 8 9 4 Fighting 9 4 9 10 17 4 Water 35 18 31 15 18 9 Ghost 4 1 8 9 9 15 Flying 23 19 14 16 21 8 Rock 12 8 12 7 10 9 Fairy 5 8 8 2 3 14 Psychic 18 10 28 10 16 8 Notes:

- Els tipus de pokemons es troben a la columna 3 i 4 i la generació a la columna 12.

- Utilitzeu printf per formatar la sortida.

- En AWK:

awk -F, ' BEGIN { print "| Tipus | Gen 1 | Gen 2 | Gen 3 | Gen 4 | Gen 5 | Gen 6 |" print "|------------|-------|-------|-------|-------|-------|-------|" } { if (NR > 1) { type1 = $3 type2 = $4 gen = $12 types[type1][gen]++ if (type2 != "") { types[type2][gen]++ } } } END { for (type in types) { printf "| %-10s |", type for (gen = 1; gen <= 6; gen++) { printf " %-5s |", types[type][gen] ? types[type][gen] : 0 } print "" } }' pokemon.csv -

Implementeu un parser que transformi el fitxer

pokemon.csven un fitxerpokemon.json. Aquest fitxer ha de ser formatat de forma correcta. Podeu assumir que coneixeu els headers del fitxer i la tipologia de les seves dades. Per exemple, la primera línia del fitxer pokemon.csv ha de ser transformada en:{ "Name": "Bulbasaur", "Type 1": "Grass", "Type 2": "Poison", "Total": 318, "HP": 45, "Attack": 49, "Defense": 49, "Sp. Atk": 65, "Sp. Def": 65, "Speed": 45, "Generation": 1, "Legendary": false }- Una solució simple en AWK:

awk -F, ' BEGIN { print "[" } { if (NR > 1) { printf " {\n" printf " \"Name\": \"%s\",\n", $2 printf " \"Type 1\": \"%s\",\n", $3 printf " \"Type 2\": \"%s\",\n", $4 printf " \"Total\": %d,\n", $5 printf " \"HP\": %d,\n", $6 printf " \"Attack\": %d,\n", $7 printf " \"Defense\": %d,\n", $8 printf " \"Sp. Atk\": %d,\n", $9 printf " \"Sp. Def\": %d,\n", $10 printf " \"Speed\": %d,\n", $11 printf " \"Generation\": %d,\n", $12 printf " \"Legendary\": %s\n", $13 printf " }%s\n", (NR == 800) ? "" : "," } } END { print "]" }' pokemon.csv > pokemon.json- Una solució més complexa en AWK:

awk -F, ' BEGIN { print "[" } { if(NR == 1) { for (i = 2; i <= NF; i++) { headers[i] = $i } } else { if(NR != 2) { print " }," } printf " {\n" for (i = 2; i <= NF; i++) { if ($i ~ /^[0-9]+$/) { printf " \"%s\": %d,\n", headers[i], $i } else { printf " \"%s\": \"%s\",\n", headers[i], $i } } } } END { print " }\n]" }' pokemon.csv > pokemon.json -

Implementeu un script que permeti simular un combat entre dos pokémons. Els pokémons es passen com a variables d'entorn i han d'utilitzar el nom del pokémon a la pokedex. La lògica del combat és comparar els valors de velocitat per saber qui ataca primer. El pokémon que ataca primer és el que té més velocitat. Si els dos pokémons tenen la mateixa velocitat, el primer pokémon que s'ha passat com a variable d'entorn ataca primer. El combat es fa de forma alternada fins que un dels dos pokémons es queda sense punts de vida. El dany es mesura com (Atac - Defensa) multiplicat per un valor aleatori entre 0 i 1. Aquest es resta a la vida del pokémon oponent. La sortida ha de ser semblant a:

Charizard attacks first! Charizard attacks Charmander with 50 damage! Charmander has 20 HP left. Charmander attacks Charizard with 30 damage! Charizard has 70 HP left. Charizard attacks Charmander with 40 damage! Charmander has -10 HP left. Charmander fainted!- Una possible solució combinar AWK i bash:

#!/bin/bash # Get the pokemons from the command line arguments pokemon1=$1 pokemon2=$2 # Function to get stats of a pokemon get_stats() { awk -F, -v pokemon="$1" '$2 == pokemon { print $6, $7, $8, $9, $10, $11 }' pokemon.csv } # Get the stats of the pokemons stats1=$(get_stats $pokemon1) stats2=$(get_stats $pokemon2) # Extract the stats read hp1 attack1 defense1 spatk1 spdef1 speed1 <<< $stats1 read hp2 attack2 defense2 spatk2 spdef2 speed2 <<< $stats2 # Check who attacks first if [ $speed1 -gt $speed2 ]; then attacker=$pokemon1 hp=$hp2 defender=$pokemon2 attack=$attack1 defense=$defense2 else attacker=$pokemon2 defender=$pokemon1 hp=$hp1 attack=$attack2 defense=$defense1 fi echo "$attacker attacks first!" # Start the battle while true; do damage=$((($attack - $defense) * $RANDOM / 32767)) damage=${damage#-} hp=$(($hp - $damage)) echo "$attacker attacks $defender with $damage damage!" if [ $hp -le 0 ]; then echo "$defender has 0 HP left." echo "$defender fainted!" break else echo "$defender has $hp HP left." fi # Swap the attacker and defender tmp=$attacker attacker=$defender defender=$tmp tmp=$hp hp=$hp2 hp2=$tmp tmp=$attack attack=$attack2 attack2=$tmp tmp=$defense defense=$defense2 defense2=$tmp done

Repositori d'exercicis

Aquesta secció conté els exercicis realitzats pels estudiants de l'assignatura d'Administració i Manteniment de Sistemes i Aplicacions (AMSA).

Exercicis

Bàsics

Intermedis

Avançats

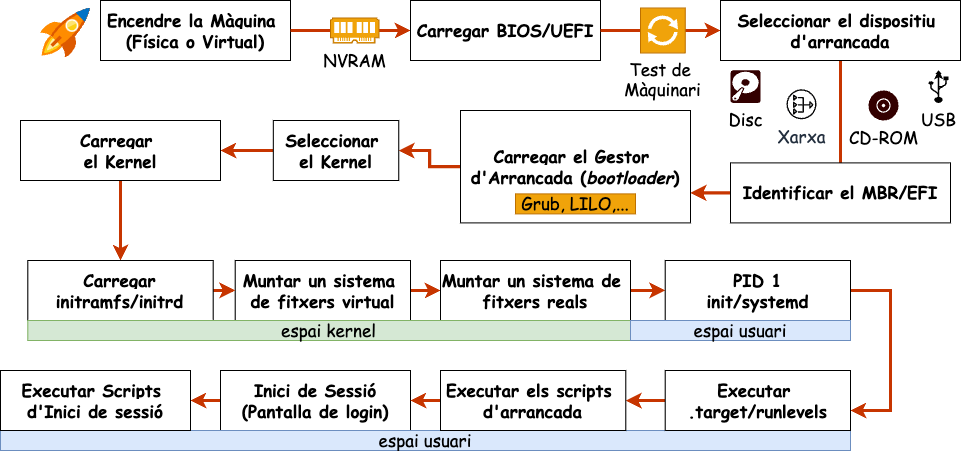

Arrancada del sistema

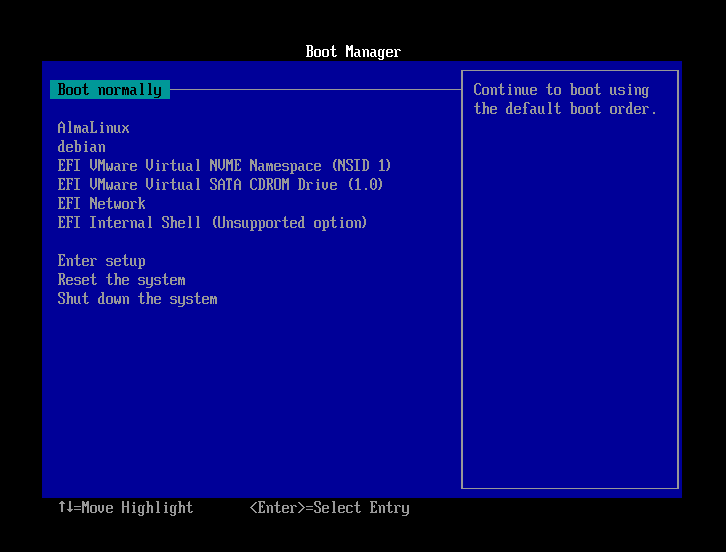

Quan arranquem un ordinador, tenen lloc una sèrie de processos que permeten que el sistema operatiu es carregui i es posi en marxa. Aquests processos són els que es coneixen com a arrancada del sistema. En un sistema linux, la seqüència d'arrancada es pot dividir en les següents fases:

-

Càrrega del BIOS o UEFI. Quan encenem l'ordinador, el primer programa que s'executa està emmagatzemat en una memòria no volàtil (NVRAM). Aquest programa pot ser el BIOS (Basic Input/Output System) en sistemes més antics o l'UEFI (Unified Extensible Firmware Interface) en sistemes més moderns. Aquest firmware és el responsable de gestionar les funcions bàsiques del sistema abans de carregar el sistema operatiu.

-

Test de l'ordinador. El BIOS o l'UEFI realitza un test de l'ordinador per assegurar-se que tots els components funcionen correctament. Aquest test s'anomena POST (Power-On Self Test). Si el test falla, l'ordinador emet una sèrie de senyals acústics o visuals per indicar quin component ha fallat.

-

Selecció del dispositiu d'arrancada. El BIOS o l'UEFI permet triar quin dispositiu volem utilitzar per a carregar el sistema operatiu. Aquest dispositiu pot ser el disc dur, un dispositiu USB, un CD-ROM, etc..

-

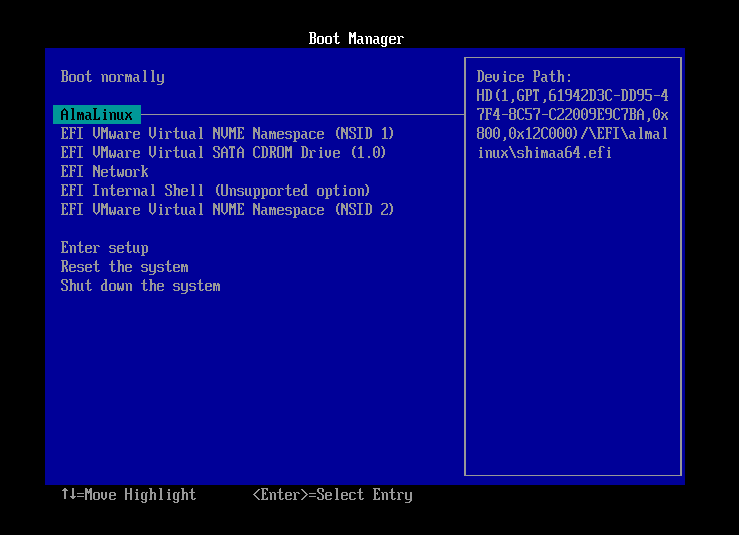

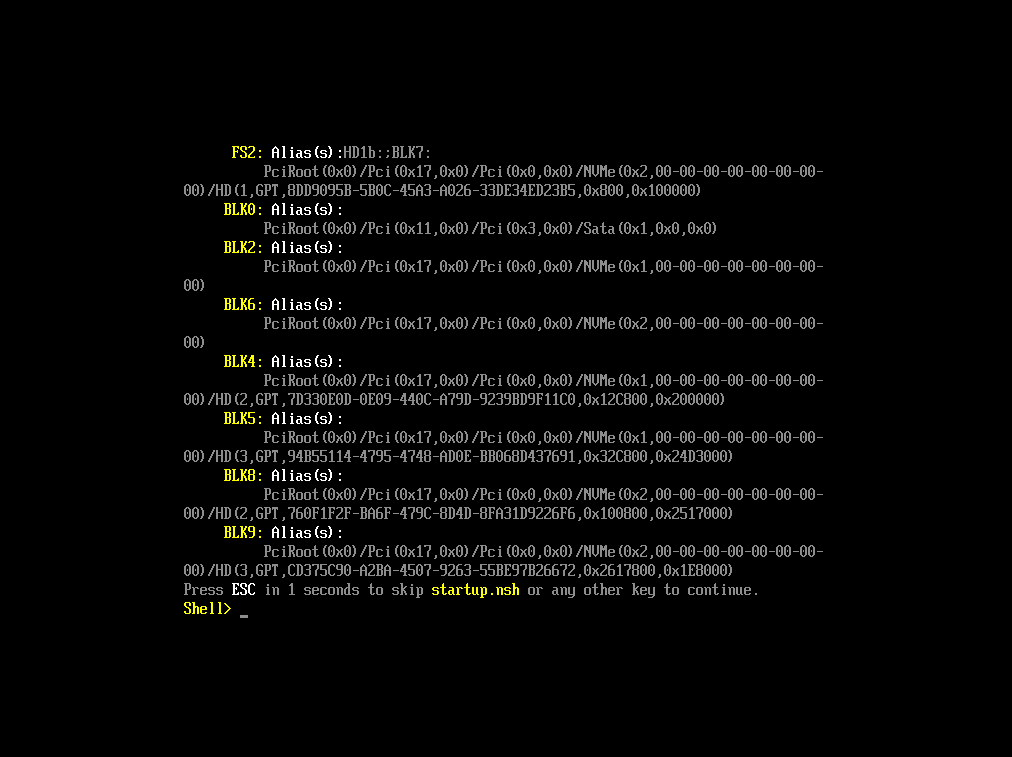

Identificació de la partició d'arrancada. El BIOS o UEFI localitza la partició d'arrencada del dispositiu seleccionat. En sistemes amb BIOS, es fa servir el Master Boot Record (MBR), mentre que en sistemes amb UEFI es fa servir la taula de particions GUID (GPT) per identificar la partició correcta (normalment, anomenada EFI). Aquesta partició conté el gestor d'arrencada i altres fitxers necessaris per continuar el procés d'arrencada.

-

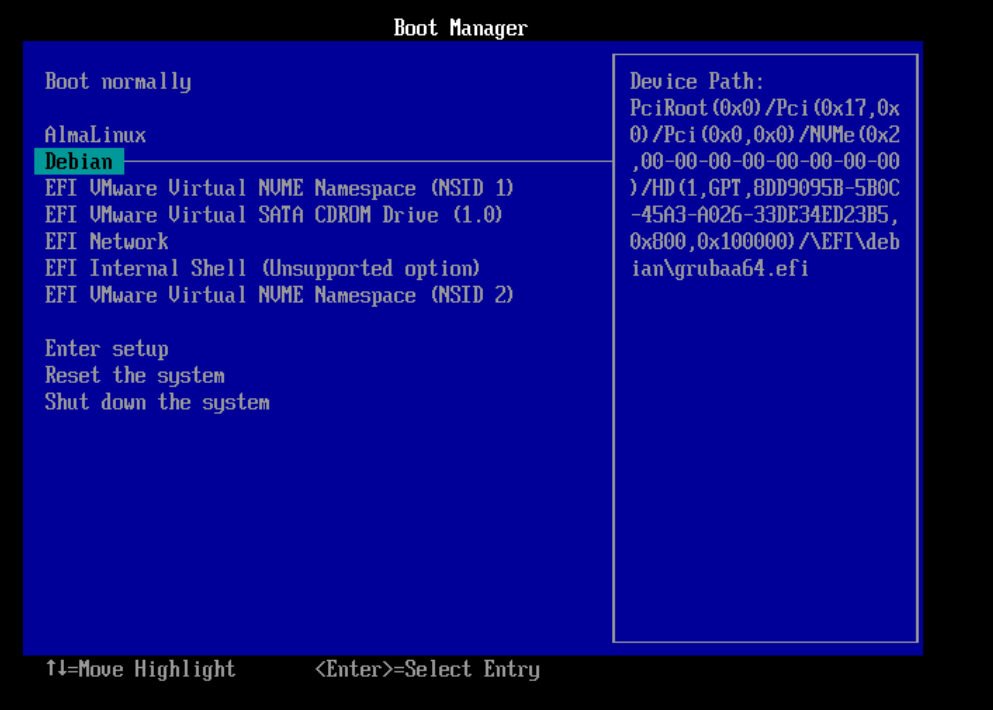

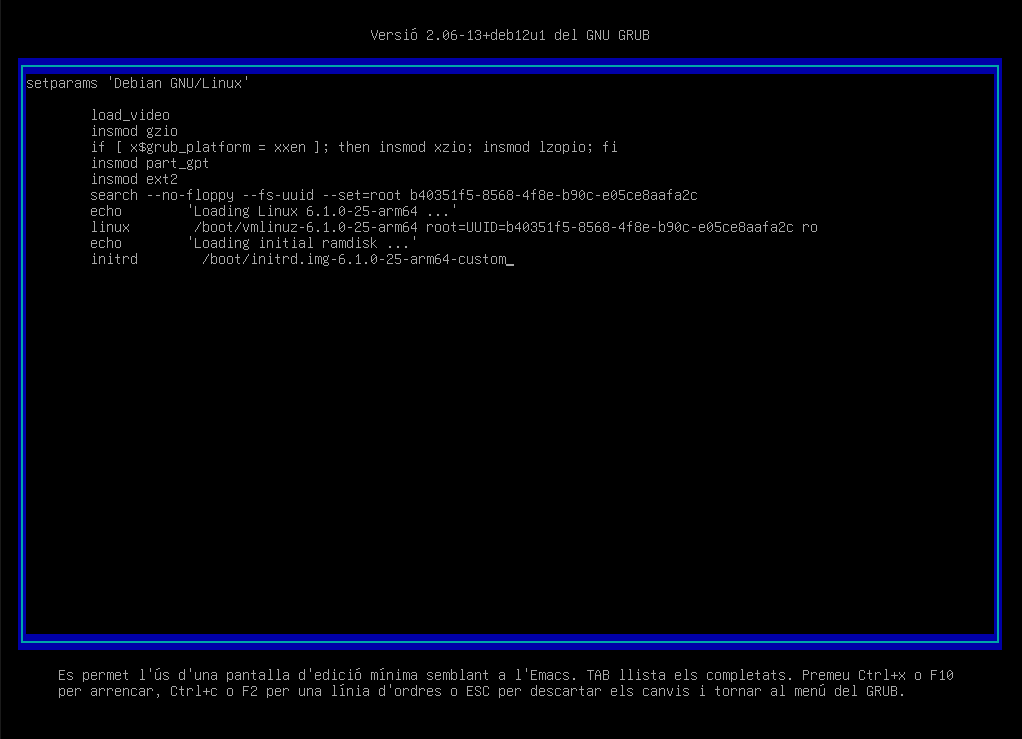

Càrrega del gestor d'arrancada. El BIOS o UEFI carrega el gestor d'arrencada. El gestor d'arrancada és un petit programa que permet triar quin sistema operatiu volem carregar. Els gestors d'arrencada més comuns en sistemes Linux són GRUB (Grand Unified Bootloader) o LILO (Linux Loader). Aquests gestors d'arrancada mostren una llista amb els sistemes operatius disponibles i permeten triar-ne un.

-

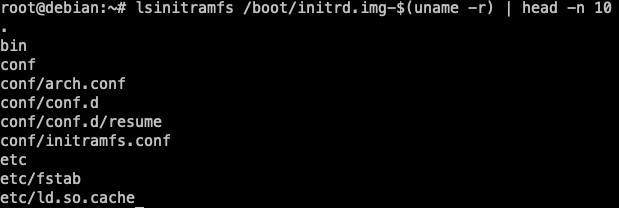

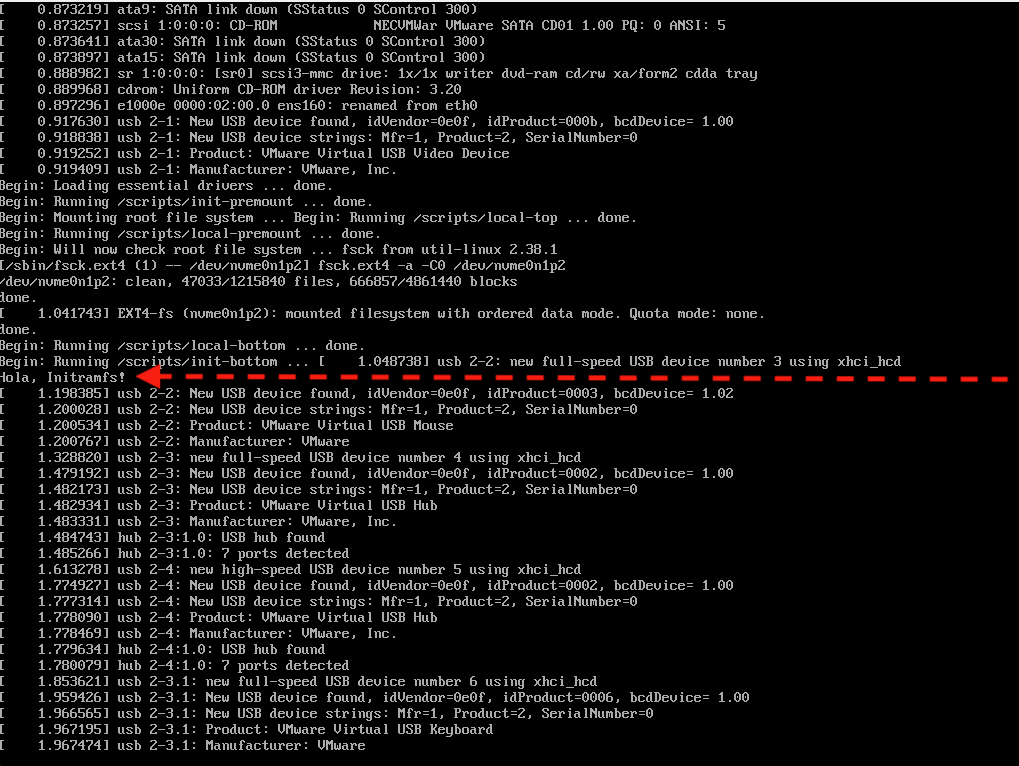

Càrrega del kernel. En aquesta fase, el gestor d'arrancada descomprimeix el codi del nucli i el carrega a la memòria.

-

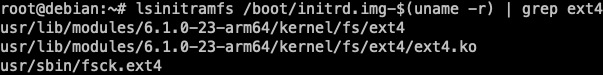

Càrrega del sistema de fitxers inicial. El nucli carrega un sistema de fitxers inicial (initramfs o initrd) que conté els mòduls i els programes necessaris per muntar el sistema de fitxers real del sistema operatiu.

-

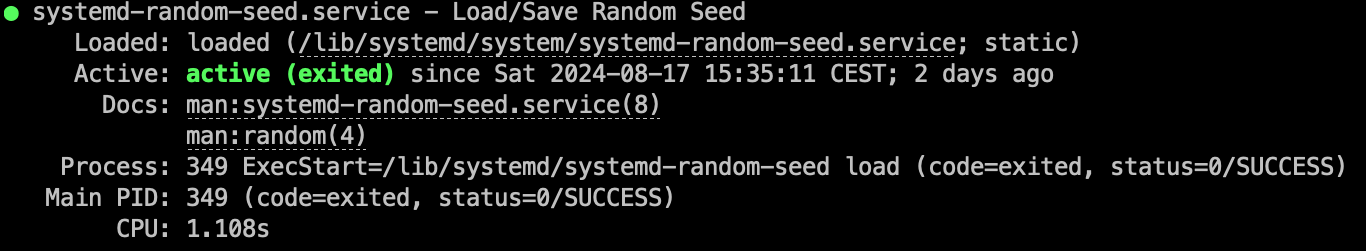

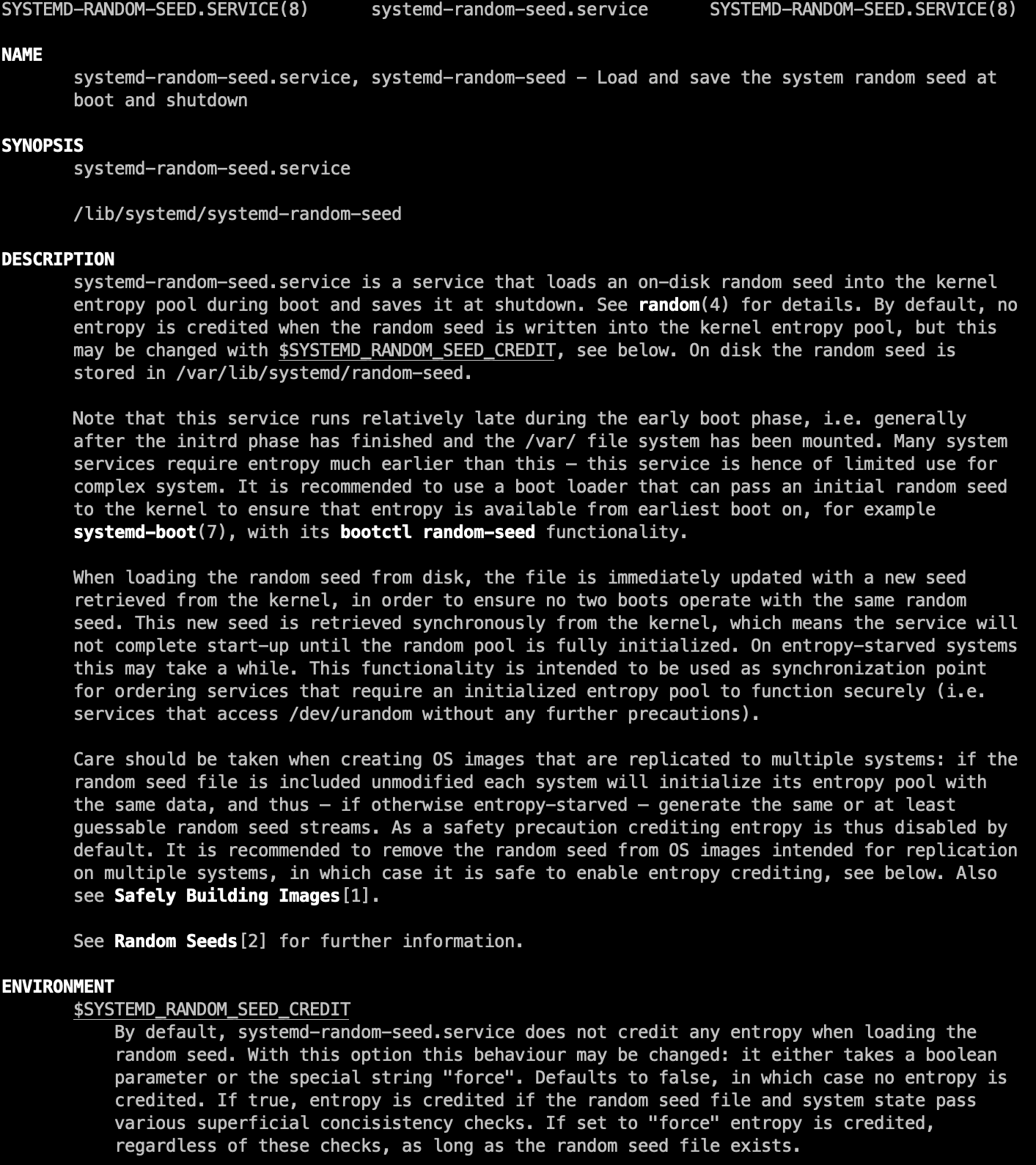

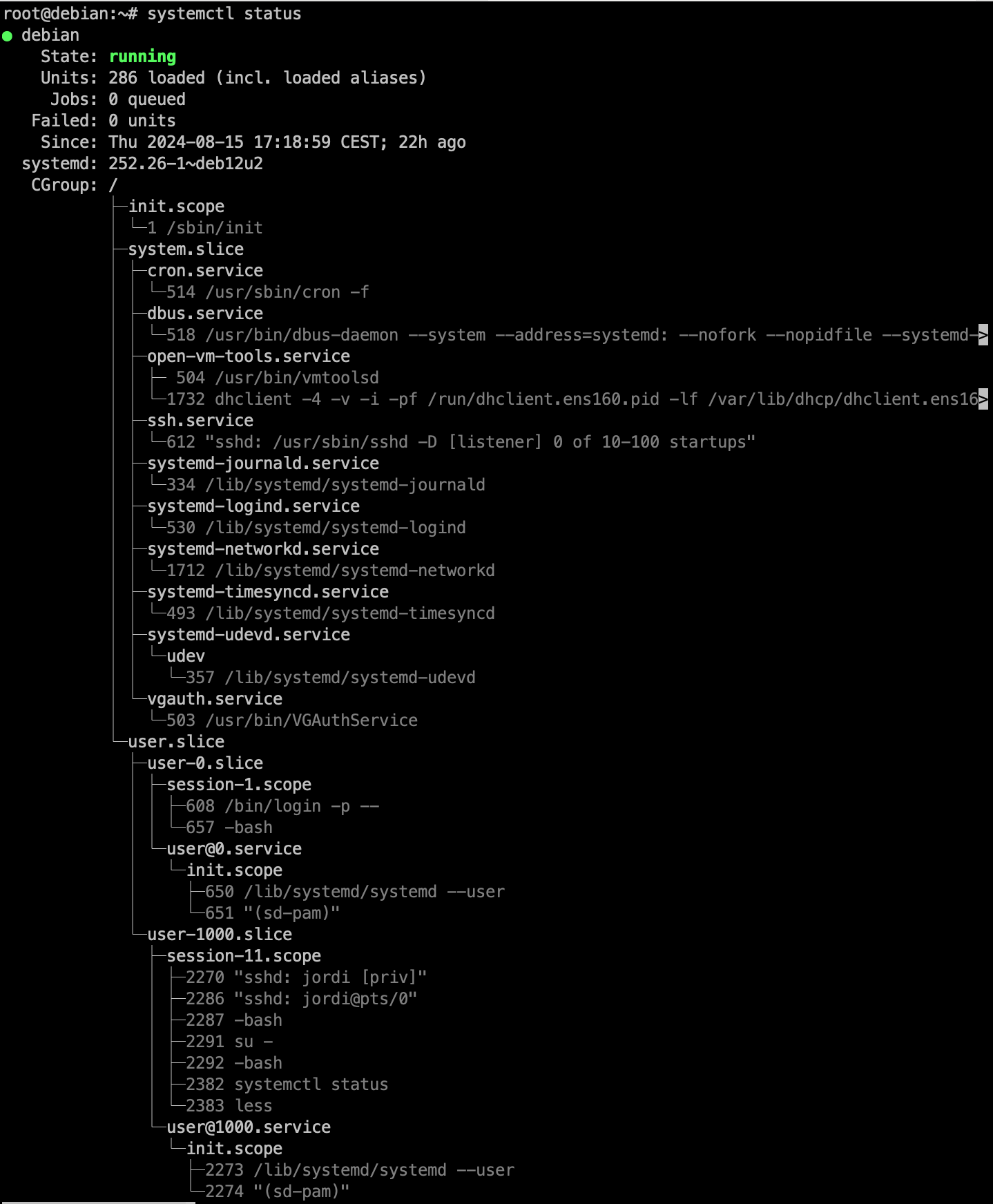

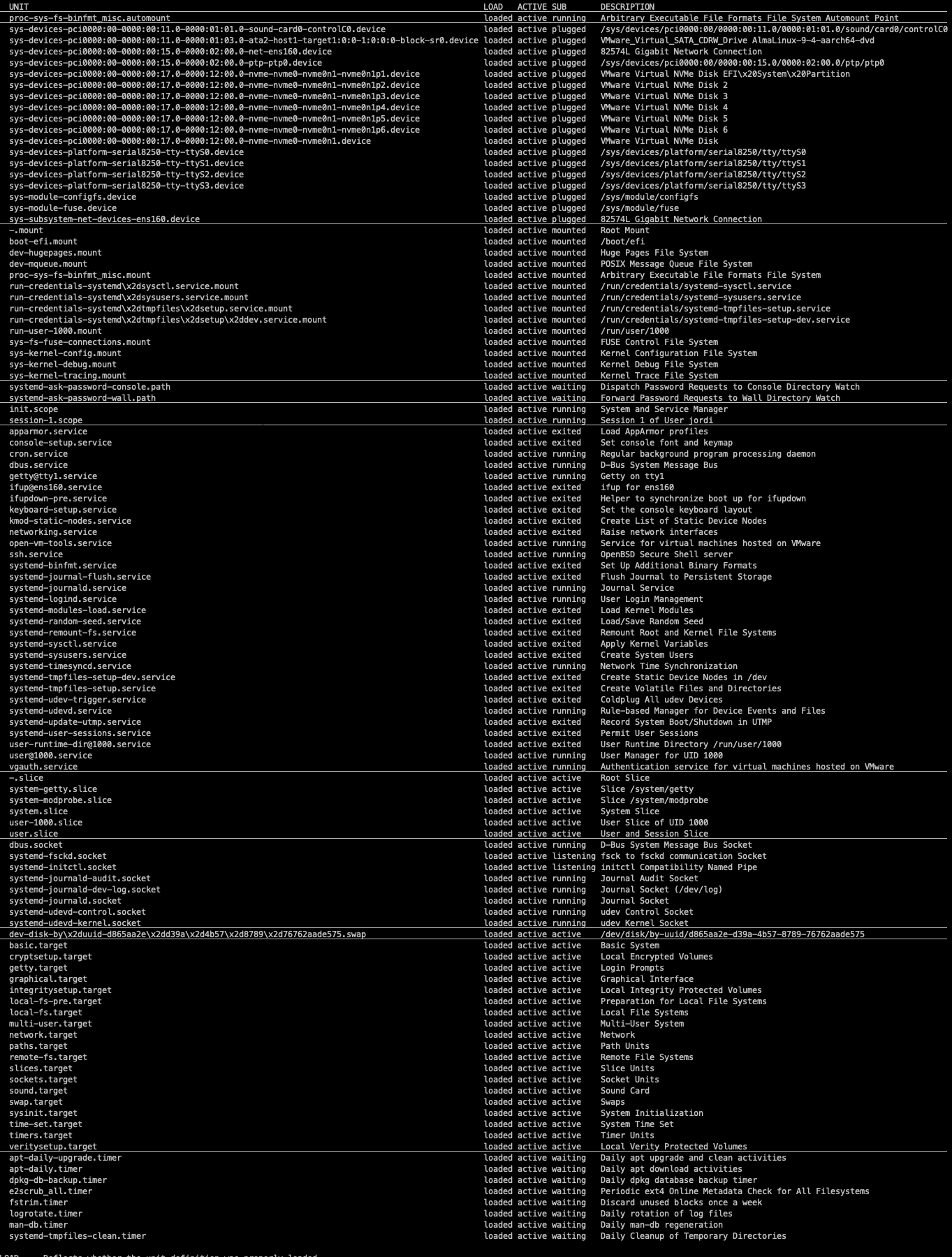

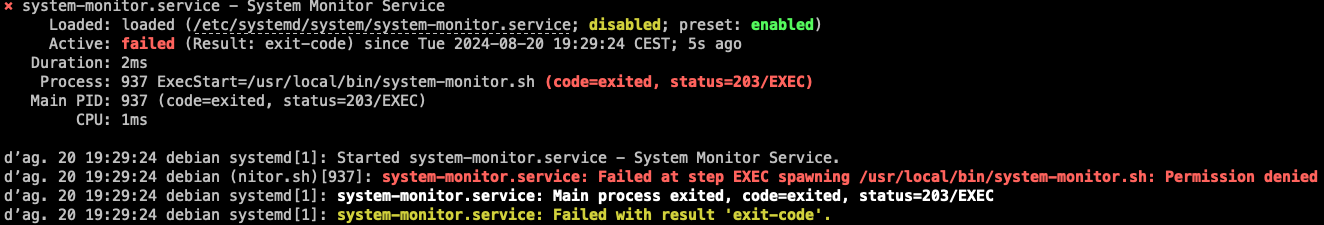

Sistema d'inicialització. És el primer procés que s'executa en un sistema operatiu en l'espai usuari. En el cas de GNU/Linux, el sistema d'inicialització més comú és el systemd. Una altre gestor d'arrancada, més vell però molt utilitzat és el SysVInit (Init).

-

Execució dels targets o runlevels. El sistema d'inicialització carrega els diferents targets o runlevels, que defineixen l'estat del sistema en un moment determinat. Aquests runlevels poden ser diferents nivells d'arrencada, com arrencada en mode gràfic o mode de recuperació. Cada runlevel pot tenir diferents serveis i daemons activats o desactivats.

-

Execució dels scripts d'arrancada. El sistema d'inicialització executa els scripts d'arrancada definits per a cada runlevel. Aquests scripts són responsables de configurar els serveis i daemons del sistema, com ara la xarxa, els dispositius de maquinari, els sistemes de fitxers, entre altres.

-

Inici de la Sessió d'Usuari. Finalment, el sistema està preparat per a l'usuari. Si el sistema està configurat per a un entorn gràfic, es carrega el gestor de finestres o l'entorn d'escriptori. En sistemes sense entorn gràfic, es presenta una línia de comandes. En aquest punt, l'usuari pot iniciar sessió i començar a utilitzar el sistema.

-

Execució dels scripts d'inici de sessió. Un cop iniciada la sessió, s'executen els scripts d'inici de sessió de l'usuari. Aquests scripts poden configurar variables d'entorn, carregar programes o configurar preferències de l'usuari. Això permet personalitzar l'experiència de l'usuari i preparar l'entorn de treball.

En aquest laboratori veurem totes aquestes fases en una màquina virtual i modificarem els paràmetres per veure com afecten als sistemes.

Objectius

- Entendre com funciona el procés d'arrancada del sistema.

- Conèixer els diferents components implicats en l'arrancada del sistema.

- Apendre a gestionar i optimitzar el procés d'arrancada.

Continguts

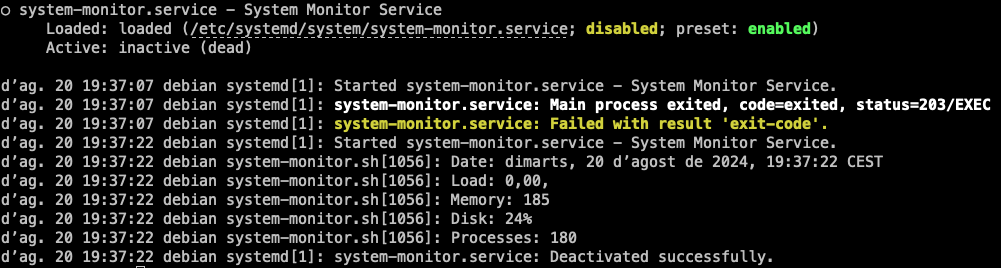

Activitats